Oggi con le attuali tecnologie non é possibile realizzare a un costo ragionevole un EXAscale computer, ovvero un computer in grado di gestire calcoli con moli di dati nell’ordine degli exabyte.

Per questo motivo Astron, l’istituto radio astronomico olandese, è stato attratto dalle potenzialità dei Microserver progettati all’IBM di Zurigo e ha avviato una collaborazione con il progetto Dome.

Dome sta esplorando le potenzialità di questa tecnologia per realizzare a un costo ragionevole un computer in grado di analizzare i dati che verranno generati dal radiotelescopio Ska e che arriveranno ad essere circa 1 Pbyte al giorno.

Ska sarà il più grande e potente radiotelescopio mai prodotto, volto a studiare alcuni dei misteri del universo.

Matteo Cossale è un dottorando presso i gruppi di Could Server Technologies e Advanced Micro Integration del Laboratorio di ricerca IBM a Zurigo, dove si occupa di electronic packaging per Microserver ad alta efficienza.

L’idea del microserver è nata da una serie di nuove esigenze che si stanno presentando nell’industria dei semiconduttori, prima fra tutti il consumo di energia.

Il progressivo aumento dei dati da gestire e analizzare richiede un numero sempre crescente di risorse nei datacenter. E oggi il 2% dell’energia globalmente prodotta viene consumata nei datacenter, con un conseguente impatto ambientale notevole. L’energia usata in un datacenter è tale che il suo costo supera facilmente quello dell’hardware, che si è ridotto notevolmente anche per effetto di una concorrenza sempre più accesa.

Da un lato c’è la legge di Moore, le cui previsioni iniziali da anni non possono più essere rispettate. Per poter garantire l’aumento delle capacità di calcolo, si è scelto di impiegare le tecnologia multicore, che prevede l’integrazione della maggior quantità possibile di core in ogni singolo processore.

Ha conseguito una doppia laurea magistrale in Nanotecnologie per le ICTs presso il Politecnico di Torino, il Politecnico di Grenoble (Grenoble INP) ed il Politecnico di Losanna (EPFL).

Ciò ha portato a un aumento vertiginoso del consumo di energia e ad altri svantaggi come l’affidabilità (o resiliance wall), la difficoltà a livello di software di usare al meglio tutti i core (o multicore programming wall), il Von Neumann bottleneck (o memory wall), ovvero il limite fisico sulla quantità di informazioni che possono essere trasferite tra la CPU e la memoria RAM.

Dall’altro lato, abbiamo assistito a molti progressi nello sviluppo dei sistemi embedded, come si è verificato per esempio nei processori degli smartphone. Questi processori sono espressamente progettati con lo scopo di massimizzare la loro efficienza piuttosto delle loro prestazioni. In questa categoria, i processori che impiegano l’architettura ARM a 64bit, sono adatti per la realizzazione di una nuova categoria di Microserver per applicazioni business.

Ha iniziato a lavorare all’IBM Ricerca nel 2012 come tesista presso il laboratorio IBM di San José.

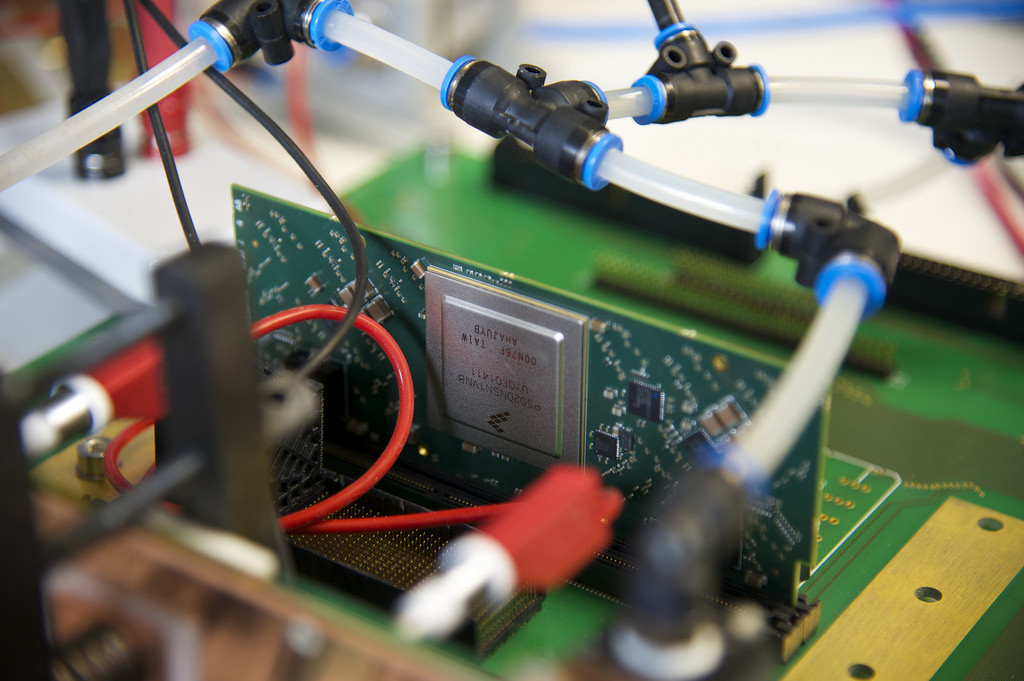

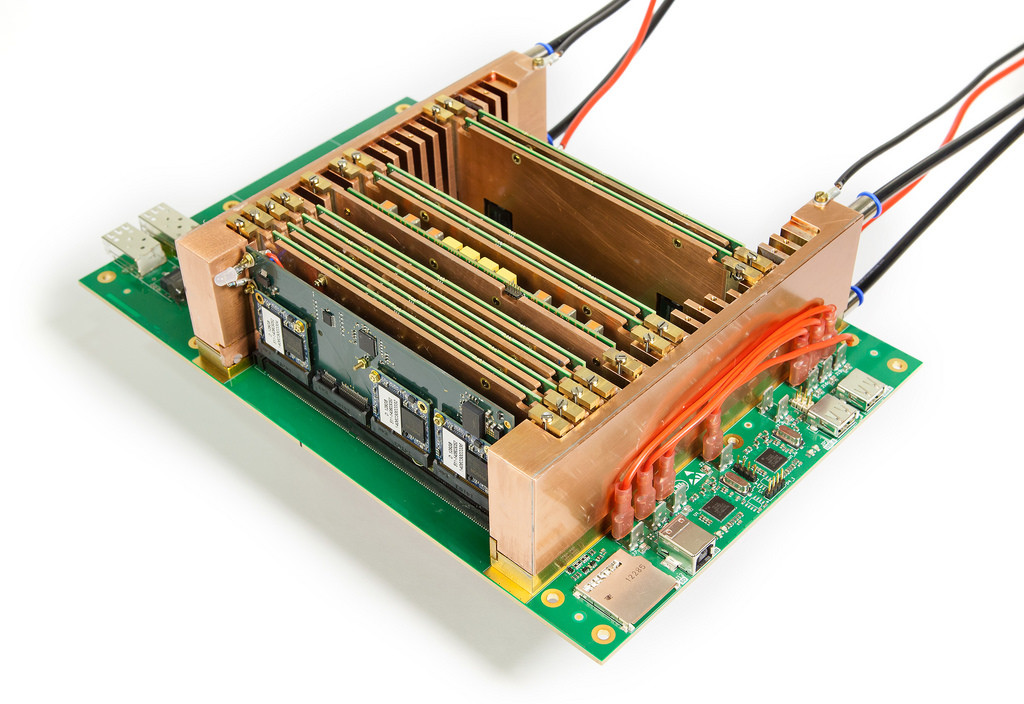

Il Microserver è una scheda che integra tutte le funzionalità di un server tradizionale. Molte di queste schede vengono integrate in una scheda madre, insieme a moduli di memoria di massa (Microstorage) e moduli switch (Microswitch) grazie a una tecnologia di raffreddamento ad acqua calda ispirata al sistema circolatorio del corpo umano.

Quest’ultima impiega un’unica infrastruttura che si occupa sia del raffreddamento sia dell’erogazione dell’energia. Ciò permette di realizzare Microdatacenter della dimensione di una scatola per pizza, con una densità superiore di almeno 20 volte rispetto a un computer standard, con un notevole risparmio anche di spazio.

Per capire quanto sia importante la densità di un computer al fine della sua efficienza, basta pensare che nei computer moderni il 98% dell’energia viene impiegata nel trasporto dei dati in lunghe interconnessioni tra chip; per cui, aumentando la densità, la lunghezza delle interconnessioni diminuisce, e di conseguenza il consumo di energia a esse legato.

Se si pensa poi che il 90% del volume di un computer è occupato dall’aria necessaria per il suo raffreddamento, si capisce quanto sia utile l’utilizzo di raffreddamenti a liquido in modo da occupare questo volume altrimenti lasciato vuoto.

Inoltre il raffreddamento ad acqua calda permette di consumare un ulteriore 40% in meno rispetto a un raffreddamento ad aria tradizionale.

Il concetto di Microdatacenter è quello di avere un sistema distribuito su un elevato numero di nodi con consumi ridotti al posto di un sistema altamente concentrato in pochi nodi ad alte prestazioni e alte potenze.

Questo permette un aumento dell’efficienza fino a 10 volte rispetto a un computer tradizionale con processori e architettura X86, a parità di prestazioni aggregate.

Oltre all’ambito del calcolo scientifico, questa tecnologia può essere impiegata anche per applicazioni di cloud computing e Cognitive Internet-of-Things (IoT); grazie alle sue dimensioni compatte e al minimo consumo energetico dispositivi basati su questa tecnologia possono essere installati in luoghi difficilmente accessibili rendendo possibile l’analisi dei dati là dove vengono generati.

Il costo di questo sistema inoltre è molto minore rispetto a sistemi tradizionali, poiché vengono impiegati unicamente componenti commodity.

In fondo a nessuno importa che computer viene utilizzato, interessa solo il tempo e il costo richiesto per ottenere un certo risultato.

[…] Come si può ridurre il consumo di energia dell'It […]