Google Cloud ha pubblicato sia un articolo sulle best practice di Google Kubernetes Engine (GKE) per ridurre l’over-provisioning sia una guida sul monitoraggio dei cluster GKE per l’ottimizzazione dei costi.

L’azienda ha però voluto compiere un passo ulteriore con l’introduzione, al momento in preview, dei cost optimization insights per GKE.

Questo nuovo strumento porta un po’ di quella teoria direttamente nell’interfaccia di Google Kubernetes Engine, aiutando i team a trovare il giusto equilibrio tra costi e prestazioni per i propri cluster e carichi di lavoro GKE.

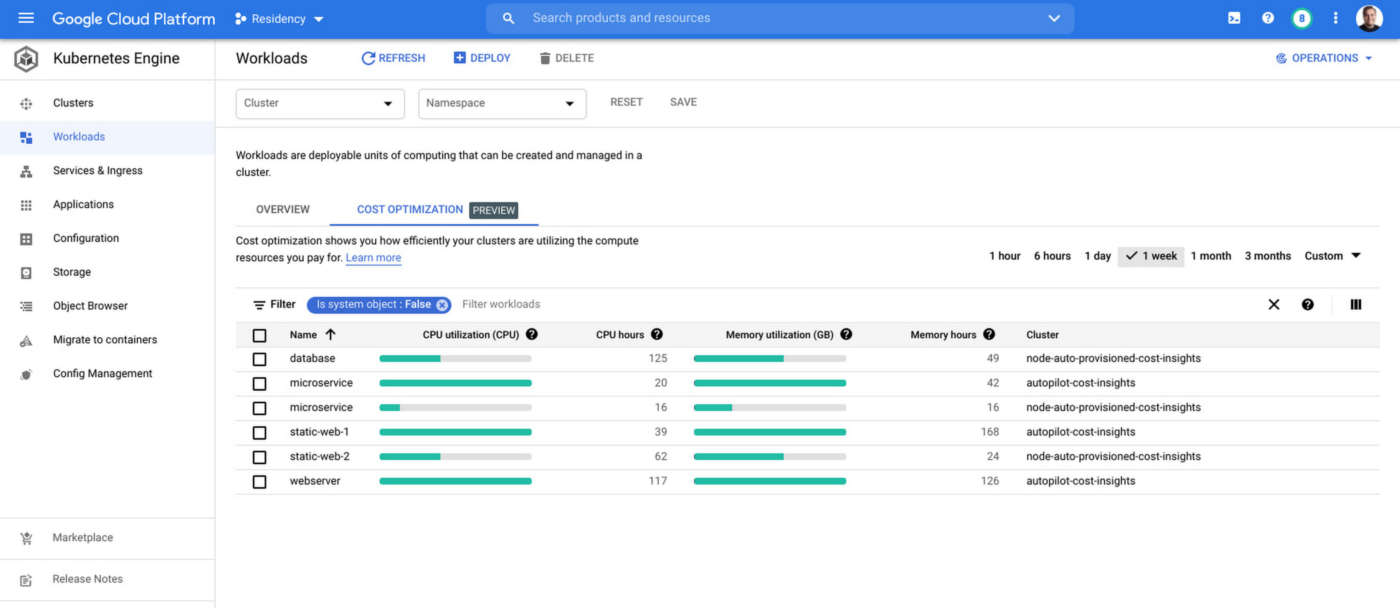

Con questa release, è possibile vedere quanto efficacemente i propri cluster e workload utilizzano le risorse di calcolo che l’impresa paga.

Una nuova scheda di ottimizzazione dei costi su entrambe le pagine dei cluster e dei workload di GKE permette di visualizzare, filtrare e imparare di più sulla quantità di CPU e di memoria che ciascuno dei propri cluster e carichi di lavoro sta utilizzando e richiedendo.

Nella pagina del cluster, è possibile anche vedere la quantità totale di risorse allocabili e, nella pagina dei carichi di lavoro, qualsiasi limite di risorse che è stato impostato per risorse di calcolo specifiche.

Le visualizzazioni dei dati – ha messo in evidenza Google Cloud – aiutano a identificare rapidamente qualsiasi area di scostamento tra la quantità di risorse che si sta allocando o richiedendo e la quantità che si sta effettivamente utilizzando.

Con queste informazioni, è possibile poi ridimensionare le assegnazioni o le richieste di risorse per controllare i costi e mantenere le prestazioni.

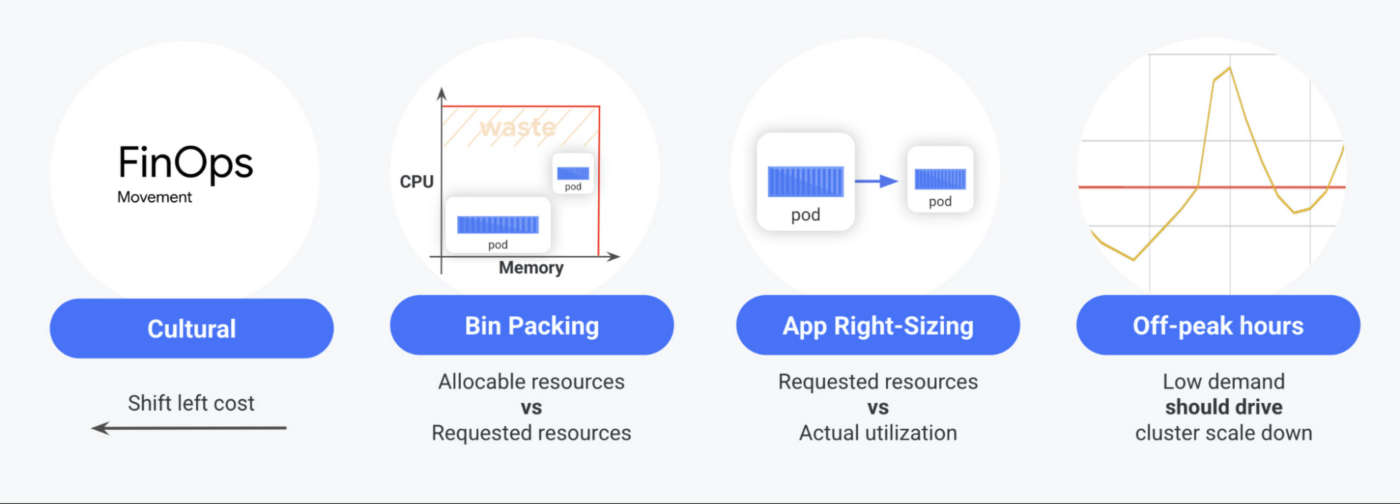

Ci sono quattro cose importanti da considerare quando si tratta di eseguire i carichi di lavoro Google Kubernetes Engine in modo efficiente, sottolinea Google Cloud: lo shift culturale verso FinOps, il corretto bin packing, il right-sizing delle app e il downscaling basato sulla domanda.

Per quanto riguarda il primo punto, molti team che adottano il cloud pubblico non hanno mai lavorato con una piattaforma pay-as-you-go come GKE, quindi non hanno familiarità con il modo in cui l’allocazione delle risorse e i processi di deployment delle app possono influenzare i loro costi.

I nuovi insight di ottimizzazione dei costi di Google Kubernetes Engine possono aiutare i team a valutare i compromessi aziendali tra costi e prestazioni.

Riguardo al secondo punto, più efficientemente si esegue il packing delle app nei nodi, più si risparmia. È possibile farlo in modo efficiente assicurandosi di allocare e richiedere la giusta quantità di risorse in base all’utilizzo effettivo.

Inoltre, più si è precisi nell’impostare quantità accurate di risorse per i propri pod, più affidabile sarà l’esecuzione delle applicazioni e, nella maggior parte dei casi, più spazio si aprirà nel cluster.

Infine, per risparmiare sui costi durante i periodi di bassa richiesta, i propri cluster dovrebbero essere in grado di ridimensionarsi con la domanda. Tuttavia, in alcuni casi non è possibile ridimensionare perché ci sono carichi di lavoro che non possono essere spenti o perché un cluster è stato mal configurato.