Dietro il traguardo di avere a disposizione informazioni utili a svolgere la propria attività o raggiungere un obiettivo si nasconde un processo lungo e articolato dalla loro formazione fino alla rappresentazione finale. Se sul lato utente contano soprattutto disponibilità e velocità, l’oscuro lavoro alle spalle è una sfida tra le più impegnative. Resa possibile grazie anche a intuizioni non comuni. «Siamo nati come azienda di data integration – spiega Andrea Zinno, Data Evangelist di Denodo – e, più in generale, di logical Data Management, sviluppando il concetto di virtualizzazione dei dati, e più in generale quello delle architetture logiche».

Principio certamente non tra i più semplici da comprendere e soprattutto inquadrare in tutto il suo potenziale. Dai benefici tuttavia importanti nell’ottica di una strategia di gestione dei dati efficace, affidabile e sicura. In estrema sintesi, virtualizzare un dato significa connetterlo, integrarlo e consegnarlo solo quando strettamente necessario, lavorando il più possibile a livello logico e gestire il livello fisico solo quando necessario.

Come facile prevedere, la realizzazione è tutt’altra cosa. Il merito di Denodo, esserci riuscita. «La nostra piattaforma di data management è assolutamente trasversale e agnostica rispetto all’uso – prosegue Zinno –. Questo ci permette tra l’altro un parco clienti molto variegato.

Se in Italia al momento la maggior parte dei riscontri arrivano dal mondo PA e dal finance, soprattutto per contatti ereditati da esperienze precedenti, la flessibilità dell’offerta è tale da rivelarsi interessante per chiunque tratti grandi quantità di dati e voglia trarne vantaggi contando su un’organizzazione più snella.

Partendo da presupposti ormai consolidati di come la crescita progressiva nelle informazioni da elaborare, la loro diversità e la distribuzione in continua evoluzione, garantire velocità di accesso e affidabilità è ben diverso rispetto a solo pochi anni fa dove i dati erano quasi tutti concentrati in uno o pochi ambienti. Al tempo stesso, non più di accesso esclusivo a un ristretto gruppo di addetti ai lavori, ma da rendere disponibili a tante figure diverse, in luoghi diversi e con esigenze diverse.

Come funziona la virtualizzazione del dato

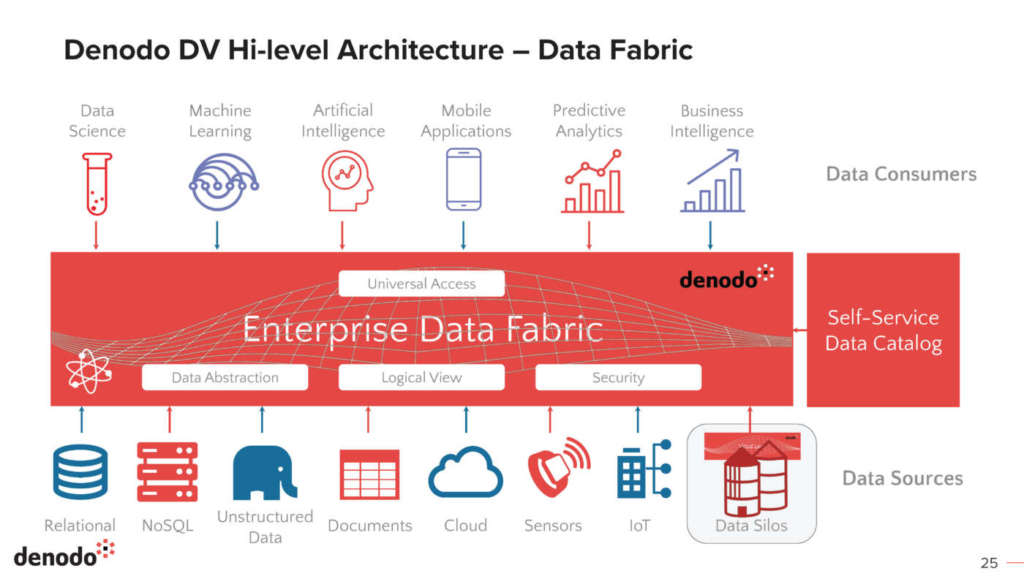

Nel modello classico, i dati sono prodotti residenti su una serie imprecisata di sorgenti e server, dai quali vengono raccolti, in pratica replicati, per essere poi messi al servizio di chi li deve elaborare per produrre dei risultati. Tre passaggi con relativi colli di bottiglia e perdite di tempo e spazio. L’idea di Denodo è collocarsi nel mezzo per mantenere da una parte riferimenti aggiornati ai dati e dall’altra essere pronti a fornire il relativo valore all’utente finale solo nel momento in cui sia realmente necessario.

«L’obiettivo è fornire un unico punto di accesso ai datti, condizione necessaria ma non sufficiente per sfruttarli a dovere. Ci occupiamo noi di affrontare la complessità architetturale figlia di stratificazioni ed epoche diverse. D’altra parte, nessuna azienda può permettersi di buttare tutto e ricominciare da capo ogni volta esca un nuovo paradigma».

Dai vari silos cresciuti nel tempo, ai primi data warehouse e i successivi data lake, nel tempo complessità e costi nella gestione dei dati sono solo cresciuti. Spesso, con ripercussioni sulla loro fruibilità e causando un problema ben più importante. «Il vero ostacolo è riuscire a tenerli aggiornati. Superare la latenza temporale richiede risorse, con relativi costi e, non da ultimo, un impatto sulla sostenibilità con relativi consumi energetici».

Un problema intuito da Denodo in tempi non sospetti. Una lungimiranza utile a sviluppare per tempo una soluzione abbastanza flessibile da adeguarsi nel tempo. «La nostra architettura logica è da considerarsi complementare a quella fisica tradizionale. L’intuizione è stata trovare un modo per rendere l’integrazione dei dati più snella, agile e in linea con le esigenze attuali».

Mentre usualmente componente fisica e logica, come i metadati, sono un elemento unico, la visione alternativa è scindere questi due aspetti. Capire cioè quando e come serva un’informazione per procedere al suo trasferimento solo in quel momento. In questo modo, i dati vengono prelevati dalle fonti dove risiedono solo quando necessario. Non serve più di conseguenza replicare o copiare il dato preventivamente, né allinearlo a seguito di ogni aggiornamento.

«È un po’ come in una biblioteca, dove prima di andare a cercare un libro sugli scaffali è utile poter consultare un catalogo. Capisco prima di tutto se posso trovare ciò di cui ho bisogno e soprattutto come recuperarlo».

Un software così concepito si rivela anche più flessibile nel costruire una dashboard personalizzata al servizio di un’applicazione. Solo una volta completata la configurazione, è necessario provvedere all’effettiva disponibilità dei dati indicati.

Tutto quanto si trovi alle spalle, dai dati di un gestionale a quelli di un sistema di CRM, fino a quelli generati da sensori IoT o non strutturati in arrivo dai social network, diventa così completamente trasparente all’utente. Una volta connesso ad una sorgente dati, quelli compatibili sono circa centosessanta, Denodo ne memorizza la rappresentazione logica del dato, all’occorrenza relazionandola con altre, sfruttando le informazioni fornite dalla sorgente stessa. È possibile combinarle in modo da ottenere più visuali e definire nuovi attributi. «Di tutto questo ce ne occupiamo noi. L’utente non ha alcuna necessità di conoscere altri formalismi o linguaggi di rappresentazione. Il sistema può essere visto come un database logico, con all’interno solo uno schema».

Dati a misura di utente

Come i dati, anche gli utenti sono diversi tra loro. Per questo, l’applicazione offre due modalità di interfaccia principali. Una prima più tecnica, rivolta ai Data Engineer, con competenze più spinte, in grado di lavorare in autonomia sulle correlazioni e l’integrazione. Una maggiore libertà d’azione, con il vantaggio di procedure low-code. Dall’altra parte, l’utente più legato alle analisi vere e proprie, senza doversi occupare dei dettagli tecnici. «Parliamo di persone con grande competenze sui dati della rispettiva divisione aziendale. Sanno cosa gli serve e cosa devono fare, ma non vogliono perdere tempo nell’imparare formalismi o a inseguire i dati».

Come facile prevedere, a questo punto entra in gioco anche la tecnologia più attuale. Un ulteriore passo in avanti in termini di efficienza si raggiunge con l’intelligenza artificiale. Algoritmi in grado di suggerire dati di potenziale interesse sulla base di quelli utilizzati in precedenza. «Il nostro utente deve potersi concentrare sull’obiettivo da raggiungere attraverso i dati. Il nostro compito è permettergli di focalizzarsi solo sugli aspetti interanti, non su quelli tecnici».

Sempre in quest’ottica, l’imminente versione Denodo 9 inserirà funzioni ci auto tagging, utili per proporre una classificazione automatica sulla base del tipo di dato. Inoltre funzioni per suggerire relazioni in base al nome delle sorgenti o al contenuto. Funzioni utili tra l’altro in fase di consolidamento di informazioni provenienti da sorgenti diverse.

Anche la sicurezza ci guadagna

Già presente invece da tempo, una sorta di sicurezza intrinseca. La struttura stessa di una visone logica dei dati agevola l’amministratore del sistema nel mascherare e filtrare le informazioni visibili alle varie categorie di utenti, o visualizzare solo gli aggregati, senza intervenire fisicamente sugli archivi. L’operazione avviene on-the-fly, solo nel momento in cui viene consegnato.

Per quanto lineare, tanta teoria ha però bisogno di essere tradotta in pratica con la dovuta concretezza. Un esempio particolarmente significativo riguarda quei casi dove, nella rappresentazione integrata del cliente o del cittadino, sia necessario poter disporre, per alcuni suoi attributi, del dato più recente (si pensi, ad esempio, al dato che rappresenta l’ultima azione fatta sui diversi canali di contatto), cosa che in uno scenario tradizionale di integrazione dati è molto difficile avere, per il fatto che i dati vengono replicati preventivamente e quindi la loro “freschezza” dipende da quando è stato fatto l’ultimo aggiornamento. Un approccio logico, al contrario, consente di valorizzare tali attributi prendendo il dato direttamente dal sistema operazionale che lo gestisce, con evidenti benefici sulla sua rappresentatività e, di conseguenza, sulla qualità del servizio che l’azienda è in grado di erogare.

Grandi idee per grandi progetti

Per forza di cose, un’offerta almeno inizialmente rivolta ad aziende medio e grandi, le stesse dove in genere risiede anche una certa complessità nelle architetture dati. «Tra i tanti nomi che possiamo vantare, Insiel e Istat sono di pubblico dominio. Entrambi nella PA, dove diversi altri ci hanno già contattato, ma lavoriamo anche con cinque tra le prime dieci banche in Italia».

Su scala internazionale, significativo invece il caso Intel. In occasione delle frequenti acquisizioni, negli USA è fondamentale garantire comunque il pagamento degli stipendi a tutti i dipendenti ogni quindici giorni. Anche l’integrazione della parte amministrativa deve rispettare la scadenza, pena il rischio di denunce. Missione difficile, ma completata con successo grazie alla rapidità di adozione di Denodo.

L’intenzione, in parte già tradotta in pratica con la disponibilità sui marketplace di piattaforme tra cui AWS, Azure e Google, di renderla disponibile anche a realtà più piccole alle prese con difficoltà nella gestione dei dati, deve comunque fare i conti con costi di utilizzo di una certa importanza, che dipendono dalla potenza di calcolo impegnata e non dal volume dei dati.

«Per aiutare il cliente a capire cosa di cui ha esattamente bisogno eseguiamo delle Proof of Concept direttamente sui suoi sistemi – conclude Andrea Zinno –. In pratica, significa offrire licenze temporanee gratuite e mettere a disposizione la nostra struttura di prevendita. Aiuta anche a fare una sorta di dimensionamento, a inquadrare come funzionerà l’infrastruttura a regime. Credo sia molto importante per una soluzione destinata a entrare nel core di un sistema IT».