Ciao a tutti! Questo è l’episodio quattordici di Le Voci dell’AI e oggi parliamo di intelligenza artificiale nazionale.

Come probabilmente avete letto nelle news delle scorse settimane, il governo inglese ha promesso di investire cento milioni di sterline, circa centoquindici milioni di euro, per la creazione di un cosiddetto modello di fondazione nazionale e novecento milioni di sterline, oltre un miliardo di euro, per la creazione di un supercomputer dedicato all’AI.

Un modello di fondazione è un modello generalista di intelligenza artificiale capace di svolgere molti compiti diversi, in grado di accettare input di un tipo specifico o input di tipi diversi: testo, immagini, audio, eccetera. I modelli di fondazione di cui avete sentito parlare fino ad oggi sono ad esempio GPT-4, sviluppato da OpenAI, PaLM, sviluppato da Google o Claude, sviluppato da Anthropic.

Perché il governo inglese vuole creare il suo modello di fondazione invece di usare uno di quelli che abbiamo appena menzionato?

Perché questi modelli vengono educati – trained – analizzando un numero enorme di dati su cui il governo inglese o quello italiano, o quello di qualunque altra nazione, non ha nessun controllo. A seconda di dove provengono i dati usati per il training, il cosiddetto dataset contiene una serie di pregiudizi – bias come dicono gli inglesi –. Questi pregiudizi sono di natura diversa e influenzano come il modello risponde alle domande degli utenti su politica, religione, matrimonio e unioni civili, parità dei sessi, educazione, vaccinazioni, leggi e una miriade di altri argomenti, inclusi quali prodotti è meglio comprare. Un’azienda che sviluppa modelli di fondazione è in grado di manipolare il dataset usato per il training e influenzare le opinioni, le emozioni degli utenti in maniera subdola. Intenzionalmente o meno il fatto che un modello di AI sia sviluppato da una singola azienda come OpenAI e usato da tutto il pianeta, fa sì che tutto il pianeta sia soggetto all’influenza delle decisioni prese da quell’azienda.

Se OpenAI decide di educare il proprio modello con un data set che si porta dietro un pregiudizio di intolleranza, verso, ad esempio, la cultura islamica o un pregiudizio di preferenza per un prodotto americano, ecco che GPT-4 risponderà in una maniera piuttosto che un’altra alle domande degli utenti sulla cultura islamica o sul prodotto americano.

Nessuna nazione al mondo è particolarmente contenta di vedere i propri cittadini indottrinati in massa con i valori, le tradizioni, le idee che contano solo per un particolare gruppo etnico, in una particolare area geografica del mondo, con un particolare orientamento politico. E anche se è nell’interesse commerciale di OpenAI eliminare i pregiudizi nei propri modelli, questi pregiudizi dipendono dai dati a cui OpenAI ha accesso e dai limiti della tecnologia di oggi.

Giacché ad oggi non c’è modo di eliminare completamente il pregiudizio in un Large Language Model, i governi di tutto il mondo preferiscono provare a sviluppare i propri modelli di fondazione.

Il governo inglese è parecchio avvantaggiato rispetto agli altri governi perché il Regno Unito è patria di due aziende di prima grandezza nel mondo dell’intelligenza artificiale: DeepMind, che è stata acquisita da Google e ha recentemente assorbito la divisione di Google Brain e stability.ai che ha sviluppato StableDiffusion.

Stability.ai, l’unica azienda di prima grandezza nel mondo dell’intelligenza artificiale che ha un modello di business completamente basato su open source, ha già indicato che intende supportare il governo inglese e qualunque altro governo del pianeta con una miriade di modelli AI ognuno educato su un data set che riflette la cultura, le tradizioni e i valori delle rispettive nazioni.

La sfida però è epica. Vediamo perché.

Costi altissimi, grande complessità

Questi modelli di fondazione sono i più complessi e costosi da sviluppare. GPT-3, che è stato rilasciato tre anni fa, per esempio, ha richiesto un mese di training e quell’operazione da sola è costata una cifra che OpenAI rivela essere tra un milione e dieci milioni di dollari. Un altro modello di fondazione che è stato rilasciato quest’anno da Meta, chiamato LLaMA, ha richiesto quasi un mese di training e quell’operazione da sola è costata cinque milioni di dollari, oltre 4,6 milioni di euro.

Perché dico quell’operazione da sola? Perché queste cifre che abbiamo menzionato rappresentano esclusivamente il costo dell’esecuzione del programma di training all’interno dei super computer di OpenAI e Meta.

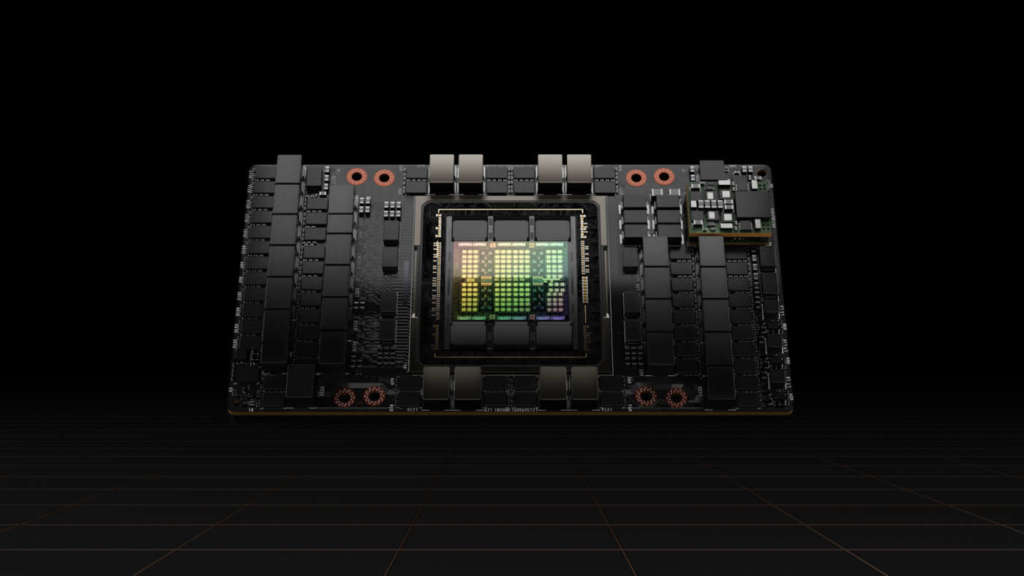

A queste cifre vanno aggiunti i costi per l’acquisto dei super computer e i loro componenti, in particolare le migliaia di GPU necessarie per il training, che cominciano a costare una fortuna perché scarsissime sul mercato. Ad oggi quasi tutte le aziende che vogliono fare il training o il fine tuning di un modello di fondazione usano le GPU di Nvidia.

Pochissimi usano le TPU di Google e, ad eccezione di quelle non c’è praticamente altra alternativa sul mercato. AMD produce delle GPU con prestazioni eccezionali, ma la qualità del software che le accompagna è così bassa che queste schede grafiche non sono adatte ad eseguire programmi di machine learning come quelli necessari per il training o il fine tuning dei modelli di AI che ci interessano.

I chip M1 e M2 di Apple hanno delle prestazioni ugualmente eccezionali ma non sono compatibili con i framework di machine learning che esistono oggi. La comunità AI non si è dimostrata particolarmente interessata a supportare Apple Silicon con Vedremo se Apple annuncerà qualcosa in merito durante la sua conferenza WWDC che comincia il 5 giugno. Tutto questo spiega perché la settimana scorsa le azioni di Nvidia hanno fatto uno dei balzi più grandi nella storia dell’azienda, registrando un +28% dopo la chiusura dei mercati.

La domanda per le GPU di Nvidia è così grande che il CEO dell’azienda si aspetta ricavi oltre il 50% di quanto previsto dagli analisti finanziari per il prossimo trimestre.

Ecco anche perché la situazione politica tra Taiwan e Cina è seguita con grande tensione dalle aziende, dai governi di tutto il mondo.

Taiwan produce la maggior parte dei chip che usiamo oggi, inclusi quelli delle GPU di Nvidia. Una guerra o un qualunque altro evento politico in grado di rallentare o compromettere la produzione di quei chip avrebbe ripercussioni enormi sui mercati mondiali.

Torniamo ai costi per lo sviluppo di un modello di fondazione. Oltre al costo delle migliaia di GPU necessarie per il training e al costo del super computer in cui queste GPU vengono installate, dobbiamo calcolare il costo necessario per analizzare e preparare i terabyte di dati necessari al training del modello. Questo è un lavoro enorme e di importanza critica, che fa una grande differenza nella qualità delle risposte che il modello darà agli utenti durante l’uso; quella fase che in gergo tecnico viene chiamata inferenza.

Poi dobbiamo calcolare il costo del personale. La complessità del training di un modello di fondazione è enorme e pochissimi esperti di machine learning al mondo hanno l’esperienza necessaria per ottenere un successo in tempi brevi. Come potete immaginare, questi esperti sono contesi dalle aziende tecnologiche e finanziarie più ricche del mondo e gli stipendi di questi esperti, ammesso che riusciate a convincerli a lavorare per voi, sono altissimi.

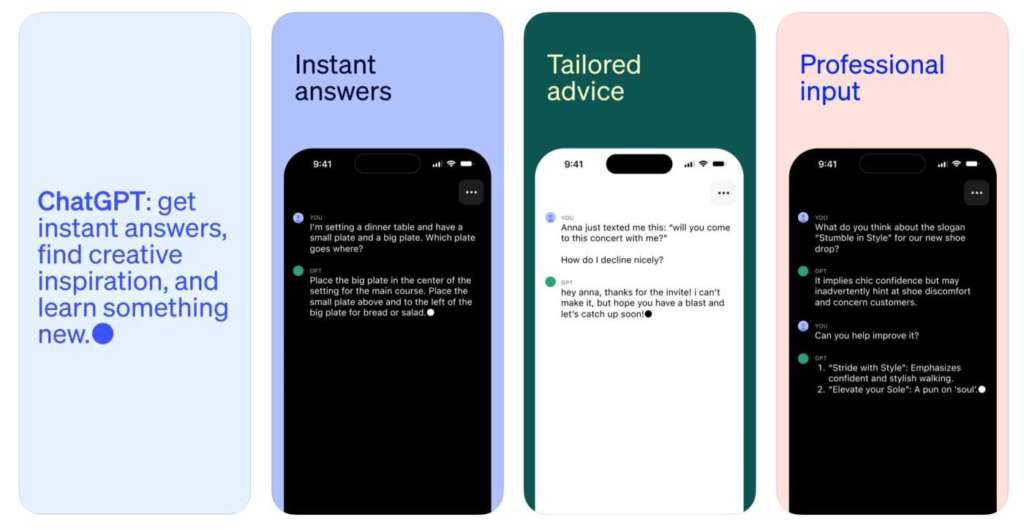

Poi, ovviamente, ci sono i costi di inferenza. Una volta che il modello di fondazione è stato finalizzato, viene creata un’applicazione che lo utilizza e quell’applicazione viene utilizzata da milioni di persone nel mondo. Ogni volta che l’applicazione viene utilizzata per rispondere alla domanda di un utente l’operazione di inferenza va eseguita sulle GPU.

Per esempio, ogni copia del modello GPT-4 richiede l’esecuzione su due GPU collegate insieme. Milioni di utenti che tentano di utilizzare GPT-4 tutti nello stesso momento forzano OpenAI ad avere centinaia o migliaia di copie del modello in esecuzione. E come abbiamo detto, ognuna fa il suo lavoro utilizzando una coppia di GPU. Per darvi un’idea di qual è la domanda di questi modelli vi dico questo: OpenAI ha finalmente rilasciato un’applicazione ufficiale per iOS per utilizzare ChatGPT e GPT-4. Questa applicazione è stata scaricata mezzo milione di volte nei primi sei giorni in cui era disponibile solo negli Stati Uniti (in Italia non lo è ancora). Immaginate cosa succede quando la app viene attivata per tutte le nazioni del pianeta e per tutti gli smartphone che utilizzano Android.

In realtà ci sono molti altri costi da calcolare, ma non è importante essere più dettagliati di così per fare le considerazioni che ci interessa fare. Quello che abbiamo detto fino ad ora è un contesto sufficiente per ritornare al governo inglese. La notizia della scorsa settimana è questa il think tank – o centro studi in italiano – il think tank inglese chiamato Labour for the Long Term ha indicato che il miliardo di sterline di investimenti per l’AI promesso dal governo è assolutamente insufficiente per rimanere competitivi con gli Stati Uniti. Questo think tank ha suggerito un investimento dieci volte più grande, undici miliardi di sterline per il training di quello che è stato chiamato Brit-GPT. È una infrastruttura di cloud computing sovrana per l’hosting e l’inferenza di questo nuovo modello. Questo centro studi ha calcolato che il costo di GPT-4 è già intorno ai cento milioni di sterline e le prossime generazioni, GPT-5 e GPT-6, costeranno ancora di più e saranno infinitamente più capaci.

Le stime fatte da altri membri dell’industria vanno da quaranta milioni a duecento milioni di dollari. In più la ricerca che hanno fatto sottolinea che Google ha pagato quattrocento milioni di sterline nel 2014 per acquisire DeepMind. Microsoft ha investito undici miliardi di dollari per avere un accesso privilegiato ai modelli di OpenAI.

A confronto di queste cifre, dice il think tank, l’investimento che vuole fare il governo inglese non è sufficiente e la nazione rischia di mancare una occasione unica. Su quest’ultimo punto il fondatore e CEO di stability.ai, Emad Mostaque, il 3 aprile dice su Twitter: ci sono solo due nazioni al mondo che al momento hanno delle organizzazioni capaci di fare il training per modelli di fondazione come GPT-4: gli Stati Uniti e il Regno Unito.

Only two countries globally currently have orgs with the capability to train GPT-4+ models.

The USA and… the UK

?

— Emad (@EMostaque) April 3, 2023

Quindi la domanda è: che cosa farà l’Italia?

Ci fermiamo qui per questa settimana. Come sempre, scrivetemi i vostri commenti, i feedback e i suggerimenti per gli argomenti da trattare la prossima settimana.

Ciao!

Buongiorno Sig. Camoletto.

Può trovare tutte le puntate qui: https://www.01net.it/category/intelligenza-artificiale/voci-ai/

Grazie del suo apprezzamento, e buona visione.