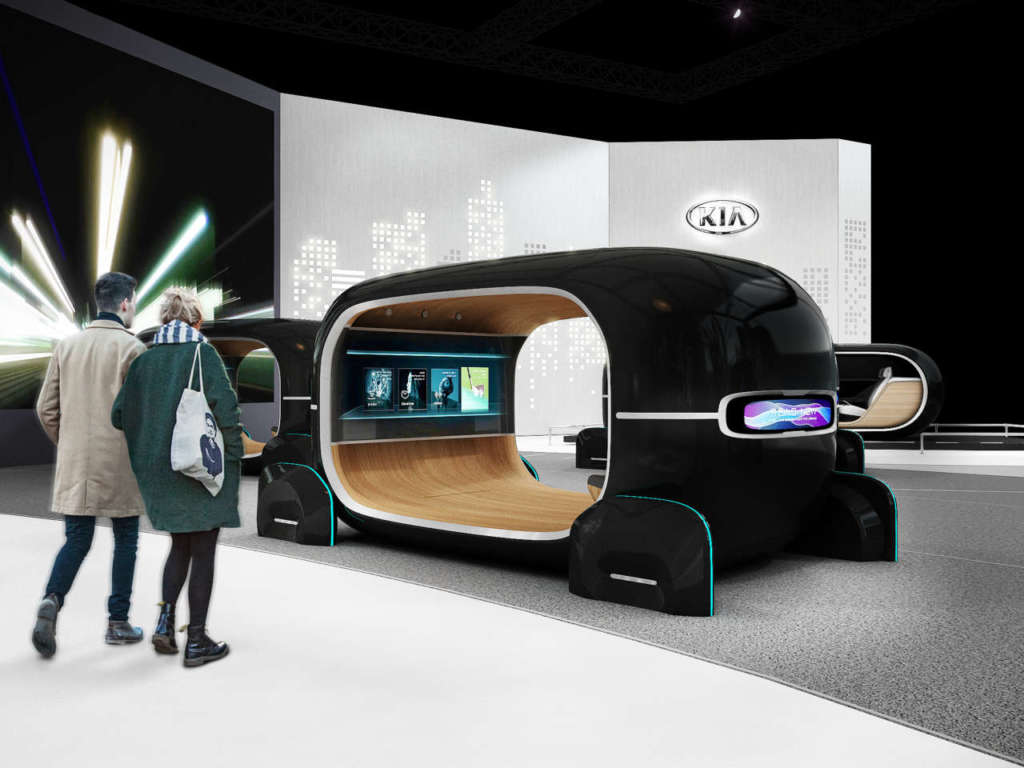

Kia Motors si è dimostrata proiettata già verso l’era post guida autonoma, con l’ambizioso claim “Beyond Autonomous Driving”. L’azienda ha infatti presentato al Ces di quest’anno lo spazio interattivo denominato “Space of Emotive Driving”.

Kia immagina un futuro in cui i veicoli sono in grado di guidarsi da soli. E sta già gettando le basi per un ulteriore sviluppo tecnologico: migliorare l’esperienza di mobilità umana. Al centro della visione di “Space of Emotive Driving” di Kia c’è dunque il nuovo sistema di guida Real-time Emotion Adaptive Driving (R.E.A.D.). Uno spazio interno ottimizzato e interattivo, basato sull’intelligenza artificiale e centrato sull’esperienza sensoriale umana.

Guida autonoma emozionale, con Kia

Il sistema R.E.A.D. è in grado di ottimizzare e personalizzare l’abitacolo del veicolo analizzando lo stato emotivo del guidatore in tempo reale. Ciò viene realizzato attraverso la tecnologia di riconoscimento del segnale biologico basata sull’intelligenza artificiale.

Il sistema monitora lo stato emotivo del guidatore utilizzando sensori per le espressioni facciali, la frequenza cardiaca e l’attività elettrodermica. Quindi adatta l’ambiente interno dell’abitacolo sulla base della valutazione dei dati raccolti, creando un’esperienza di mobilità più gratificante. La tecnologia di intelligenza artificiale e deep learning consente al sistema di stabilire un riferimento del comportamento dell’utente. E quindi identificare i pattern e i trend per personalizzare l’abitacolo di conseguenza.

Il sistema monitora lo stato emotivo del guidatore utilizzando sensori per le espressioni facciali, la frequenza cardiaca e l’attività elettrodermica. Quindi adatta l’ambiente interno dell’abitacolo sulla base della valutazione dei dati raccolti, creando un’esperienza di mobilità più gratificante. La tecnologia di intelligenza artificiale e deep learning consente al sistema di stabilire un riferimento del comportamento dell’utente. E quindi identificare i pattern e i trend per personalizzare l’abitacolo di conseguenza.

La guida, dunque, nella visione di Kia, non sarà più semplicemente autonoma, bensì “emozionale”. E il momento della mobilità diventerà esso stesso un’esperienza sensoriale personalizzata.

Il V-Touch

Accanto al sistema R.E.A.D., Kia offre un’anteprima anche di V-Touch, una tecnologia di controllo dei gesti virtuale. V-Touch utilizza una fotocamera 3D per monitorare occhi e dita degli utenti. E consente ai passeggeri di gestire diverse funzioni dell’auto attraverso un head-up display non invasivo.

Attraverso semplici gesti delle dita, tutti i passeggeri del veicolo possono apportare modifiche all’ambiente dell’abitacolo. Ad esempio a: illuminazione, climatizzazione e sistemi di intrattenimento; eliminando la necessità di pulsanti o touch screen.

Attraverso semplici gesti delle dita, tutti i passeggeri del veicolo possono apportare modifiche all’ambiente dell’abitacolo. Ad esempio a: illuminazione, climatizzazione e sistemi di intrattenimento; eliminando la necessità di pulsanti o touch screen.

L’expertise tecnica che ha reso possibile questa dimostrazione al Ces deriva dalla collaborazione di Kia con l’Affective Computing Group del Media Lab del Massachusetts Institute of Technology (MIT), come parte dell membership di Kia al Media Lab.

La tecnologia Samsung potenzia Audi

Samsung Electronics ha annunciato che Exynos Auto V9 è stato selezionato per il sistema di infotainment di prossima generazione dei veicoli Audi. Exynos Auto V9 è il primo processore Samsung specificatamente progettato per il settore automotive. Il debutto di Exynos Auto V9 è atteso entro il 2021.

Exynos Auto V9 è un potente processore automobilistico progettato per i sistemi IVI (in-vehicle infotainment) avanzati. Sistemi che visualizzano contenuti su display multipli, fornendo informazioni che assistono guidatori e passeggeri in un’esperienza di guida più sicura e piacevole.

Exynos Auto V9 è un potente processore automobilistico progettato per i sistemi IVI (in-vehicle infotainment) avanzati. Sistemi che visualizzano contenuti su display multipli, fornendo informazioni che assistono guidatori e passeggeri in un’esperienza di guida più sicura e piacevole.

Exynos Auto V9 è basato sulla tecnologia a 8 nm. Include gli ultimi core Cortex-A76 di ARM, la GPU ARM Mali G76, un DSP premium e una neural processing unit (NPU). Il processore supporta anche la DRAM LPDDR4 e LPDDR5 veloce ed efficiente.

La sicurezza è un punto critico nei componenti dell’industria automobilistica. Exynos Auto V9, spiega Samsung, supporta lo standard ASIL-B. L’Automotive Safety Integrity Level prevede una valutazione della sicurezza su quattro livelli, da A (il più basso) a D (il più alto).

Qualcomm mette in pista il C-V2X

In occasione del Ces, Audi, Ducati, Ford e Qualcomm hanno annunciato l’impegno congiunto delle società per accelerare lo sviluppo commerciale di C-V2X. Si tratta di una tecnologia di comunicazione diretta per la sicurezza stradale, l’efficienza del traffico e la guida automatizzata.

Al Ces 2019, veicoli Audi e Ford, e motociclette Ducati Multistrada 1260, hanno dimostrato varie situazioni di guida utilizzando le comunicazioni dirette C-V2X. Tutti i veicoli erano equipaggiati con questa tecnologia mediante il chipset C-V2X Qualcomm 9150.

Dimostrazioni analoghe dell’utilizzo del C-V2X si stanno svolgendo in ogni parte del mondo, Europa inclusa.

Dall’invisibile al visibile, dall’auto al cloud

Nissan vuole aiutare guidatori a “vedere l’invisibile”, coniugando mondo reale e mondo virtuale per dare vita a un’esperienza unica di auto connessa.

Presentata al Ces 2019, Invisible-to-Visible, o I2V, è una tecnologia creata nell’ambito della Nissan Intelligent Mobility, la roadmap strategica che ridefinisce il modo in cui i veicoli sono alimentati, guidati e integrati nella società.

Il sistema I2V combina le informazioni trasmesse dai sensori esterni ed interni al veicolo con i dati provenienti dal cloud. In questo modo, oltre a rilevare l’area immediatamente circostante la vettura, il sistema è in grado di prevedere la scena che si prospetta davanti al guidatore, mostrando addirittura elementi celati da un edificio o una curva.

Per rendere più piacevole l’esperienza al volante, la guida avviene in modalità “umana” interattiva, attraverso avatar che vengono visualizzati all’interno dell’auto.

Quando si entra nel mondo virtuale, I2V offre possibilità di servizi e opzioni di comunicazione, rendendo la guida più confortevole, pratica ed emozionante.

La tecnologia I2V è alimentata dal sistema Omni-Sensing Nissan che raccoglie in tempo reale i dati sul traffico, sull’area attorno e all’interno del veicolo. La tecnologia SAM (Seamless Autonomous Mobility) analizza il contesto stradale raccogliendo informazioni rilevanti in tempo reale, mentre il sistema di assistenza alla guida semiautonomo ProPILOT fornisce informazioni sull’area attorno al veicolo.

La tecnologia riproduce uno spazio virtuale a 360° intorno alla vettura, per fornire informazioni quali, ad esempio, le condizioni della strada e degli incroci, la visibilità, la segnaletica e la presenza di pedoni. Il sistema è anche in grado di monitorare le persone a bordo del veicolo utilizzando i sensori interni, per anticipare eventuali necessità di assistenza per trovare qualcosa o di una pausa caffè per rimanere vigili.

Il sistema I2V è in grado di mettere in contatto guidatori e passeggeri con le persone del mondo virtuale Metaverse. Familiari, amici o altri passeggeri possono essere visualizzati a bordo dell’auto sotto forma di avatar tridimensionali a realtà aumentata per tenere compagnia o fornire assistenza.

Durante la guida autonoma, la tecnologia I2V rende il tempo trascorso in auto più confortevole e piacevole: ad esempio, quando piove, può proiettare all’interno del veicolo lo scenario di una giornata di sole.

Quando si visita un luogo nuovo, il sistema può cercare all’interno di Metaverse una guida locale esperta che comunichi in tempo reale con i passeggeri.

Le informazioni fornite dalla guida possono essere raccolte con Omni-Sensing e archiviate nel cloud, per consentire ad altre persone che visitano la stessa zona di accedere a indicazioni utili. Possono essere usate anche dal sistema di intelligenza artificiale di bordo per offrire una guida più efficiente nelle aree locali.

Durante la guida manuale, il sistema I2V trasmette le informazioni provenienti da Omni-Sensing in sovrimpressione nel campo visivo del guidatore. Tali informazioni permettono al guidatore di valutare e gestire al meglio situazioni quali curve a visibilità limitata, condizioni del fondo stradale irregolare o traffico in senso contrario.

Il guidatore può anche prenotare un autista professionista in Metaverse, per ricevere istruzioni personalizzate in tempo reale. L’autista professionista viene proiettato sotto forma di avatar o di auto virtuale nel campo visivo del guidatore, per mostrare la modalità ottimali di guida.

Oltre a visualizzare le informazioni sul traffico e sui tempi di percorrenza stimati, il sistema I2V è in grado di comunicare dettagli specifici per informare al meglio il guidatore sulla strada da percorrere, eliminando così le incognite e riducendo gli aspetti stressanti della guida.

Il sistema fornisce anche suggerimenti su diverse scelte possibili, per esempio indica la corsia più scorrevole in situazioni di traffico intenso, utilizzando la mappatura dei dati locali in tempo reale tramite Omni-Sensing.

Una volta giunti a destinazione, il sistema I2V può accedere a SAM per cercare i parcheggi e parcheggiare in maniera autonoma il veicolo, in situazioni che richiedano manovre complicate.