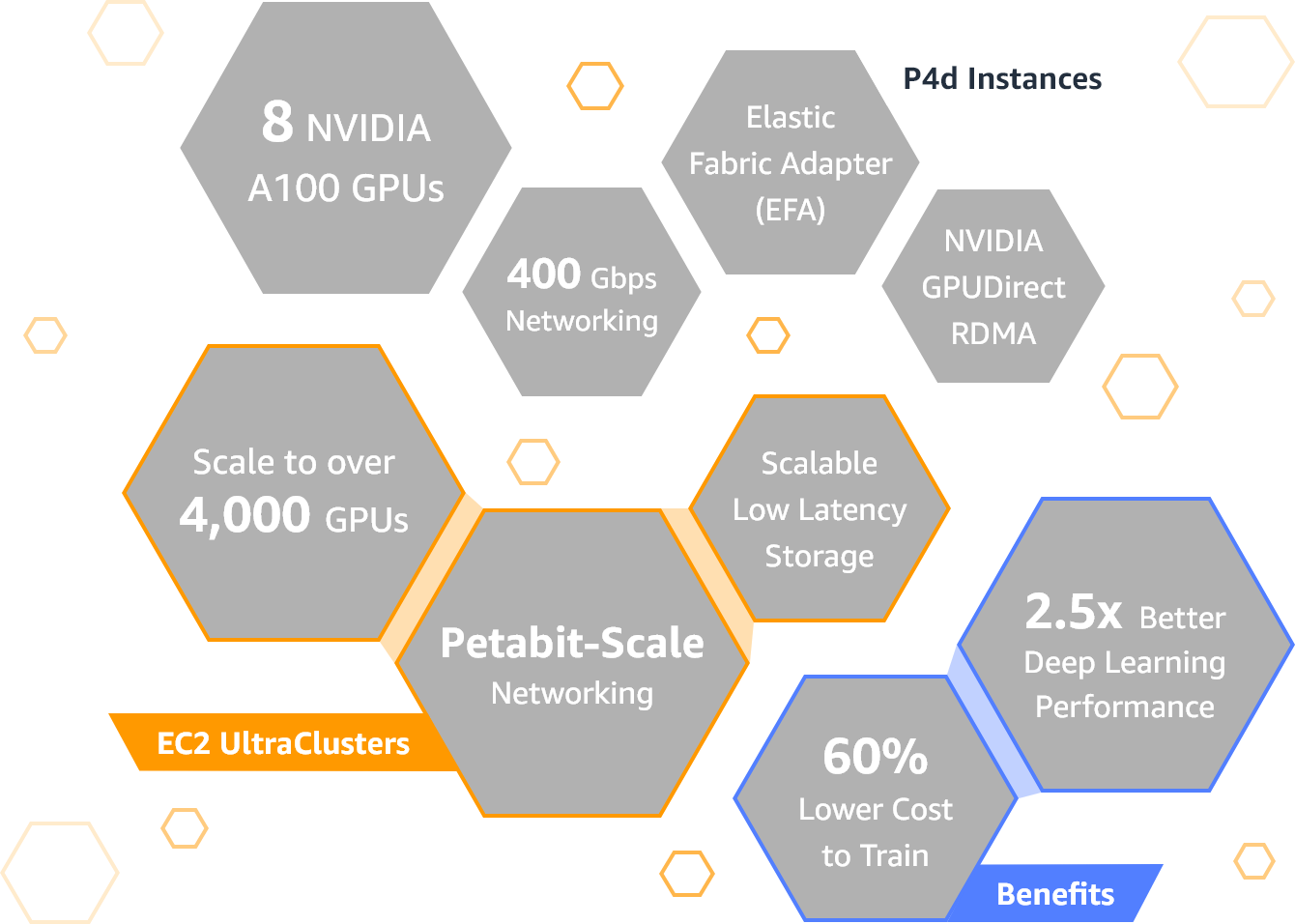

Amazon Web Services (AWS) ha annunciato la disponibilità generale delle istanze P4d di Amazon Elastic Compute Cloud, Amazon EC2: la nuova generazione di istanze potenziate da GPU, rispetto alle istanze P3 della generazione precedente, offre prestazioni fino a tre volte più veloci, un costo inferiore fino al 60% e una memoria della GPU 2,5 volte maggiore per accelerare il training del machine learning e per i carichi di lavoro di high-performance computing (HPC).

Le istanze P4d sono dotate di otto GPU Nvidia A100 Tensor Core e di 400 Gbps di larghezza di banda di rete (16 volte in più rispetto alle istanze P3).

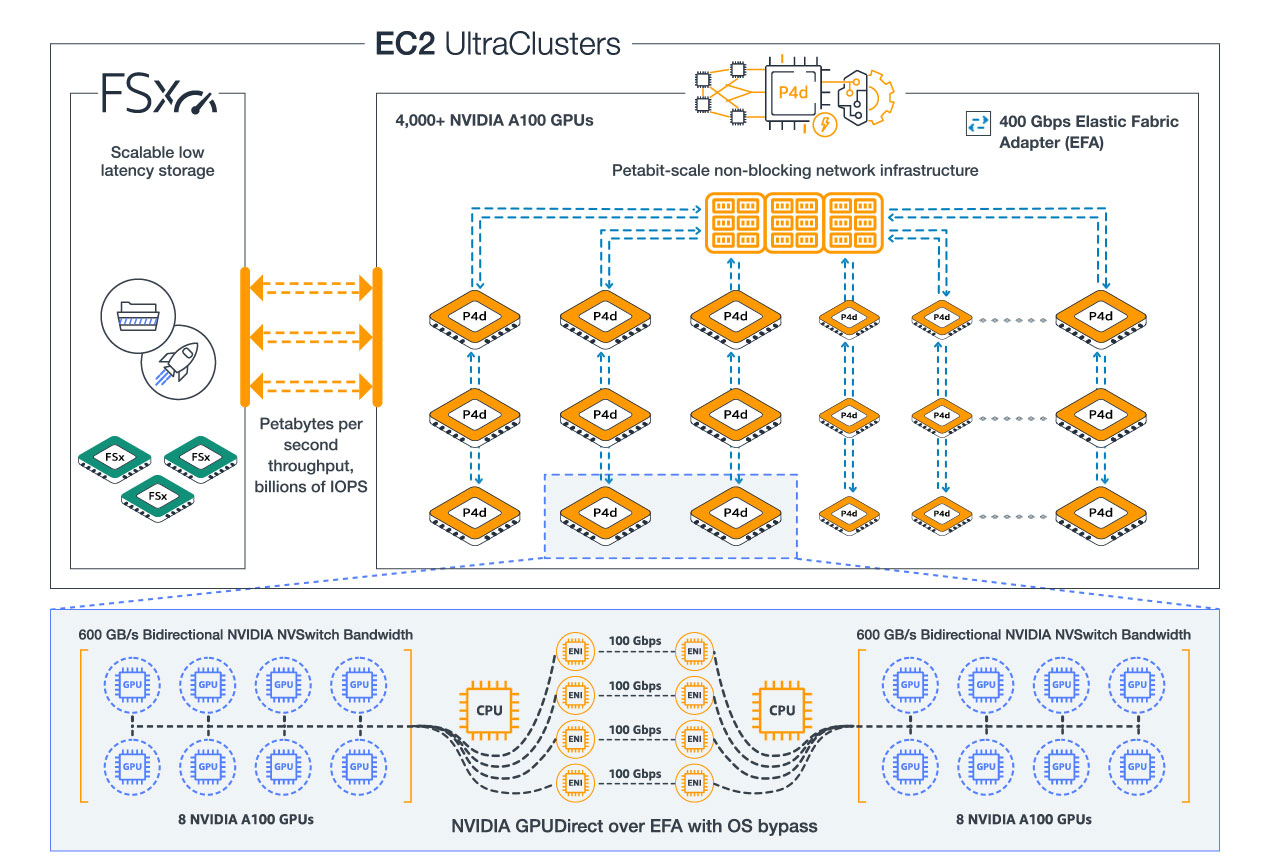

Utilizzando le istanze P4d con l’Elastic Fabric Adapter (EFA) di AWS e Nvidia GPUDirect RDMA (remote direct memory access), i clienti di Amazon AWS sono in grado di creare istanze P4d con la capacità di EC2 UltraClusters.

Con gli EC2 UltraClusters, i clienti possono scalare le istanze P4d fino a oltre 4.000 GPU A100 (il doppio più numerose di qualsiasi altro cloud provider, secondo quanto sostiene Amazon) utilizzando l’infrastruttura di networking non-blocking petabit-scale progettata da AWS e integrata con lo storage ad alte prestazioni Amazon FSx for Lustre, fornendo in tal modo l’accesso on-demand a una performance di classe supercomputing per accelerare il training di machine learning e l’HPC.

L’incremento delle prestazioni delle istanze P4d accelera i tempi di training dei modelli di machine learning fino a tre volte, assicura Amazon AWS, riducendo i tempi di training da giorni a ore; inoltre, la memoria aggiuntiva della GPU aiuta i clienti a addestrare modelli più grandi e complessi.

I dati diventano sempre più abbondanti i clienti dei servizi cloud addestrano modelli con milioni e talvolta miliardi di parametri, come quelli usati per l’elaborazione del linguaggio naturale per la sintesi dei documenti e la risposta alle domande, il rilevamento e la classificazione degli oggetti per i veicoli autonomi, la classificazione delle immagini per la moderazione dei contenuti su larga scala, i motori di raccomandazione per i siti web di e-commerce e gli algoritmi di classificazione per i motori di ricerca intelligenti, tutti elementi che richiedono un aumento del throughput di rete e della memoria GPU.

Le istanze P4d sono dotate di 8 GPU Nvidia A100 Tensor Core in grado di offrire fino a 2,5 petaflop di performance mixed-precision e 320 GB di memoria GPU ad alta banda passante in un’istanza EC2. Le istanze P4d sono le prime nel settore, sottolinea Amazon AWS, a offrire una banda passante di rete di 400 Gbps con Elastic Fabric Adapter (EFA) e interfacce di rete Nvidia GPUDirect RDMA, per consentire la comunicazione diretta tra le GPU attraverso i server al fine di ottenere una minore latenza e una maggiore efficienza di ridimensionamento, contribuendo a sbloccare i colli di bottiglia quando è necessario scalare i carichi di lavoro distribuiti multi-nodo.

Ogni istanza P4d, ha illustrato ancora Amazon AWS, offre inoltre 96 vCPU Intel Xeon Scalable (Cascade Lake), 1,1 TB di memoria di sistema e 8 TB di memoria NVMe locale per ridurre i tempi di training dei singoli nodi.

Incrementando più del doppio le prestazioni rispetto alla precedente generazione di istanze P3, le istanze P4d possono ridurre i costi del training dei modelli di machine learning fino al 60%, evidenzia Amazon AWS, fornendo ai clienti una maggiore efficienza rispetto ai sistemi on-premise costosi e poco flessibili.

I clienti HPC possono anche beneficiare delle maggiori prestazioni di elaborazione delle istanze P4d e della memoria della GPU per carichi di lavoro impegnativi come l’analisi sismica, la scoperta di farmaci, il sequenziamento del DNA, la scienza dei materiali e la modellazione del rischio finanziario e assicurativo.