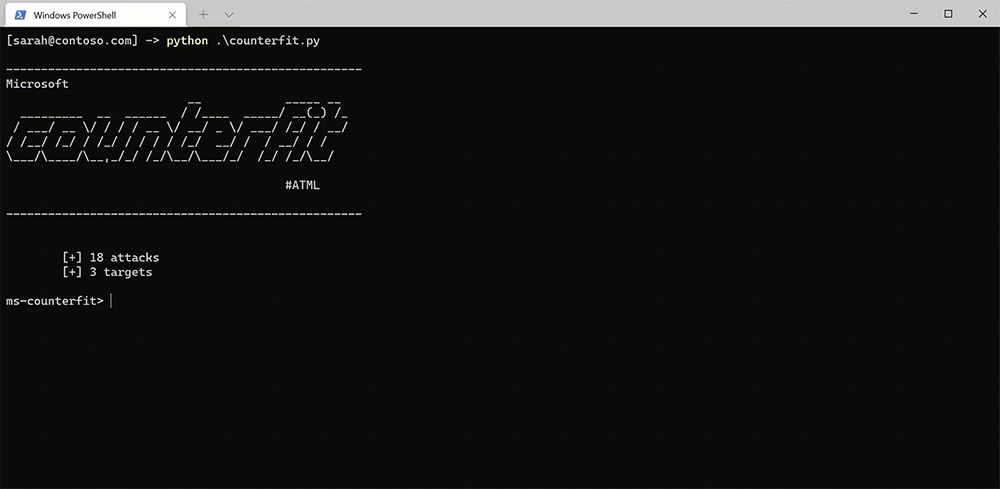

Microsoft ha annunciato di aver rilasciato come progetto open source Counterfit, uno strumento di automazione per testare la sicurezza dei sistemi di intelligenza artificiale.

Counterfit, ha sottolineato Microsoft, aiuta le organizzazioni a condurre valutazioni del rischio di sicurezza dell’intelligenza artificiale per garantire che gli algoritmi utilizzati nelle loro attività siano robusti, affidabili e degni di fiducia.

Il contesto è quello in cui i sistemi di intelligenza artificiale sono sempre più utilizzati in aree critiche come la sanità, la finanza e la difesa. I consumatori, pertanto, devono avere fiducia che i sistemi di intelligenza artificiale che alimentano questi ambiti importanti siano al sicuro da manipolazioni da parte di malintenzionati.

Il team di Microsoft fa l’esempio di una delle raccomandazioni della Top 5 Priorities for Managing AI Risk del framework MOST di Gartner, pubblicata nel gennaio 20211, che, oltre a esortare le organizzazioni a adottare specifiche misure di sicurezza dell’intelligenza artificiale per garantire resistenza e resilienza, nota che: “Entro il 2024, le organizzazioni che implementano controlli dedicati alla gestione del rischio dell’intelligenza artificiale eviteranno con successo esiti negativi due volte più spesso di quelle che non lo fanno“.

Tuttavia, mette in evidenza ancora Microsoft, eseguire valutazioni di sicurezza dei sistemi di intelligenza artificiale di produzione non è un task banale.

Microsoft stessa ha intervistato 28 organizzazioni, tra cui aziende Fortune 500, governi, non-profit e piccole e medie imprese, per capire gli attuali processi in atto per proteggere i sistemi di intelligenza artificiale.

E ha scoperto che 25 aziende su 28 hanno indicato di non avere gli strumenti giusti per proteggere i loro sistemi di intelligenza artificiale e che i professionisti della sicurezza sono ancora alla ricerca di una direzione specifica in questo spazio.

È qui che entra in gioco questo strumento che è nato proprio dal bisogno della stessa Microsoft di valutare le vulnerabilità dei sistemi di intelligenza artificiale dell’azienda.

Con l’obiettivo di proteggere proattivamente i servizi, in conformità con i principi di intelligenza artificiale responsabile di Microsoft e l’iniziativa Responsible AI Strategy in Engineering (RAISE).

Oggi Microsoft utilizza abitualmente Counterfit per scansionare proattivamente le vulnerabilità specifiche dell’intelligenza artificiale.

L’uso dello strumento viene anche sperimentato da parte dell’azienda nella fase di sviluppo dell’intelligenza artificiale, per catturare le vulnerabilità nei sistemi prima che questi entrino in produzione.