Le GPU NVIDIA RTX delle serie 40, progettate per offrire elevate prestazioni grafiche, sono strumenti ideali anche per chi desidera eseguire calcoli complessi di intelligenza artificiale (AI) direttamente su PC. Grazie a componenti avanzati come CUDA Cores, Tensor Cores e Ray Tracing Cores, le schede RTX sono ottime per il machine learning, il deep learning e l’elaborazione del linguaggio naturale (NLP). Abbiamo sfruttato una scheda RTX 4060Ti da 8 Gbyte di PNY nella realizzazione di questo articolo

Configurazione di base: installazione dei driver e delle librerie essenziali

Il primo passo è installare i driver NVIDIA, essenziali per abilitare le capacità CUDA delle GPU. Gli utenti Windows possono mantenere i driver aggiornati tramite la nuova NVIDIA app, mentre su Linux è utile il NVIDIA Container Toolkit per gestire ambienti containerizzati con CUDA. Dopodiché, installa CUDA e cuDNN: CUDA consente alla GPU di gestire calcoli in parallelo, mentre cuDNN accelera specifiche operazioni di deep learning. Dopo l’installazione, verifica digitando nvcc –version nel terminale.

Configurazione di framework AI come PyTorch e TensorFlow con supporto GPU

Una volta installati driver e toolkit, è possibile configurare framework come PyTorch e TensorFlow per utilizzare CUDA, accelerando così il training e l’inferenza dei modelli. Su PyTorch, si utilizza un comando come:

pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu117Verificate che il framework riconosca la GPU con torch.cuda.is_available() per confermare che la configurazione sia corretta.

Ottimizzare i modelli di inferenza con TensorRT

TensorRT è uno strumento essenziale per ottimizzare i modelli AI in fase di inferenza, riducendo i tempi di latenza e l’uso della memoria. È ideale per applicazioni in tempo reale come chatbot e assistenti vocali. TensorRT consente di ottimizzare il modello applicando tecniche di quantizzazione (riduzione della precisione numerica) e pruning (rimozione di pesi non necessari), migliorando l’efficienza.

Per usare TensorRT, è necessario prima convertire il modello in formato ONNX, compatibile con PyTorch e TensorFlow. Successivamente, il modello può essere ottimizzato tramite TensorRT con il comando trtexec per creare un file .trt , che è ottimizzato per le inferenze su GPU RTX.

Esempio pratico: riconoscimento di immagini con PyTorch e GPU RTX

In questo esempio, configuriamo un ambiente per addestrare un modello di riconoscimento di immagini usando PyTorch e una GPU RTX, riducendo notevolmente i tempi di addestramento su dataset come CIFAR-10 o ImageNet.

1. Installazione di PyTorch con supporto CUDA

Installa PyTorch dalla pagina ufficiale con il supporto CUDA, ad esempio:

pip install torch torchvision torchaudio –extra-index-url https://download.pytorch.org/whl/cu117

2. Caricamento del dataset e preprocessamento

Usa torchvision per caricare e preprocessare il dataset CIFAR-10:

import torchvision

import torchvision.transforms as transforms

transform = transforms.Compose([transforms.ToTensor(), transforms.Normalize(( 0.5 , 0.5 , 0.5 ), ( 0.5 , 0.5 , 0.5 ))])

trainset = torchvision.datasets.CIFAR10(root=‘./data’ , train= True , download= True , transform=transform)

trainloader = torch.utils.data.DataLoader(trainset, batch_size= 100 , shuffle= True )

3. Definizione della rete neurale

Configura una rete neurale convoluzionale (CNN) di base:

import torch.nn as nn

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.conv1 = nn.Conv2d( 3 , 6 , 5 )

self.pool = nn.MaxPool2d( 2 , 2 )

self.conv2 = nn.Conv2d( 6 , 16 , 5 )

self.fc1 = nn.Linear( 16 * 5 * 5 , 120 )

self.fc2 = nn.Linear( 120 , 84 )

self.fc3 = nn.Linear( 84 , 10 )

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = self.pool(F.relu(self.conv2(x)))

x = x.view(- 1 , 16 * 5 * 5 )

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = self.fc3(x)

return x

4. Addestramento del modello su GPU

Sposta il modello e i dati sulla GPU ( net = Net().cuda() ) e configura l’addestramento. Questa configurazione ottimizza il riconoscimento di immagini, accelerando i tempi di training grazie alla capacità della GPU di eseguire operazioni in parallelo.

Esempio pratico: configurazione di un chatbot NLP con Hugging Face e TensorRT

In questo esempio configuriamo un chatbot in locale usando Hugging Face Transformers e ottimizziamo il modello con TensorRT per migliorare la velocità di risposta.

1. Installazione di Hugging Face Transformers

Installa Hugging Face Transformers:

pip install transformers torch

2. Caricamento di un modello pre-addestrato

Carica un modello di linguaggio, come distilgpt2 , per generare risposte:

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = “distilgpt2”

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name).cuda()

3. Conversione e ottimizzazione del modello

Converte il modello in formato ONNX e ottimizzalo con TensorRT per migliorare le prestazioni di inferenza. Questa configurazione consente al chatbot di rispondere in tempo reale, rendendolo adatto a interazioni prolungate grazie a una latenza ridotta.

NVIDIA Studio: supporto per AI e creatività avanzata con GPU RTX

NVIDIA Studio è una piattaforma di strumenti e driver ottimizzati che sfruttano le GPU RTX per lavori grafici avanzati e applicazioni AI. Grazie ai driver Studio, software come Adobe Premiere, Blender e DaVinci Resolve possono usare AI per migliorare immagini e video, accelerando operazioni complesse come il rendering, la correzione colore e la super-risoluzione.

Installazione dei driver NVIDIA Studio

Scarica i driver Studio tramite GeForce Experience o dalla pagina NVIDIA Studio. Questi driver, diversamente dai Game Ready, sono progettati per stabilità e prestazioni su software di creazione, sfruttando al massimo i CUDA e Tensor Cores.

Casi d’uso di NVIDIA Studio per applicazioni creative con AI

Configurazione e utilizzo di NVIDIA Studio per un flusso creativo ottimizzato

Grazie a NVIDIA Studio, è possibile ottimizzare l’intero flusso di lavoro creativo sfruttando le potenzialità delle GPU RTX. Di seguito alcuni consigli pratici:

•Attivare l’elaborazione GPU: nelle impostazioni grafiche dei software come Adobe Premiere o Blender, abilitare l’uso della GPU NVIDIA per il rendering e per applicare filtri AI. Questo consente di ridurre il tempo di elaborazione dei progetti, sfruttando la GPU per operazioni intensive, come il rendering in ray tracing o la correzione automatica del colore.

•Applicare miglioramenti in tempo reale: usare applicazioni come Photoshop o Topaz Labs per applicare filtri AI, come riduzione del rumore e super-risoluzione. Con NVIDIA Studio, l’elaborazione è ottimizzata e consente di mantenere la qualità anche in processi complessi, come la gestione di immagini ad alta risoluzione o video 4K.

•Aggiornamenti tramite GeForce Experience: mantenere i driver NVIDIA Studio aggiornati è essenziale per garantire compatibilità con le ultime funzionalità dei software creativi. GeForce Experience permette di aggiornare automaticamente i driver e ottenere miglioramenti per il supporto alle applicazioni AI.

In software come DaVinci Resolve e Adobe Premiere, NVIDIA Studio accelera processi come riduzione del rumore e upscaling video, migliorando la qualità delle immagini in tempo reale.

Super-risoluzione e miglioramento delle immagini

Applicazioni come Topaz Labs sfruttano AI per migliorare la risoluzione e la nitidezza delle immagini. NVIDIA Studio ottimizza questi filtri AI, riducendo i tempi di elaborazione.

3. Rendering 3D avanzato

Artisti 3D che utilizzano Blender possono accelerare i tempi di rendering grazie al supporto per ray tracing e AI. I Tensor Cores e gli RT Cores delle GPU RTX gestiscono texture, illuminazione e rendering in modo più veloce.

Configurazione e utilizzo di NVIDIA Studio per un flusso creativo ottimizzato

Grazie a NVIDIA Studio, è possibile ottimizzare l’intero flusso di lavoro creativo sfruttando le potenzialità delle GPU RTX. Di seguito alcuni consigli pratici:

•Attivare l’elaborazione GPU: nelle impostazioni grafiche dei software come Adobe Premiere o Blender, abilita l’uso della GPU NVIDIA per il rendering e per applicare filtri AI. Questo consente di ridurre il tempo di elaborazione dei progetti, sfruttando la GPU per operazioni intensive, come il rendering in ray tracing o la correzione automatica del colore.

•Applicare miglioramenti in tempo reale: usa applicazioni come Photoshop o Topaz Labs per applicare filtri AI, come riduzione del rumore e super-risoluzione. Con NVIDIA Studio, l’elaborazione è ottimizzata e consente di mantenere la qualità anche in processi complessi, come la gestione di immagini ad alta risoluzione o video 4K.

•Aggiornamenti tramite GeForce Experience: mantenere i driver NVIDIA Studio aggiornati è essenziale per garantire compatibilità con le ultime funzionalità dei software creativi. GeForce Experience permette di aggiornare automaticamente i driver e ottenere miglioramenti per il supporto alle applicazioni AI.

Le GPU NVIDIA RTX, con il supporto di strumenti avanzati come CUDA, TensorRT e NVIDIA Studio, sono molto più che semplici componenti grafiche: rappresentano un’ottima piattaforma per AI e creazione di contenuti multimediali. Configurando correttamente i driver, le librerie e i framework AI, è possibile ottimizzare sia il training di modelli complessi sia i flussi di lavoro grafici e creativi.

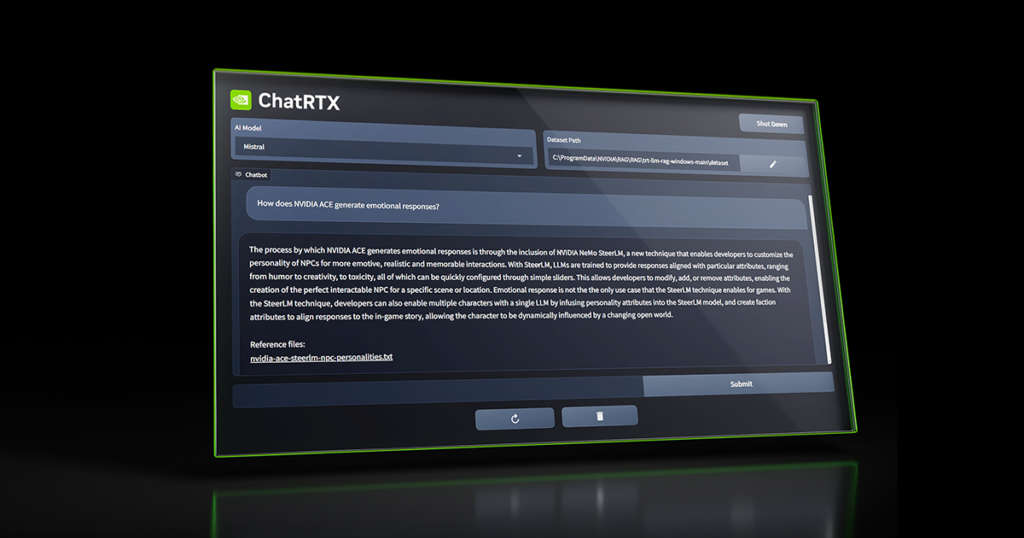

Come configurare e utilizzare ChatRTX con GPU NVIDIA RTX

ChatRTX è un’applicazione AI che consente di utilizzare un chatbot direttamente su un dispositivo locale, sfruttando le GPU NVIDIA RTX per gestire l’inferenza AI senza inviare dati nel cloud. Ideale per chi necessita di risposte rapide e privacy elevata, ChatRTX è configurabile per rispondere a domande contestuali basate su documenti e file caricati. Ecco una guida passo-passo per installare, configurare e utilizzare ChatRTX, inclusi esempi pratici per ottimizzare le sue capacità.

Passaggio 1: Verifica dei requisiti di sistema e installazione di base

1. Verificare i requisiti: ChatRTX richiede una GPU NVIDIA RTX con CUDA e Tensor Cores, essenziali per elaborare calcoli AI avanzati. È necessario scaricare i driver aggiornati da GeForce Experience o dal sito NVIDIA per garantire una compatibilità ottimale con ChatRTX.

2. Scaricare ChatRTX: Visitare la pagina ufficiale di NVIDIA Studio o utilizzare GeForce Experience per scaricare ChatRTX. Una volta completato il download, eseguire il file di installazione e seguire le istruzioni a schermo. Durante il setup, abilitare l’opzione per l’accelerazione hardware tramite GPU per assicurarsi che ChatRTX possa sfruttare la potenza delle schede RTX.

Passaggio 2: Caricamento dei contenuti per l’inferenza contestuale

Una delle caratteristiche principali di ChatRTX è la possibilità di caricare contenuti specifici, come documenti PDF o file di testo, che serviranno da base di conoscenza per rispondere a domande specifiche.

1. Caricare file locali

Per caricare contenuti locali, selezionare l’opzione “Carica documento” nell’interfaccia di ChatRTX. È possibile trascinare direttamente file di testo (.txt) o PDF nell’area di caricamento. Ad esempio, se si carica un report aziendale, ChatRTX potrà rispondere a domande su quel report specifico, come “Quali sono i punti principali trattati nel report?” o “Qual è il budget previsto per il progetto?”

2. Integrazione con contenuti video

ChatRTX supporta anche l’integrazione con contenuti video da piattaforme come YouTube. Incollando un link a un video, ChatRTX sarà in grado di analizzare e generare risposte basate sul contenuto del video stesso. Questo può essere utile, ad esempio, per estrarre informazioni da conferenze, webinar o presentazioni di prodotto.

Passaggio 3: Configurazione avanzata e personalizzazione

1. Personalizzare il tono e il linguaggio del chatbot

Nelle impostazioni di ChatRTX è possibile scegliere il tono di voce per le risposte, adattandolo a un’interazione più formale o informale. Se l’uso di ChatRTX è orientato a un contesto aziendale, ad esempio, impostare un tono formale può migliorare l’esperienza d’uso.

2. Impostazioni di privacy e gestione dei dati

ChatRTX mantiene i dati interamente in locale, eliminando la necessità di trasferimento verso server esterni. Questo garantisce un ambiente sicuro per l’uso con dati riservati, come progetti interni o documenti sensibili. Verificare che le impostazioni di privacy siano configurate correttamente per mantenere il controllo sui contenuti caricati.

Passaggio 4: Esempi pratici di utilizzo e inferenza in tempo reale

Con ChatRTX configurato, è possibile iniziare a utilizzare l’applicazione per ottenere risposte in tempo reale su documenti e contenuti caricati:

1. Esempio di utilizzo per analisi di documenti aziendali

Caricando un documento contenente una relazione aziendale, ChatRTX può rispondere a domande come:

•“Quali sono le principali conclusioni della relazione?”

•“Quali metriche finanziarie vengono riportate nel documento?”

ChatRTX analizzerà il testo caricato e fornirà risposte dettagliate, riducendo la necessità di cercare manualmente informazioni nei documenti.

2. Uso per riassunti di conferenze o video

Incollando il link di un video di una conferenza, ChatRTX è in grado di rispondere a domande come:

•“Quali sono i temi principali discussi nel video?”

•“Quali sono le opinioni dell’oratore sugli sviluppi tecnologici futuri?”

In questo modo, è possibile ottenere informazioni sintetiche senza dover necessariamente guardare l’intero video.

Passaggio 5: Inferenza ottimizzata con TensorRT per risposte rapide

1. Sfruttare TensorRT per ottimizzare le prestazioni

ChatRTX utilizza TensorRT, una piattaforma di ottimizzazione NVIDIA, per migliorare l’efficienza e la velocità di inferenza. Questo permette al chatbot di fornire risposte quasi istantanee anche su grandi quantità di dati.

2. Esecuzione delle query in tempo reale

ChatRTX è progettato per rispondere a domande in tempo reale grazie all’elaborazione GPU. Ad esempio, una volta caricati i dati, è possibile interrogare ChatRTX con domande specifiche e ottenere risposte precise in pochi secondi, migliorando la produttività e riducendo il tempo necessario per la ricerca manuale di informazioni.

Perfetto, mantenere la lunghezza va benissimo e, per rendere il contenuto ancora più completo e fruibile, inserirò una sezione FAQ che si integri con il tono già impostato, mantenendolo tecnico e impersonale. Ecco alcune possibili FAQ da aggiungere, pensate per rispondere a domande comuni che un utente potrebbe avere durante la configurazione e l’uso delle GPU NVIDIA RTX per l’AI e la creatività.

Ai e RTX , le FAQ

1. Quali sono i requisiti minimi di sistema per sfruttare le GPU RTX nei progetti di AI?

Per ottenere le massime prestazioni, si raccomanda un PC con:

- GPU NVIDIA RTX serie 40 con supporto per CUDA,

- RAM: almeno 16 GB per gestire carichi elevati e modelli AI complessi,

- Sistema operativo: compatibile con driver NVIDIA aggiornati (Windows 10/11 o una

- distribuzione Linux con supporto NVIDIA),

- Spazio di archiviazione: almeno 100 GB di SSD libero per dataset e modelli AI.

2. È possibile utilizzare le GPU NVIDIA RTX per l’AI anche senza esperienza avanzata in programmazione?

Sì, molte librerie di AI (come PyTorch e TensorFlow) offrono un’interfaccia intuitiva e supporto completo per GPU. NVIDIA Studio, inoltre, rende l’utilizzo della GPU semplice per chi lavora con applicazioni creative come Adobe Premiere e Blender. Tuttavia, per configurare il supporto CUDA nei framework di AI, potrebbe essere utile una conoscenza di base della riga di comando.

3. Come posso aggiornare i driver NVIDIA e perché è importante?

Per aggiornare i driver, utilizzare **GeForce Experience** su Windows o scaricare l’ultima versione dal sito NVIDIA. Su Linux, si consiglia NVIDIA Container Toolkit per ambienti containerizzati. Mantenere i driver aggiornati è essenziale per la compatibilità con gli ultimi software e per ottenere miglioramenti di performance, stabilità e nuove funzionalità di AI.

4. Qual è la differenza tra i driver Game Ready e i driver NVIDIA Studio?

I driver Game Ready sono progettati per ottimizzare le prestazioni nei giochi, con aggiornamenti frequenti per supportare nuovi titoli. I driver NVIDIA Studio, invece, sono pensati per applicazioni creative e di produttività. Questi driver migliorano la stabilità e la compatibilità con software di elaborazione grafica e di AI, come Adobe Premiere, Blender e le librerie AI.

5. Come posso verificare che PyTorch o TensorFlow riconoscano correttamente la GPU?

Dopo aver configurato il supporto CUDA, si può verificare eseguendo un semplice comando:

- In PyTorch: utilizzare `torch.cuda.is_available()`. Se restituisce `True`, significa che la GPU è rilevata correttamente.

- In TensorFlow: eseguire `tf.test.is_gpu_available()`.

6. Che vantaggi offre TensorRT per l’inferenza AI e quando conviene utilizzarlo?

TensorRT migliora l’efficienza dei modelli AI durante l’inferenza grazie a tecniche di ottimizzazione come la quantizzazione e il pruning. È particolarmente utile per applicazioni in tempo reale, come chatbot e assistenti vocali, dove la riduzione della latenza è fondamentale. TensorRT è consigliato quando si lavora con modelli pre-addestrati che richiedono tempi di risposta rapidi.

7. NVIDIA Studio è compatibile solo con applicazioni Adobe o anche con altri software?

NVIDIA Studio è compatibile con una vasta gamma di software creativi e di produttività, non solo Adobe. Supporta anche applicazioni come Blender, DaVinci Resolve, Topaz Labs, e molte altre che sfruttano funzionalità AI per migliorare la qualità visiva e ridurre i tempi di elaborazione.

8. È sicuro utilizzare ChatRTX per contenuti riservati?

Sì, ChatRTX è progettato per elaborare contenuti in locale, garantendo che i dati non vengano trasferiti su server esterni. La configurazione di ChatRTX offre anche opzioni avanzate per impostazioni di privacy, assicurando che sia adatto per l’uso con documenti sensibili.

9. Come posso ottimizzare un flusso di lavoro creativo sfruttando al massimo la GPU NVIDIA RTX?

Per ottimizzare il flusso creativo:

- Abilitare il rendering GPU nelle impostazioni dei software di elaborazione visiva.

- Utilizzare i filtri AI per migliorare immagini e video (come la riduzione del rumore e la super-risoluzione).

- Mantenere i driver NVIDIA Studio aggiornati per beneficiare degli ultimi miglioramenti e supporto alle applicazioni AI.