In questi ultimi anni l’espressione data mining è passata un po’ di moda e le software house preferiscono usarne altre apparentemente più di tendenza, come analytics o meglio ancora Big Data analytics.

In realtà dal punto di vista tecnico data mining resta un’espressione pienamente valida perché è generica e non legata strettamente al tipo di soluzioni per cui si è iniziato a usarla, verso la metà degli anni Novanta.

Nell’interpretazione più comune, il data mining comprende tutti i passi necessari per esaminare grandi quantità di dati alla ricerca di correlazioni fra loro e di schemi ripetitivi e trend, usando metodi matematico-statistici. L’idea di fondo, ben nota, è che in questo modo le aziende possano sviluppare una maggiore conoscenza per risolvere problemi o generare nuove opportunità di business.

Il data mining può essere applicato in qualsiasi ambito di mercato. Lo è molto nel retail per identificare i prodotti che più probabilmente saranno acquistati in futuro. Il mondo finanziario lo applica per sviluppare nuovi prodotti in funzione delle caratteristiche dei clienti, il manufacturing per migliorare la produzione, l’ecommerce per identificare le frodi online e così via.

La differenza sostanziale rispetto al passato è che oggi il data mining viene considerato soprattutto in funzione predittiva. Non serve cioè solo a capire meglio cosa sia successo in passato (scoprendo ad esempio che un picco di vendite era legato a una particolare azione di marketing) ma a rilevare informazioni per prevedere cosa succederà in futuro, ad esempio mettendo in evidenza i trend di acquisto dei clienti.

La differenza sostanziale rispetto al passato è che oggi il data mining viene considerato soprattutto in funzione predittiva. Non serve cioè solo a capire meglio cosa sia successo in passato (scoprendo ad esempio che un picco di vendite era legato a una particolare azione di marketing) ma a rilevare informazioni per prevedere cosa succederà in futuro, ad esempio mettendo in evidenza i trend di acquisto dei clienti.

Inoltre è aumentato il peso che nei processi di data mining hanno le tecniche di machine learning e intelligenza artificiale, oggi molto più sviluppate di un paio di decenni fa.

Tecnicamente è importante ricordare che il data mining è un processo che comprende molte fasi e non solo l’analisi dei dati in sé, un po’ come analytics indica un approccio alla creazione di conoscenza e non, anche in questo caso, la sola attività di analisi. Ciascuna delle fasi del processo ha un suo scopo preciso e anche punti critici peculiari.

Ci sono molti modelli ideali più o meno complessi del data mining. Di solito si considera che il primo passo sia la creazione del dataset specifico da esaminare (il preprocessing), seguito dalla fase di pulizia (cleansing) e preparazione (preparation) dei dati stessi in modo che siano corretti, completi e privi di datapoint anomali che non darebbero informazioni veritiere.

In molti ambienti IT queste fasi sono complesse perché i dati da esaminare provengono da molte fonti diverse, anche idealmente in real time, e richiedono quindi operazioni di integrazione e gestione ad alte prestazioni.

La fase vera e propria di analisi va alla ricerca delle regolarità e delle correlazioni nel dataset. I software di data mining cercano gli elementi che sono spesso associati (ad esempio prodotti acquistati regolarmente insieme) e quelli che sono in qualche modo simili (clustering). In alcuni casi si procede anche a una classificazione degli elementi, cercando di stabilire a quali categorie predefinite appartengano.

La fase vera e propria di analisi va alla ricerca delle regolarità e delle correlazioni nel dataset. I software di data mining cercano gli elementi che sono spesso associati (ad esempio prodotti acquistati regolarmente insieme) e quelli che sono in qualche modo simili (clustering). In alcuni casi si procede anche a una classificazione degli elementi, cercando di stabilire a quali categorie predefinite appartengano.

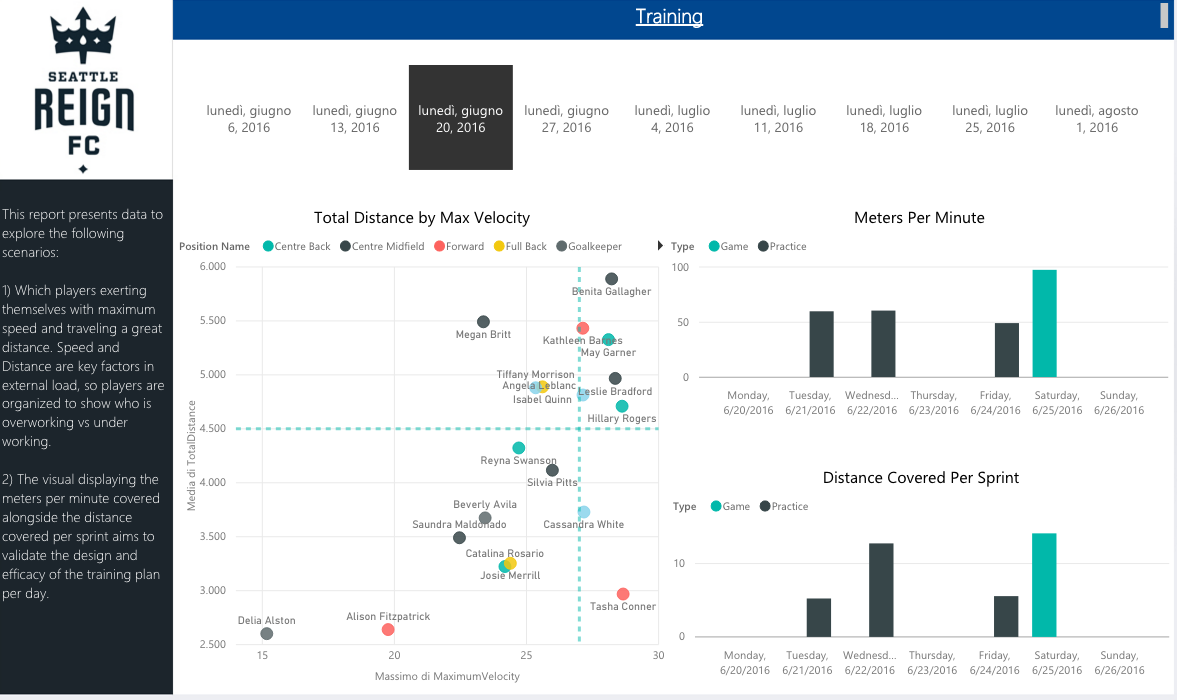

Spesso si operano poi operazioni di regressione, alla ricerca di una formula matematica che colleghi fra loro i dati del campione e permetta di prevederne valori futuri con un basso margine di errore. Infine, una parte importante del data mining sta nella visualizzazione “comprensibile” dei risultati raggiunti. Grafici e report sono il modo spesso ideale per mostrarli a chi non sia un data analyst o un esperto di statistica.

La tutela dei dati

Chi fa data mining sta poi prendendo sempre più confidenza con un tema che non è tecnico ma che è coinvolto in molte analisi dei dati: la privacy. Quando i dataset analizzati comprendono informazioni su persone e sui loro comportamenti, è legalmente necessario che le analisi siano anonime, ossia che non permettano di identificare precisamente singoli o gruppi di persone.

Questo non è sempre semplice. Anche se qualsiasi tool di data mining di un certo livello ha le funzioni di mascheramento che servono ad “anonimizzare” i dati, le successive operazioni di selezione e aggregazione dei dati stessi possono poi portare a una identificazione indiretta. Si rischia quindi di violare norme come la GDPR senza volerlo.

Altro tema: la sicurezza dei dati. Trattandosi molto spesso di informazioni critiche per il business e di dati personali, per ragioni ovvie e per le normative è necessario che i dati oggetto di analisi siano protetti da sottrazioni e manipolazioni indebite.