Nel corso di un evento svoltosi a New York il 10 ottobre, Dell Technologies ha presentato la propria strategia per l’IoT, racchiusa nel titolo IQT – Making Things Smarter. Un gioco di parole tra IQ, Quoziente di Intelligenza e IoT, che sottolinea il focus sulle capacità di analisi ed elaborazione dei grandi flussi di dati provenienti dai dispositivi IoT che verranno rese disponibili nei vari strati dell’ecosistema.

“IoT sta cambiando profondamente il nostro modo di vivere, quello con cui operano le organizzazioni e come funziona il mondo. Dell Technologies sta tracciando la strada per i nostri clienti con una nuova architettura di computing distribuita che unisce IoT e intelligenza artificiale in un ecosistema interdipendente dal confine, l’edge, al nucleo del cloud (il core). Le implicazioni per la nostra società globale saranno assai profonde” dice Michael Dell – fondatore della società e attuale Chairman e Ceo – nell’intervento di apertura dell’evento, annunciando la costituzione di una nuova divisione IoT.

Sarà guidata dal CTO di VMware Ray O’Farrell, e avrà il compito di condurre lo sviluppo dei prodotti e dei servizi IoT attraverso tutte le società del gruppo, combinando le tecnologie sviluppate internamente con l’offerta proveniente dal vasto ecosistema dei partner per fornire ai client soluzioni complete.

Nei prossimi tre anni Dell Technologies intende investire 1 miliardo di dollari in nuovi prodotti, soluzioni, laboratori, programmi per i partner ed ecosistema.

“Da tempo Dell Technologies ha individuato l’opportunità derivanti dal mondo in rapida crescita dell’IoT, grazie alla sua importante esperienza nel mercato dell’edge computing”, ha dichiarato Ray O’Farrell.

“La nostra nuova divisione IoT userà la potenza di tutto il gruppo per essere sicuri di fornire la soluzione giusta, in combinazione con l’ampio ecosistema dei partner, in grado di andare incontro ai bisogni dei clienti e aiutarli a implementare sistemi IoT integrati con la massima facilità”.

Il pendolo centralizzato/decentralizzato

Il modello di distribuzione dell’elaborazione oscilla con frequenza abbastanza regolare tra centralizzazione e decentralizzazione. In principio era il mainframe, ben al sicuro all’interno del data center, sul quale era concentrata tutta l’elaborazione e il controllo.

L’avvento dei PC ha portato una progressiva distribuzione dell’elaborazione, effettuata in buona parte sul client, ma il public cloud, visto come entità unica, ha di nuovo spostato verso un unico luogo dove, grazie alle sofisticate tecniche di virtualizzazione ora disponibili, implementare rapidamente data center complessi e scalabili.

Siamo tutti disposti ad attendere qualche istante per completare una transazione online, anche se dalla velocità di esecuzione dipende la soddisfazione dell’utente e la propensione quindi a tornare su quel sito. Quando ci spostiamo però verso le applicazioni di controllo di impianti, di veicoli, di reti di distribuzioni di energia, dal tempo di esecuzione di un’operazione dipende la correttezza dell’applicazione: il cloud basato sull’internet tradizionale non è intrinsecamente in grado di garantire il real time, per quanto ampia possa essere la banda a disposizione e veloci le connessioni. È quindi necessario un approccio a tre strati: Edge, Core e Cloud.

L’Edge, il confine della rete, è dove gli oggetti sono connessi: sensori di temperatura, telecamere di sorveglianza, robot, misuratori, in fabbriche, strade, campi, ambienti potenzialmente pericolosi. Gli oggetti connessi generano dati e li inviano a sistemi di elaborazione embedded oppure a infrastrutture IT in vicinanza o al cloud, affinché siano elaborati e analizzati. Gli edge gateway riducono il traffico verso la rete ed eseguono elaborazioni di base come l’aggregazione, il filtraggio dei dati e la loro elaborazione con motori a regole o algoritmi inferenziali.

Nel Core, le risorse di calcolo e di memorizzazione non hanno gli stessi vincoli di costo, spazio e potenza dei dispositivi edge e dei gateway. Pertanto è possibile un ordine più elevato di intelligenza e un più complesso processo decisionale. Poiché il numero di sensori cresce in modo esponenziale e il volume totale dei dati diviene troppo grande per trasportarlo verso il cloud, i problemi di latenza, nonché i costi della banda, rischiano di diventare insormontabili. Il core riduce quindi la quantità di dati che deve essere trasmessa via Wan verso il cloud e dispone di intelligenza scalabile per generare insight e istruire le macchine per intraprendere azioni in tempo reale.

Il Cloud è il luogo più logico per l’elaborazione e l’analisi su larga scala, utilizzando il deep learning per raccogliere intuizioni preziose e attive che guidano i modelli analitici nell’edge e arricchiscono il machine learning nel core. I costi dei servizi basati su intelligenza artificiale disponibili sul cloud sono in continua discesa, consentendo una più rapida adozione dell’IA. Questa intelligenza che proprio grazie all’enorme quantità di dati elaborata si accresce progressivamente è in grado di guidare l’edge, quasi come un coach allena i suoi atleti.

L’offerta di Dell si estende a tutti e tre i layer dell’architettura IoT.

Già in produzione sono gli Edge Gateways, server Intel Atom adatti all’installazione in ambienti ostili e in grado di acquisire dati via Lan, WiFI, Bluetooth, interfacce seriali, Zigbee e CAN Bus, che possono essere resi sicuri e gestiti con VMware Pulse IoT Control Center.

I server Dell EMC PowerEdge Serie C sono stati ottimizzati per potervi eseguire training batch e machine learning come parte del core distribuito.

VMware Pulse IoT Center è una soluzione per la gestione di infrastrutture IoT sicura e di livello enterprise che consente il completo controllo dall’edge al cloud. Consiste di due componenti primari, una console lato server e una serie di agent lato client. La console, dotata di API per l’integrazione di funzionalità offerte da terze parti, fornisce allarmi e notifiche sul funzionamento dell’infrastruttura esplorabile in forma gerarchica, e soprattutto un backend per la gestione dei singoli device, la loro configurazione e aggiornamento software. L’agente risiede sugli IoT gateway e sui sistemi edge, invia dati al server e riceve pacchetti, modifiche di configurazione e aggiornamenti software.

Dell EMC Isilon, la piattaforma NAS per storage backup e archiviazione di dati non strutturati, scalabile fino a 50 petabyte in un singolo filesystem, ed Elastic Cloud Storage, forniscono storage massivo per file e oggetti e abilitano gli analytics tramite HDFS (Hadoop Distributed File System), il file system distribuito scritto in Java per il framework Apache Hadoop.

Le applicazioni di analisi dei dati trovano secondo Dell una piattaforma ideale in Pivotal Cloud Foundry e Pivotal Container Service. PCF Service di Virtustream offre un servizio gestito Pivotal Cloud Foundry semplificando il deployment e le operazioni di carichi di workload mission critical su cloud in Virtustream Enterprise Cloud, mentre è disponibile Virtustream Storage Cloud per lo storage di oggetti.

Dell Boomi, la piattaforma di enterprise integration offerta come servizio cloud (Enterprise Integration Platform as a Service) permette l’integrazione e la connessione dei dati di fonte IoT con quelli enterprise per migliorare gli analytics cloud based e il deep learning.

Progetti in corso

Dell ha poi annunciato nuove linee di sviluppo: Project Nautilus, un software che abilita l’acquisizione e l’interrogazione di flussi di dati provenienti da gateway IoT in tempo reale. I dati possono successivamente essere archiviati in storage file o object-based per analisi più approfondite.

“Lo storage è una piattaforma chiave per supportare l’IoT perché c’è un bisogno reale per le imprese di memorizzare e analizzare imponenti quantità di dati di tipo differente che arrivano da fonti multiple”, dichiara Manuvir Das, senior vice president e general manager di Dell EMC Unstructured Storage. “Le infrastrutture legacy non stono state progettate per supportare questo tipo di caso d’uso, ed è per questo che stiamo sviluppando il Progetto Nautilus, un ecosistema tecnologico per analizzare file, oggetti e flussi di dati IoT in tempo reale per aiutare a scoprire nuove informazioni utili per il business“.

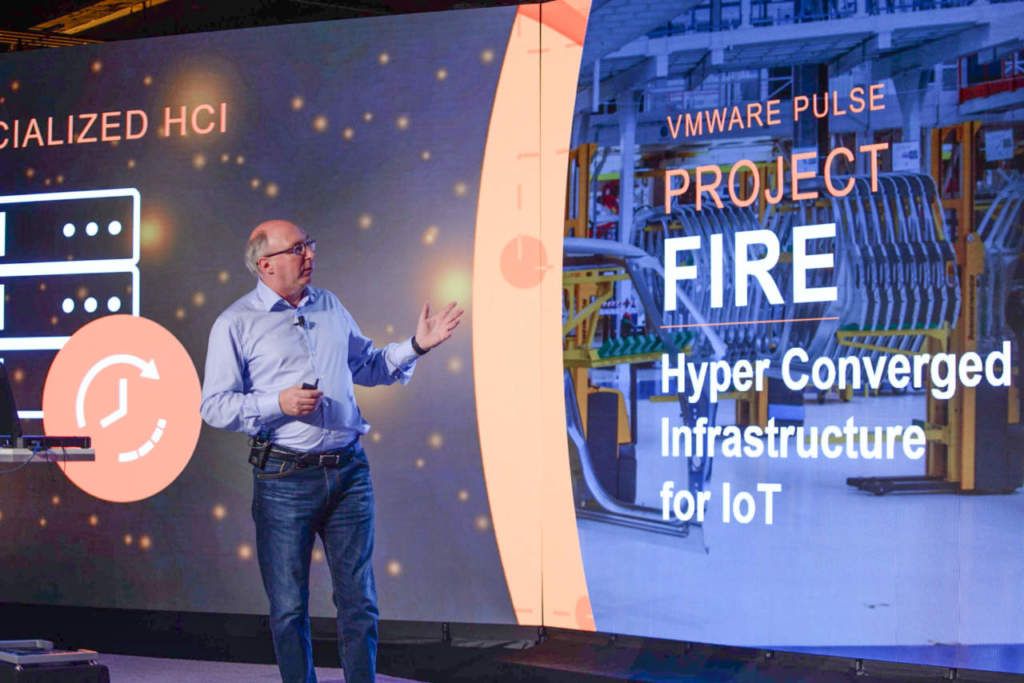

Project Fire è invece una piattaforma iperconvergente che farà parte della famiglia Vmware Pulse.

“Gartner prevede che entro il 2022, il 75% dei dati generati dalle imprese saranno creati e processati al di fuori del data center o del cloud, in crescita rispetto al 10% attuale. Perché ciò accada è necessario che i dispositivi edge abbiano capacità di elaborazione e memorizzazione sufficiente per gli edge analytics che la maggior parte degli oggetti e dei sensori – telecamere, luci, misuratori – non hanno”, sostiene Mimi Spier, vice president IoT di VMware. “È qui che l’iperconvergenza all’Edge può cambiare le regole del gioco. A VMWare stiamo prendendo il concetto di virtualizzazione che ha avuto così grande successo nei data center e portandolo all’edge. Fornendo capacità di elaborazione, storage e rete a questi piccoli microdatacenter si possono realizzare I benefici di un’architettura IoT completamente distribuita, nella quale l’analisi è suddivisa tra cloud ed edge in funzione delle necessità, godendo al contempo degli stessi benefici della virtualizzazione già presente nel cloud, abbassando il TCO e offrendo scalabilità“.

Ai laboratori di RSA, la società specializzata in sicurezza, acquisita insieme a EMC nel 2016, il compito di sviluppare Project Iris che intende estendere verso l’edge la Security Analytics per fornire visibilità delle minacce e monitoraggio. Project Iris è costruito utilizzando la piattaforma EdgeX Foundry, un progetto open source guidato dalla Linux Foundation che ha l’obiettivo di fornire una piattaforma IoT comune per l’edge computing. RSA è membro dell’EdgeX Foundry Alliance.