Google Cloud ha annunciato la preview di BigLake, uno storage engine per data lake, progettato per rimuovere i limiti dei dati e unificare data warehouse e data lake.

La gestione dei dati attraverso lake e warehouse disparati – sottolinea Google Cloud – crea silos e aumenta i rischi e i costi, soprattutto quando i dati devono essere spostati.

BigLake permette alle aziende di unificare i loro data warehouse e lake per analizzare i dati senza preoccuparsi del formato o del sistema di archiviazione sottostante, il che elimina la necessità di duplicare o spostare i dati e riduce i costi e le inefficienze.

Con BigLake, i clienti ottengono controlli di accesso a grana fine, con un’interfaccia API che abbraccia Google Cloud e formati di file aperti come Parquet, insieme a motori di elaborazione open source come Apache Spark.

Queste capacità estendono un decennio di innovazioni di BigQuery ai data lake su Google Cloud Storage, per abilitare un’architettura flessibile e conveniente di open lake house.

Twitter – ha affermato Google Cloud – utilizza già le capacità di archiviazione con BigQuery per rimuovere i limiti dei dati e comprendere meglio come le persone usano la sua piattaforma, e a quali tipi di contenuti potrebbero essere interessati.

Come risultato, aggiunge Google Cloud, Twitter è in grado di servire contenuti attraverso trilioni di eventi al giorno con una pipeline di annunci che esegue più di tre milioni di aggregazioni al secondo.

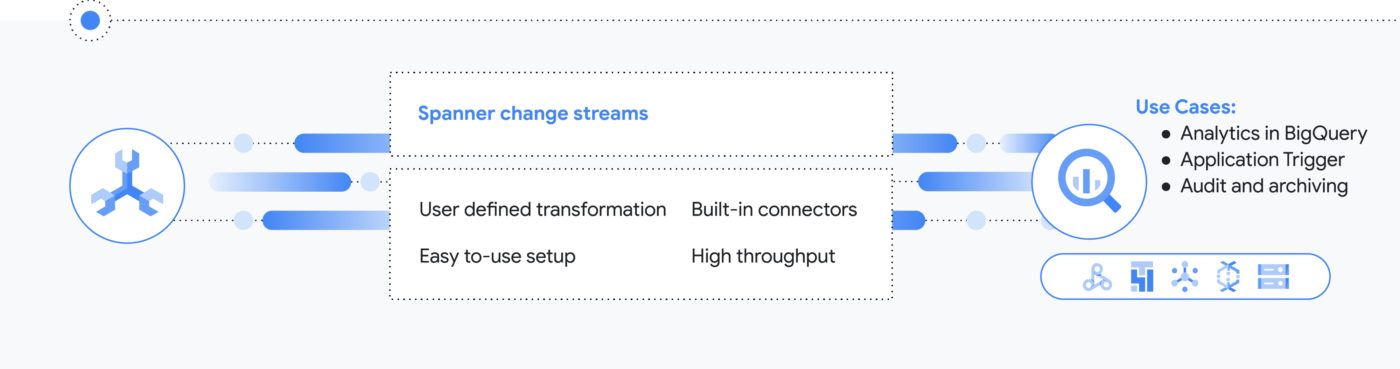

Un’altra importante innovazione riguardanti i dati che Google ha annunciato è Spanner change streams.

Prossimamente – ha annunciato Google Cloud –, questo nuovo prodotto eliminerà ulteriormente i limiti di dati per i clienti della piattaforma, permettendo loro di tracciare i cambiamenti all’interno del loro database Spanner in tempo reale al fine di sbloccare nuovo valore.

Spanner change streams traccia gli insert, update e delete per fare lo stream delle modifiche in tempo reale attraverso l’intero database Spanner di un cliente.

Questo – mette in evidenza Google Cloud – assicura che i clienti abbiano sempre accesso ai dati più freschi, in quanto possono facilmente replicare le modifiche da Spanner a BigQuery per la real-time analytics, triggerare il comportamento delle applicazioni a valle utilizzando Pub/Sub, o memorizzare le modifiche in Google Cloud Storage (GCS) per la conformità.

Con l’aggiunta di change streams – ha sottolineato ancora Google Cloud –, Spanner, che attualmente elabora oltre 2 miliardi di richieste al secondo di picco, con una disponibilità fino al 99,999%, ora offre ai clienti infinite possibilità di elaborare i loro dati.

L’obiettivo di Google Cloud con queste innovazioni, è la rimozione di tutti i limiti di dati.

Nel contesto attuale, i dati esistono in molti formati, sono forniti in flussi in tempo reale e si estendono in molti diversi data center e cloud, in tutto il mondo.

Dall’analytics, all’ingegneria dei dati, all’intelligenza artificiale e machine learning, alle applicazioni guidate dai dati, i modi in cui sfruttiamo e condividiamo i dati continuano ad espandersi.

I dati sono andati oltre l’analista e ora hanno un impatto su ogni dipendente, ogni cliente e ogni partner, mette in evidenza Google Cloud.

Con la drastica crescita della quantità e dei tipi di dati, dei carichi di lavoro e degli utenti, secondo Google Cloud siamo ora a un punto di svolta in cui le architetture di dati tradizionali – anche quando sono implementate nel cloud – non sono in grado di sbloccare il loro pieno potenziale.

Di conseguenza, il divario dati-valore sta crescendo.

Ed è per affrontare queste sfide che Google Cloud sta introducendo queste innovazioni di data cloud progettate per permettere ai clienti GCP di lavorare con dati illimitati, attraverso tutti i carichi di lavoro, ed estendere l’accesso a tutti.