Con un post sul suo blog ufficiale di Demis Hassabis, CEO e Co-Founder di Google DeepMind, e un commento di Sundar Pichai, CEO di Google e Alphabet, Google ha presentato Gemini, che l’azienda descrive come il modello AI più grande e capace che abbia mai costruito.

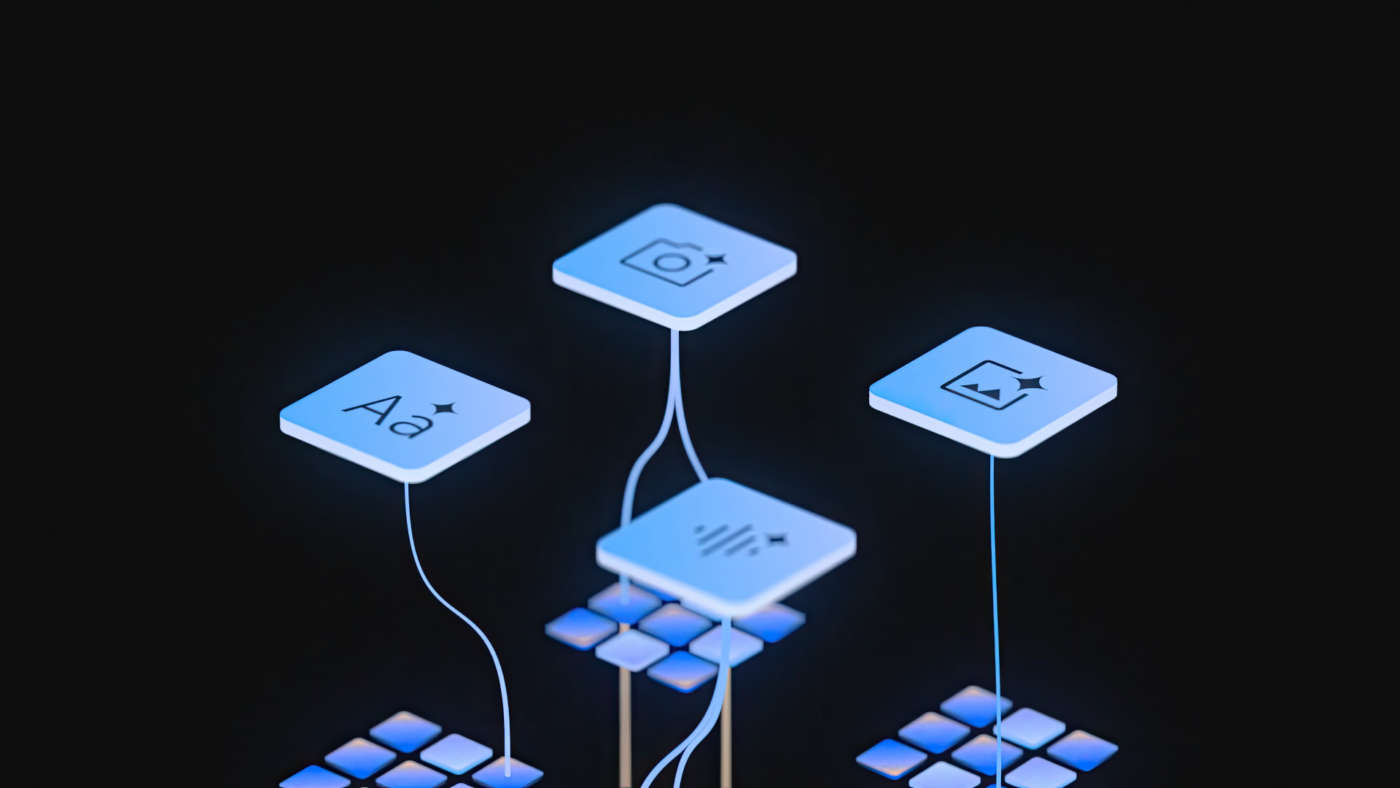

Gemini – spiega Big G – è stato costruito fin dalle sue fondamenta per essere multimodale, il che significa che può generalizzare, comprendere, operare e combinare senza discontinuità diversi

tipi di informazioni, tra cui testo, immagini, audio, video e codice informatico.

Ma non solo: Gemini è anche il modello più flessibile di Google fino a oggi, in grado di funzionare in modo efficiente ovunque, dagli smartphone ai data center. Le sue funzionalità all’avanguardia miglioreranno in modo significativo il modo in cui gli sviluppatori e le aziende costruiscono e scalano i loro progetti con l’intelligenza artificiale, assicura l’azienda.

Google ha ottimizzato Gemini 1.0, la prima versione del modello, per tre dimensioni diverse:

- Gemini Ultra – il modello più grande e potente, per compiti altamente complessi.

- Gemini Pro – il modello migliore per essere applicato su scala a un’ampia gamma di attività.

- Gemini Nano – il modello più efficiente per attività da svolgere su un singolo dispositivo (on-device).

Google sottolinea di aver testato rigorosamente i suoi modelli Gemini e valutato le loro prestazioni su una grande varietà di task. Dalla comprensione naturale delle immagini, dell’audio e dei video, al ragionamento matematico, le prestazioni di Gemini Ultra secondo l’azienda superano i migliori modelli oggi disponibili in 30 dei 32 benchmark accademici di settore utilizzati più comunemente nella ricerca e sviluppo dei grandi modelli linguistici (LLM).

Con un punteggio del 90%, Gemini Ultra è il primo modello a ottenere risultati migliori delle prestazioni umane in ambito MMLU (massive multitask language understanding; comprensione linguistica multitasking su larga scala), che utilizza una combinazione di 57 materie tra cui matematica, fisica, storia, diritto, medicina e etica, per valutare sia le conoscenze che le capacità di risoluzione dei problemi.

Il nuovo approccio in MMLU permette a Gemini, afferma Google, di utilizzare le sue capacità di ragionamento per valutare più attentamente prima di rispondere a domande difficili, con miglioramenti notevoli rispetto a una risposta più immediata.

Gemini Ultra ha ottenuto anche un punteggio all’avanguardia del 59,4% sul nuovo benchmark MMMU, che consiste in compiti multimodali che spaziano tra differenti ambiti che richiedono capacità di elaborazione complesse.

Con i benchmark per le immagini che l’azienda ha utilizzato, Gemini ha superato i precedenti modelli più avanzati, senza l’assistenza di sistemi di riconoscimento ottico dei caratteri (OCR) che estraggono il testo da un’immagine per successive analisi. Questi benchmark evidenziano la multimodalità nativa di Gemini e indicano i primi segni delle complesse capacità di ragionamento di Gemini, secondo Google, che condivide ulteriori dettagli nel report tecnico del modello.

Fino ad ora, mette in evidenza l’azienda, l’approccio standard alla creazione di modelli multimodali prevedeva l’addestramento separato di componenti dedicate a ciascuna modalità, e un loro successivo raccordo per imitare approssimativamente alcune forme di multimodalità. Questi modelli a volte possono essere efficaci nello svolgimento di determinati compiti come la descrizione delle immagini, ma hanno difficoltà con ragionamenti più concettuali e complessi.

Google ha invece progettato Gemini per essere nativamente multimodale, pre-addestrato fin dall’inizio su diverse modalità. Successivamente, il team ha affinato il modello con dati multimodali aggiuntivi per perfezionare ulteriormente la sua efficacia. Questo permette a Gemini di comprendere e ragionare su ogni tipo di input in modo strutturale e senza discontinuità, un sistema di gran lunga migliore rispetto ai modelli multimodali esistenti: le sue capacità sono all’avanguardia in quasi tutti gli ambiti, assicura Google.

Le sofisticate capacità di ragionamento multimodale di Gemini possono aiutare a dare senso a complesse informazioni scritte e visive. Questo rende Gemini particolarmente abile nel fare emergere conoscenze che possono essere difficili da individuare all’interno di una grande quantità di dati.

Secondo Google, la sua straordinaria capacità di estrarre informazioni rilevanti da centinaia di migliaia di documenti attraverso la lettura, il filtraggio e la comprensione dei contenuti contribuirà a realizzare nuove scoperte ad alta velocità in molti campi, dalla scienza alla finanza.

Gemini 1.0 è stato addestrato per riconoscere e comprendere testo, immagini, audio e altro contemporaneamente, e di conseguenza comprende meglio le sfumature tra le informazioni e può rispondere a domande relative ad argomenti complicati. Questo lo rende particolarmente utile per spiegare ragionamenti complessi, per esempio in matematica e fisica.

La prima versione di Gemini è inoltre in grado di comprendere, spiegare e generare codice di alta qualità nei linguaggi di programmazione più diffusi al mondo, come Python, Java, C++ e Go. La sua capacità di lavorare su diversi linguaggi e di ragionare su informazioni complesse lo rende uno dei principali foundation model per la programmazione al mondo, sostiene Google.

L’azienda ha addestrato Gemini 1.0 sulla sua infrastruttura ottimizzata per l’intelligenza artificiale utilizzando le Tensor Processing Unit (TPU) v4 e v5e progettate internamente da Google. E lo ha progettatto per essere il suo modello più affidabile e scalabile per l’addestramento, e anche il più efficiente.

Su TPU, Gemini funziona molto più velocemente rispetto ai modelli precedenti, pur essendo questi più piccoli e meno capaci. Questi acceleratori d’intelligenza artificiale progettati su misura hanno potenziato il funzionamento dei prodotti di Google basati sull’IA come la Ricerca, YouTube, Gmail, Google Maps, Google Play e Android, utilizzati da miliardi di persone. Hanno inoltre consentito ad aziende di tutto il mondo di addestrare modelli IA su larga scala a costi contenuti.

Contestualmente, Google ha annunciato anche il sistema TPU più potente e scalabile mai realizzato, CloudTPU v5p, progettato per addestrare modelli AI di punta. Questa TPU di prossima generazione accelererà lo sviluppo di Gemini e aiuterà gli sviluppatori e le aziende a addestrare modelli di AI generativa su larga scala più velocemente, permettendo di raggiungere più rapidamente i loro clienti con nuovi prodotti e funzionalità.

Google afferma inoltre di aver posto responsabilità e sicurezza al centro, nello sviluppo di Gemini. Google ha sottolineato il suo impegno a promuovere un’intelligenza artificiale audace e responsabile in ogni progetto che realizza e, basandosi sui suoi Principi per l’IA e le solide norme per la sicurezza dei prodotti, sta aggiungendo nuove protezioni per tenere conto delle capacità multimodali di Gemini. In ogni fase del suo sviluppo, l’azienda prende in considerazione i rischi potenziali e lavora per testarli e mitigarli.

Per quanto riguarda la disponibilità, Gemini 1.0 entrerà in funzione su una varietà di prodotti e piattaforme.

A cominciare da oggi, Bard utilizzerà una versione dedicata di Gemini Pro per ragionamenti avanzati, pianificazione, comprensione e altro. Questo è l’aggiornamento più importante di Bard da quando è stato annunciato, afferma Google. Sarà disponibile in inglese in più di 170 Paesi e territori, e l’azienda prevede di aggiungere ulteriori modalità e supportare nuove lingue e aree geografiche nei prossimi mesi.

Google sta anche portando Gemini su Pixel. Pixel 8 Pro è il primo smartphone progettato per incorporare Gemini Nano, che potenzierà nuove funzionalità come Riassumi sull’app Registratore ed entrerà in Smart Reply su Gboard, a cominciare da WhatsApp, con altre app di messaggistica nell’arco del prossimo anno. Nei prossimi mesi, Gemini sarà disponibile su più prodotti e servizi Google come la Ricerca, Ads, Chrome e Duet AI.

A partire dal 13 dicembre, sviluppatori e clienti aziendali potranno accedere a Gemini Pro tramite l’API di Gemini su Google AI Studio o su Google Cloud Vertex AI.

Google AI Studio è uno strumento web gratuito pensato per gli sviluppatori che permetterà di fare prototipazione e lanciare app velocemente con una chiave API. Nel momento in cui serve una piattaforma IA fully-managed, Vertex AI permette la personalizzazione di Gemini con pieno controllo sui dati e i benefici di Google Cloud su sicurezza, privacy, data governance e compliance.

Gli sviluppatori Android potranno anche utilizzare Gemini Nano, il modello più efficiente per attività on-device, attraverso AICore, una nuova funzionalità di sistema per Android 14, a cominciare dai dispositivi Pixel 8 Pro. È ora possibile registrarsi per un’anteprima di AICore.

Per Gemini Ultra, Google sta completando un’estesa fase di test su affidabilità e sicurezza, inclusa un’attività di red-teaming da parte di soggetti esterni fidati, e sta perfezionando ulteriormente il modello utilizzando fine-tuning e training di rinforzo da feedback umano (RLHF) prima di renderlo disponibile a livello più ampio.

Come parte di questo processo, l’azienda renderà Gemini Ultra disponibile a clienti, sviluppatori e partner selezionati, per una sperimentazione iniziale, prima di distribuirlo agli sviluppatori e alle imprese clienti all’inizio del prossimo anno.

All’inizio del prossimo anno, lancerà anche Bard Advanced, una nuova esperienza di punta basata sull’IA che permetterà di accedere ai modelli migliori e alle migliori capacità, a cominciare da Gemini Ultra.