In un nuovo paper presentato alla International Solid-State Circuits Virtual Conference (ISSCC) del 2021, il team di Ibm Research ha presentato quello che Big Blue ha definito il primo chip per intelligenza artificiale ad alta efficienza energetica al mondo.

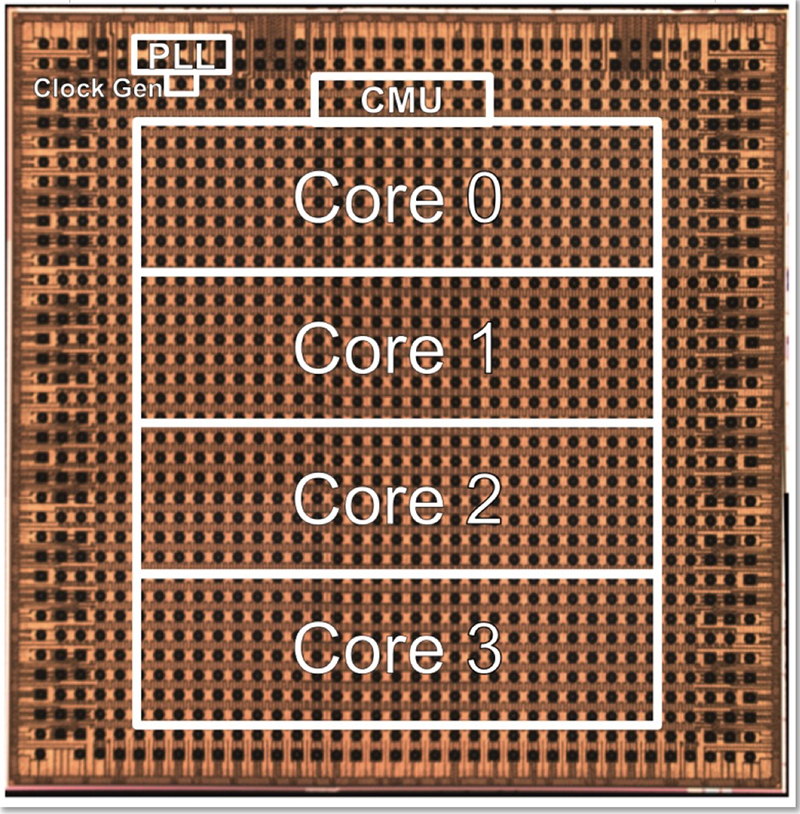

Si tratta di un chip all’avanguardia specializzato nel training e nell’inferenza e costruito con tecnologia a 7 nm. Attraverso il suo nuovo design, ha spiegato Ibm, il chip acceleratore hardware di intelligenza artificiale supporta una varietà di tipi di modelli e raggiunge al contempo un’efficienza energetica di livello elevato su tutti loro.

I mercati di utilizzo di una tale tecnologia sono sempre più estesi e diffusi: auto a guida autonoma, text to speech, servizi smart e droni di delivery solo alcune delle applicazioni più ovvie e conosciute dell’intelligenza artificiale. Per alimentare questo progresso costante, Ibm Research si è posta l’obiettivo di migliorare il cuore stesso della tecnologia hardware dell’intelligenza artificiale, il suo key enabler: i core digitali che alimentano il deep learning.

Ibm Research, ha evidenziato l’azienda di Armonk, ha fatto passi da gigante nell’adattamento alle complessità del carico di lavoro dei sistemi di intelligenza artificiale e al tempo stesso nel razionalizzare e accelerare le prestazioni, innovando attraverso materiali, dispositivi, architetture di chip e l’intero stack software, per rendere più vicini i sistemi computazionali di prossima generazione.

Questa tecnologia di chip, ha spiegato Ibm Research, può essere scalata e utilizzata per molte applicazioni commerciali: dal training di modelli su larga scala nel cloud alle implementazioni per la sicurezza e la privacy, portando l’addestramento più vicino all’edge e i dati più vicini alla fonte.

Acceleratori hardware di intelligenza artificiale ad alta efficienza energetica di questo tipo potrebbero aumentare significativamente la potenza di calcolo anche in ambienti cloud ibridi, senza richiedere enormi quantità di energia.

Il livello di sofisticazione e l’adozione dei modelli di intelligenza artificiale si sta rapidamente espandendo, ma la rapida evoluzione della complessità aumenta anche il consumo di energia. Ibm Research intende cambiare questo approccio e sviluppare un’intera nuova classe di acceleratori hardware di intelligenza artificiale ad alta efficienza energetica che aumentino significativamente la potenza di calcolo senza richiedere quantità di energia esorbitanti.

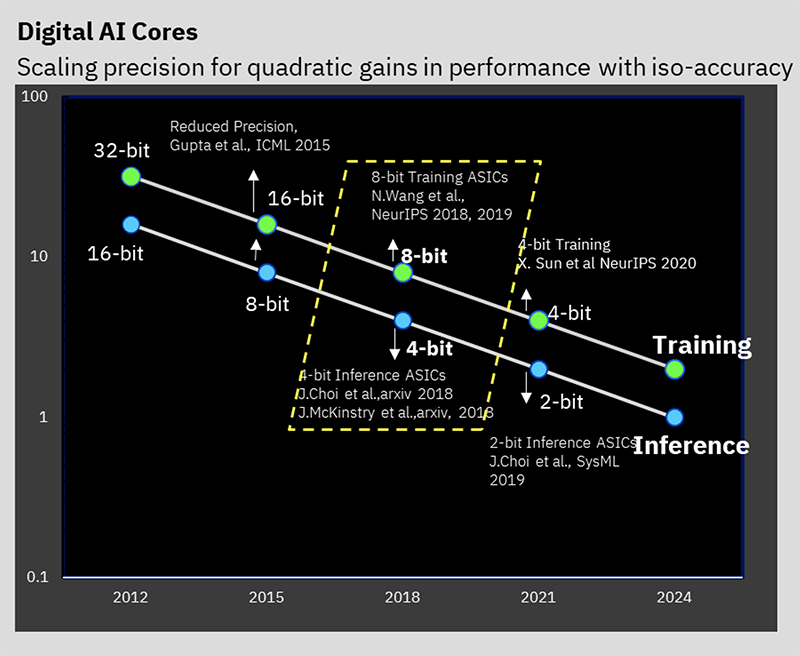

Sin dal 2015 Ibm ha costantemente lavorato per migliorare le prestazioni energetiche dei chip di intelligenza artificiale, aumentando le prestazioni energetiche di 2,5 volte ogni anno. Per fare ciò, ha creato tecniche algoritmiche che consentono il training e l’inferenza senza perdita di precisione di previsione. Ha anche sviluppato innovazioni architetturali e progettuali di chip che permettono di costruire motori di computing altamente efficienti in grado di eseguire carichi di lavoro più complessi con un alto livello di utilizzo ed efficienza energetica.

Inoltre, ha creato uno stack software che rende l’hardware trasparente allo sviluppatore di applicazioni e compatibile con l’infrastruttura cloud ibrida, dal cloud all’edge.

Il nuovo paper ISSCC riflette l’ultima fase di questi progressi, incentrata sulla creazione di un chip che è altamente ottimizzato per il training e l’inferenza a bassa precisione per tutti i diversi tipi di modelli di intelligenza artificiale, senza alcuna perdita di qualità a livello di applicazione.

Ibm Research ha mostrato diverse nuove caratteristiche del chip. Per cominciare, è il primo chip al silicio a incorporare formati FP8 ibridi a bassissima precisione (HFP8) per il training di modelli di deep learning in un nodo tecnologico al silicio all’avanguardia (chip basato su EUV a 7 nm). Inoltre, i numeri di efficienza energetica grezza sono allo stato dell’arte in tutte le diverse precisioni.

È uno dei primi chip a incorporare il power management negli acceleratori hardware di intelligenza artificiale. In questa ricerca, Ibm Research dimostra di poter massimizzare le prestazioni del chip all’interno del suo budget energetico totale, rallentandolo durante le fasi di calcolo ad alto consumo.

Infine, Ibm Research dimostra come questo chip, oltre a grandi prestazioni di picco, ha un elevato utilizzo sostenuto che si traduce in prestazioni applicative reali. I chip Ibm raggiungono abitualmente più dell’80 per cento di utilizzo per il training e più del 60 per cento di utilizzo per l’inferenza, afferma l’azienda, rispetto ai tipici utilizzi delle GPU che sono in genere ben al di sotto del 30 per cento.

Il team di Ibm Research spera di poter stabilire, attraverso questo lavoro, un modo completamente nuovo di creare e distribuire modelli di intelligenza artificiale per scalare le prestazioni e al tempo stesso tagliare significativamente il consumo energetico.