Lorenzo Moz Ortolani analizza l’impatto dell’intelligenza artificiale nella produzione musicale, evidenziando come le IA generative, attraverso il machine learning, stiano rivoluzionando la creazione musicale.

“Se le note fossero rappresentate da numeri, e le relazioni musicali fossero espresse da operazioni matematiche, allora le macchine di Babbage potrebbero essere utilizzate per comporre musica di qualsiasi grado di complessità o estensione.” Ada Lovelace, la prima programmatrice della storia, ci aveva visto lungo: la sua lettera è datata 1843. Da allora, l’intelligenza artificiale ha compiuto passi da gigante, penetrando diversi settori, compresa l’industria musicale.

La rivoluzionaria intelligenza artificiale musicale

“Rivoluzione” nella musica è un termine ricorrente. È successo altre volte, e ci siamo domandati se il MIDI avrebbe tolto il lavoro a tutti i musicisti, se i campionatori fossero in grado di sostituire i batteristi, o gli stessi produttori di strumenti musicali. E l’autotune che fa diventare tutti intonati e anche le capre possono cantare? Beh, in parte è vero e c’è stato un ridimensionamento, ma i batteristi bravi esistono ancora, i produttori di batterie altrettanto, i cantanti non hanno perso credibilità (capre incluse) e questi nuovi strumenti sono diventati parte integrante del flusso di lavoro compositivo. Si usano quando il musicista o il produttore ne sente il bisogno e perché no, anche tanto per trovare ispirazione. Sono strumenti che hanno ampliato le capacità espressive, come succedeva, succede e succederà con le nuove tecnologie. In fondo siamo esseri umani che scrivono musica per altri esseri umani, che nel mezzo ci siano macchine per semplificare, migliorare, o velocizzare il lavoro, poco conta. Conta il risultato, che generalmente dipende dal giudizio finale degli ascoltatori.

Con una certa dose di ironia, citiamo il famoso produttore Steve Albini: “L’intelligenza artificiale non sostituirà artisti e scrittori, lo faranno le teste vuote del management. Come sempre. Per loro, l’intelligenza artificiale è solo un altro lavoratore occasionale.”

AI isn't going to replace artists and writers, jelly minds in management are. Like always. AI is just another gigworker to them.

— regular steve albini (@electricalWSOP) June 2, 2023

Christopher Small, autore dell’interessante libro Musiking, afferma che l’automazione delle “cose” musicali è, ovviamente, solo una parte della filosofia dell’arte. Del cosiddetto “output”generato dalla AI non valutiamo l’azione, non l’atto di creare e suonare, e ancor meno quello di percepire e rispondere all’arte, ma solamente l’oggetto creato.

L’industria musicale nel suo insieme ha già disumanizzato la musica ormai da decenni. Oltre all’uso e abuso dell’autotune à la Cher, usato oggi dalla maggior parte delle produzioni rap/R&B, il 99% delle tracce vocali contemporanee vengono intonate alla perfezione con strumenti come Melodyne o simili. La batteria viene regolarmente tagliata, ricomposta e messa “in griglia” (temporale), i timbri vengono stravolti usando campioni esterni. In molti casi i campioni sostituiscono completamente la batteria originale registrata in studio. Oppure le batterie vengono programmate per poi usare le funzioni “Humanize” presenti in tante DAW per dargli quel pizzico di tocco umano. Le parti orchestrali vengono suonate con la tastiera o con il campionatore, e da ormai mezzo secolo vengono importati pezzi di brano da brani di altri artisti, rielaborati e remixati, come I famosi Break Beats dell’Hip-hop.Vengono tolti i respiri dal cantato o le imprecisioni esecutive, intere frasi vengono copiate e incollate nella sequenza temporale per mantenere le cose coerenti e precise, certi strumenti vengono suonati e/o emulati suonando altri strumenti, fischiettando, eccetera eccetera…

Contemporaneamente, più si lavora sulla precisione più si riscopre l’imprecisione. E ben venga il ritorno della distorsione armonica, della scordatura e delle ritmiche strambe e storte. Mettiamola così: ce n’è per tutti i gusti, e forse oggi, con l’AI, apprezzeremo ancora un po’ di più “l’essere umani”.

Breve premessa sul funzionamento

Un primo concetto da includere nel nostro viaggio è che le IA di cui parliamo in seguito sono IA Generative (GenAI, o GAI, da non confondere con le AGI), “imitative” delle intelligenze umane, ovvero utilizzano conoscenze umane, dati generati da esseri umani, per creare nuove interpretazioni delle stesse o per amplificare le conoscenze stesse, trovando ad esempio pattern tra grandi quantità di dati.

L’IA generativa musicale non fa riferimento a una tecnologia specifica, ma piuttosto a innumerevoli tecniche di machine learning (ML) in grado di apprendere dai dati e migliorare le prestazioni di un certo algoritmo senza essere esplicitamente programmate per un compito specifico. Questo modo di programmare senza un programma nasce nei primi del ’900, grazie alle geniali intuizioni di uno scienziato russo, che ha escogitato una maniera di prevedere la probabilità di diversi esiti basandosi su stati precedenti, chiamate Reti di Markov.

Poi è arrivato il Deep Learning, una sottocategoria del machine learning che impiega reti neurali con molti strati sovrapposti per elaborare grandi quantità di dati complessi, e il natural language processing (NLP), che permette ai computer di comprendere, classificare, interpretare e generare linguaggio umano, oltre a intricati database vettoriali per memorizzare la conoscenza generata dalle enormi moli di dati, chiamati dataset.

Interpretando l’acronimo GPT, possiamo comprendere l’attuale stato dell’arte delle IA. G sta per Generativa, P per Pre-trained, ovvero Pre-addestrata, e T, la vera novità, sta per Trasformativa. I trasformatori (Transformers), introdotti nel 2017 da una ricerca pubblicata da Google, erano nati per trasformare un testo da una lingua all’altra. Oggi sono in grado di trasformare, ad esempio, una descrizione testuale in un’immagine o in un suono o una voce, una domanda in una risposta, un testo parlato in testo scritto eccetera eccetera. Questa è la vera forza delle IA Generative.

I singoli dati che le IA memorizzano vengono caricati in database vettoriali che collegano i pezzi di informazione, chiamati token, in uno spazio n-dimensionale. Poi ci sarebbero i parametri di tuning e le reti RNN, CNN, GRU, GAN… ok, probabilmente stiamo esagerando con la terminologia e si enterebbe in una foresta infinita di acronimi e tecnologie, ma ora abbiamo un glossario di base che potrà farci comodo più avanti.

Posso prevedere l’output di una IA?

Sveliamo il segreto di Pulcinella: come funzionano questi processi non lo sa bene nessuno. Non è una affermazione “nocielodicono” di complottistica memoria. Al contrario: se volessimo comprendere esattamente come mai da un input otteniamo un output, dovremmo analizzare ogni singolo step della rete neurale, su miliardi di passaggi eseguiti in parallelo, dovremmo conoscere tutto il dataset e i miliardi di parametri per il tuning interni alla AI analizzata. Sarebbe come capire perché si accende quel particolare neurone nel nostro cervello: un ago in un enorme pagliaio. Capirlo è tecnicamente non impossibile, ma avere chiara la logica è decisamente improbabile. Questo ha spesso a che fare con un termine ulteriore: la temperatura.

La temperatura regola la distribuzione di probabilità da cui il modello AI sceglie la sua azione successiva. Una temperatura vicina allo 0 focalizza la risposta a quella più probabile, se invece tende ad 1 rende l’output più casuale e, in un certo senso, originale. È una misura della creatività dell’intelligenza artificiale.

Per questo ed altri motivi, tutte le IA soffrono di allucinazioni, e a volte prendono dei grandi abbagli. Chiunque abbia usato un Large Language Model se n’è accorto almeno una volta. Per cercare di limitarle ed evitare comportamenti strani, si utilizzano dei dataset di alta qualità e in contemporanea delle infrastrutture che limitano lo spettro degli output ed evitano alle AI di agire in modo indesiderato.

Questi due motivi, oltre al fatto che difficilmente chi crea una AI commerciale ci farà mai guardare sotto il cofano, sono abbastanza per comprendere che un cervello umano non riuscirà mai a comprendere il percorso esatto del ragionamento di una IA. Qualcuno si è attrezzato per fare reverse engineering utilizzando IA ancora più potenti, una sorta di risposta alla domanda fondamentale sulla vita, l’universo e tutto quanto.

Origini della musica generativa

L’idea di legare le note ai numeri è ancestrale. Analizzando i più antichi strumenti musicali ritrovati, flauti datati circa 40 mila anni fa, si presume che esistesse già una comprensione dei rapporti tra le altezze tonali. Secondo gli insegnamenti di Pitagora e dei suoi discepoli, la musica era indissolubilmente legata ai numeri, ritenuti essenziali per comprendere l’intero universo, sia spirituale che fisico, così come le note erano strettamente legate agli astri (musica universalis). Nell’antica Grecia tra l’altro si usavano modi (sistemi di scale) per comporre musica, associando ognuno di essi a particolari stati d’animo. Erano già presenti strumenti musicali automatici, organi che usavano sistemi idraulici e pneumatici o arpe suonate dal vento, dette Arpe Eolie.

Con l’arrivo del Medioevo, la musica sacra cominciò a svilupparsi all’interno delle istituzioni ecclesiastiche, e con essa, l’uso di regole precise per la composizione. Il canto gregoriano, per esempio, seguiva regole specifiche per la modalità e la melodia. In questo periodo si sviluppò notevolmente la notazione musicale, che permetteva di trasmettere e insegnare le composizioni in modo più sistematico. Anche la notazione ha origini antiche, almeno dai tempi dei Sumeri.

Dal tardo 15esimo secolo prende piede l’uso di regole all’interno delle composizioni. Un metodo molto diffuso nell’Europa dell’epoca consisteva nel trascrivere una parte per una singola voce e fornire indicazioni ai cantanti su come sviluppare – nel tempo e polifonicamente – le altre parti vocali. Le istruzioni che indicavano le modalità di esecuzione di queste parti aggiuntive erano note come canone.

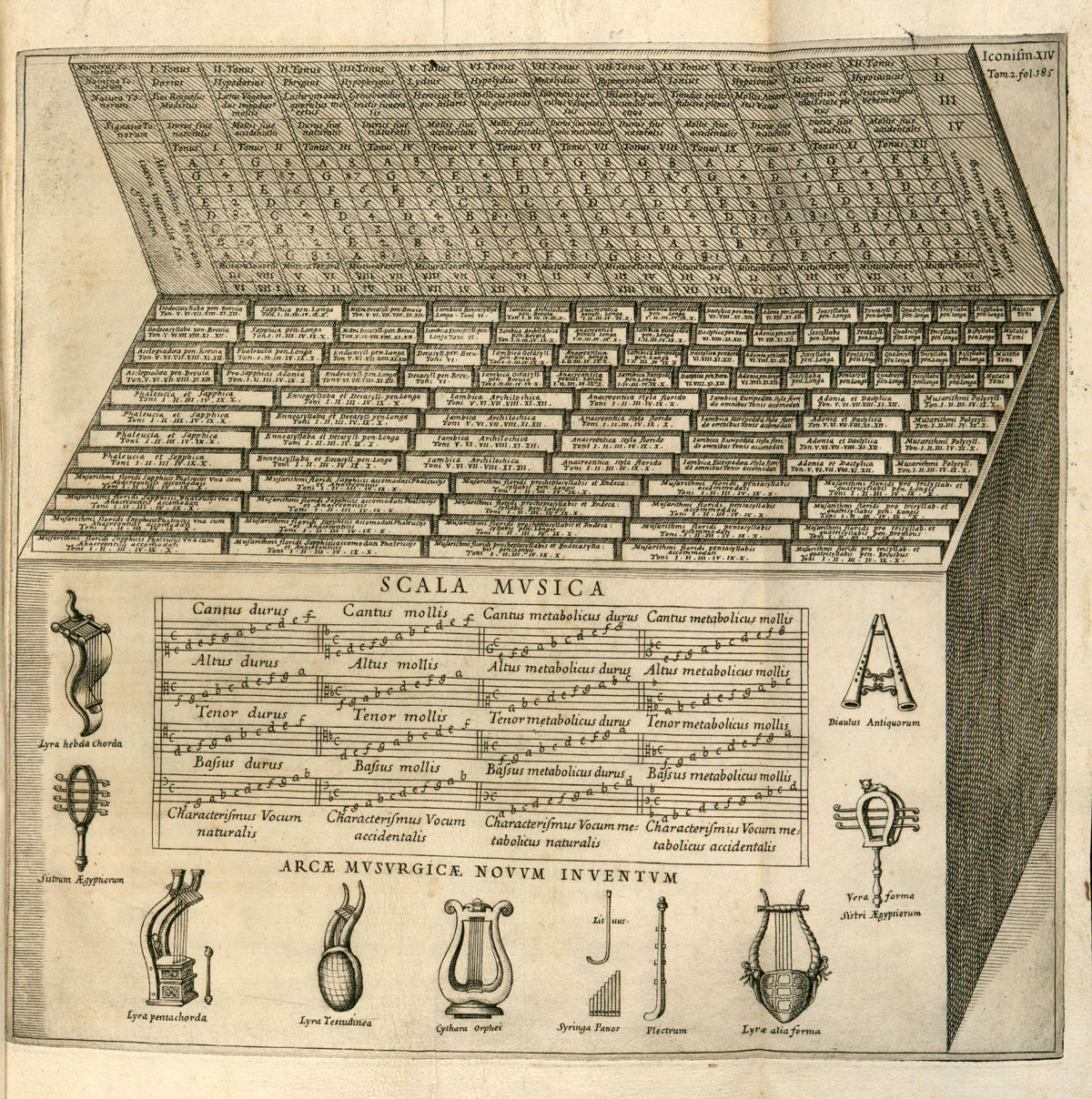

L’Arca Musarithmica di Kircher (1650 circa) consentiva anche ai non musicisti di comporre musica sacra attraverso semplici tecniche combinatorie, qui una replica digitale con cui si può sperimentare. Nell’Europa centrale dell’800 era di moda comporre musiche di intrattenimento usando la tecnica del “Musikalisches Wurfelspiel”, ovvero associando frammenti musicali di poche battute ai lanci di dadi, per comporre in modo casuale e semi-originale. Tra gli entusiasti di questi “giochi” c’era anche il caro Mozart, ma anche Bach, che aveva dei metodi tutti suoi.

Dopo Debussy e Strauss, che si definivano limitati dal sistema tonale usato fino ad allora, il ventesimo secolo ha stravolto il mondo compositivo. La crisi del sistema tonale portò alla sperimentazione di nuove modalità compositive, come la parametrizzazione di Messiaen, che anticipò il serialismo di Hauer e Schöenberg che a loro volta influenzarono i noti Stockhausen, Boulez, Ligeti, Berio, Pousseur o Nono tra gli altri.

Edgar Varèse e Luigi Russolo sperimentarono sul ritmo e sul timbro, oltre che sull’elettronica. Alcuni sperimentavano il superamento della tecnica umana. C’era Pierre Schaeffer e la sua Musica Concreta, realizzata con suoni registrati su nastri, che poi venivano manipolati nei loro parametri (altezza, timbro, velocità e altri).

Si sperimentava anche l’esaltazione del caos, l’indeterminazione e la musica aleatoria. Per fare un nome tra i tanti, John Cage interrogava continuamente i fondamenti stessi della musica. Iannis Xenakis, prima collaboratore dell’architetto Le Corbousier e poi votato alla composizione, scrisse ad esempio dei pezzi per carboni ardenti amplificati. Queste indagini influenzarono anche compositori come Shostakovich, Stravinsky, o jazzisti come Bill Evans, Yusef Lateef, fino a artisti Pop/Rock come Frank Zappa.

La vera svolta arrivò chiaramente con il computer, e si inizia a comprendere finalmente l’entusiasmo di Ada Lovelace citato in apertura. L’interesse del mondo matematico, informatico e musicale per il calcolatore fu dirompente. A seguito delle intuizioni di Richard Pinkerton che pubblicò un importante paper titolato Information Theory and Melody, già nel 1956 nacque la Illiac Suite, la prima composizione generata da un calcolatore, all’Università dell’Illinois.

Contemporaneamente, il software MUSIC di Max Mathews gettò le basi per la sintesi sonora digitale programmabile. La sintesi sviluppata da Mathews, con il mainframe IBM 704 che cantò “Daisy Daisy”, venne citata anche da Kubrik in “2001 Odissea nello Spazio” e il nome Max vive tutt’ora in MAX, software di composizione musicale molto diffuso che è oggi la naturale evoluzione di MUSIC.

David Cope creò Experiments in Musical Intelligence (EMI, 1981), un primo sistema di imitazione dello stile di musicisti famosi come Bach o Chopin, ponendo le basi di tante ricerche degli anni seguenti.

Passano gli anni, molti progetti accademici interessanti, e siamo arrivati al 2002 quando il Sony Computer Science Laboratory di Parigi crea il Continuator, un software che impara lo stile dell’esecutore e ne continua l’esecuzione quando il musicista umano si interrompe.

Dal 2010, con l’evoluzione estrema delle capacità di calcolo parallelo, del machine learning e delle reti GAN, nascono le prime startup informatico-musicali votate al gaming e al cinema/soundFX. Era anche prevedibile: si sperimenta da ormai oltre 70 anni nelle università, un primo tentativo di ingresso nel mercato è stato inevitabile, ma ha mancato la fase cosidetta di “adoption”, per complessità di implementazione, ma anche per una maturità ancora non raggiunta.

Si arriva quindi agli anni ’20, con l’avvento dei Transformer e la nascita dei primi modelli di AI generativa a cura delle Big Tech. È il momento di GPT, LLM, e di modelli generativi finalmente convincenti.

Secondo i luminari e i ricercatori la musica generata dalle macchine ha preso tre strade ben definite, già mappate da qualche decennio: generazione stocastica / probabilistica, basata su regole / algoritmica, che la macchina segue pedissequamente e quella più moderna guidata dall’IA.

Migliori di noi umani?

Esteticamente, la composizione generativa IA è agli albori e molti esperimenti rimangono lavori di ricerca, altri, come vedremo, hanno già trovato applicazioni commerciali più o meno redditizie. Come sottolinea David Cope, pioniere del campo, le prime “vie nell’automazione musicale” non hanno avuto grandi successi artistici. Tuttavia, queste innovazioni hanno aperto nuove prospettive, sguardi nuovi su un mondo che non ha mai realmente avuto paura dell’innovazione.

Secondo Iannis Xenakis, il vero successo artistico richiede più dei semplici strumenti tecnologici; è necessaria creatività, intuizione umana e una profonda comprensione dei principi fondamentali dell’arte. A suo avviso, gli artisti non dovrebbero essere ingannati pensando che la tecnologia possa sostituire l’essenza della creatività umana e della visione artistica.

Con i software odierni i compositori possono indagare i propri processi creativi, ma anche esplorare le tecniche dei compositori storici, emulando strumenti esistenti o creando nuovi suoni. Questi esperimenti sono intellettualmente stimolanti e come abbiam visto ci sono già interessanti finestre sul futuro.

Bandlab ad esempio, piattaforma cloud in cui gli artisti possono creare e condividere musica, offre uno strumento chiamato SongStarter che permette di avere suggerimenti o ispirazioni compositive allo scopo di solleticare la creatività. Nulla di troppo esoterico: questo genere di funzioni sono presenti da anni in molte DAW, ma Bandlab la inserisce sotto il cappello delle IA, e con ben 100 milioni di utenti questo genere di funzioni non passa inosservato. Certo, dire IA è piuttosto facile, implementarla realmente è un altro paio di maniche.

Gruppi come Magenta, all’interno di Google studiano proprio come implementare i processi creativi e l’interazione con l’AI.

Lo stato attuale dell’IA nella musica

Le odierne Digital Audio Workstations (DAW) hanno democratizzato la produzione musicale. Chiunque abbia un laptop, ma anche un semplice ma potente Arduino, può idealmente comporre con qualità professionale e competere con i migliori artisti a bassissimo costo.

Meglio ancora con l’IA che offre strumenti sempre più sofisticati: si possono separare le tracce vocali, strumentali e di effetti da un brano stereo, “deriverberare” ed eliminare artefatti, intonare o cambiare la tonalità delle voci e degli strumenti, sostituirle con voci diverse o trasformarle in melodie strumentali. Certo, in questo caso la potenza di calcolo necessaria aumenta esponenzialmente. Alcuni splendidi esempi sono i plugin commerciali come Izotope RX e Sony Spectralayers, o gli strumenti open source disponibili di Meta, Google, Deezer, oppure OpenVINO di Intel, già integrato in Audacity. Piattaforme come SoundCloud hanno stretto varie partnership con servizi IA di produzione musicale per la distribuzione diretta.

Poi esistono le IA definite Music AI. In pratica, text-to-image traslato in ambito musicale. Sono utili ai creatori di contenuti che hanno necessità di colonne sonore, o semplicemente materiale per giocare o creare il jingle per la propria azienda, ma possono anche generare pezzi veri e propri, con strumenti, testi, voce e cori eccetera.

Sono strumenti che in base ad un prompt generano musica. Ad esempio, basta chiedere “Musica di background per documentario sulla natura, orchestrale e sincopata per una scena di lotta tra formiche” e voilà. Pochi minuti se non secondi, modificando se necessario per affinare la richiesta, e la colonna sonora è pronta. La qualità proposta è ad un livello mediocre ma usabile, ecco un esempio:

Nel 2020 OpenAI aveva rilasciato Jukebox, ma anche il potente MusicLM di Google, o Adobe che annuncia un nuovo strumento, Adobe GenAIMusic. Per ora Suno sembra aver vinto la partita; è stato reso famoso da un articolo su Rolling Stones ed è particolarmente interessante per altri motivi: qualcuno lamenta che il training sia fatto su parecchio materiale sotto copyright.

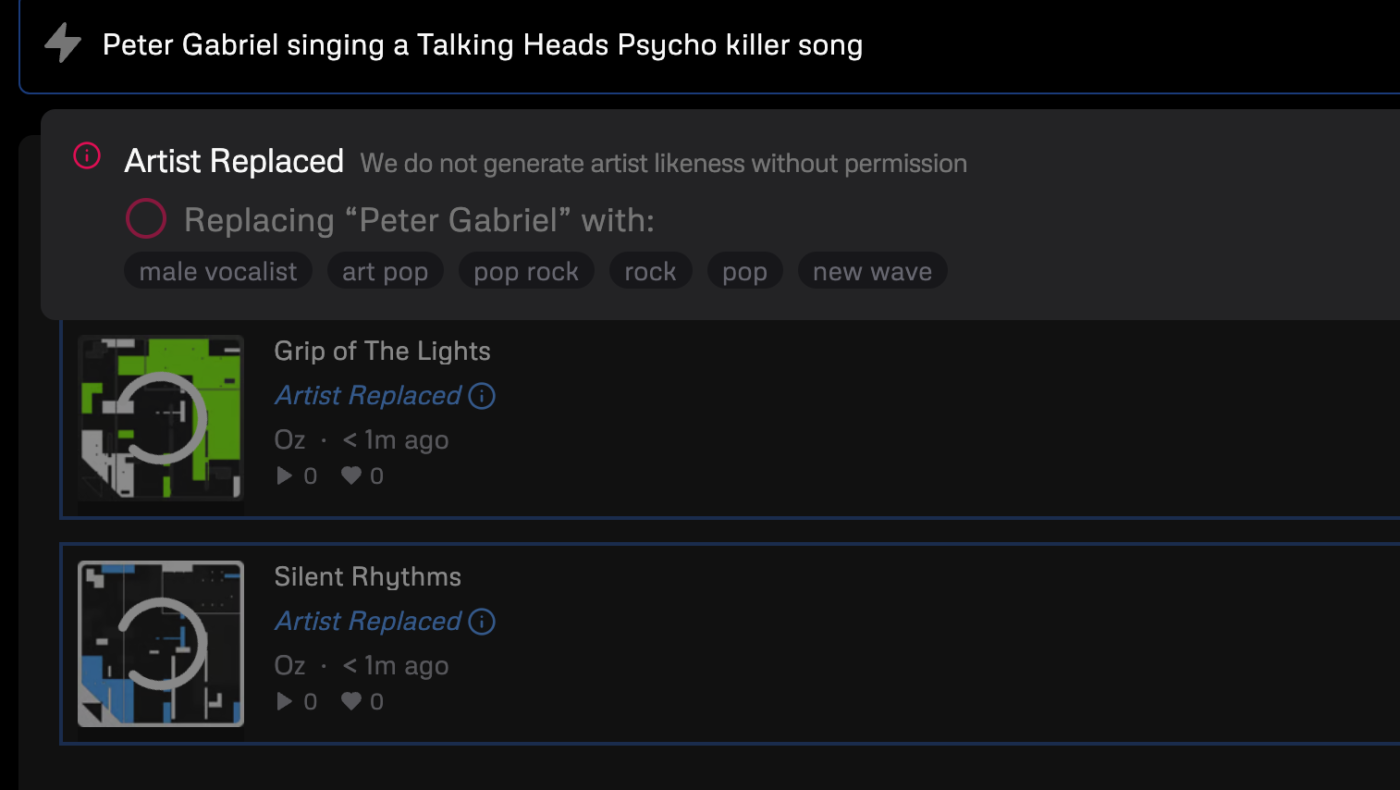

Il più recente della famiglia è stato presentato ad aprile 2024: un gruppo di ex dipendenti di DeepMind/Google ha lanciato Udio, un nuovo servizio di sintesi musicale ad alta fedeltà partendo da prompt, in grado di integrare anche i testi da cantare forniti dall’utente. I risultati sono piuttosto intriganti, con il quesito del copyright dei dataset in parte risolto in una maniera interessante: se si citano artisti o brani, Udio rammenta che “We do not generate artist likeness without permission”.

Andando nel modno delle IA “deboli”, troviamo piccole e meravigliose integrazioni di IA generativa in strumenti virtuali o plug-in per DAW come SynPlant, che sulla base di un campione audio caricato nel plug-in, riesce a ricrearne una copia verosimile con il proprio motore di sintesi per renderlo poi modificabile a piacimento. Queste tecnologie hanno pervaso la produzione musicale silenziosamente, e ben prima dell’arrivo di ChatGPT: la piattaforma di distribuzione digitale Ditto Music ha rilevato con un sondaggio del 2023 che quasi il 60% degli artisti iscritti utilizza l’IA nei propri progetti, anche senza esserne del tutto consapevole.

Per gli smanettoni, esistono strumenti davvero potenti di composizione e sound design, ma, ahimé, bisogna sporcarsi le mani con del codice. Oltre alla creatività di sviluppatori come Mark Coniglio o David Ziccarelli per citare qualche nome, vale la pena segnalare strumenti come ChucK, parte del progetto CCRMA della Stanford University, perfettamente integrabile in Unity o Unreal (chi si occupa di Gaming conosce bene queste piattaforme) o in TouchDesigner (o combinare TouchDesigner e Unreal) Si può usare il machine learning di ChucK in applicazioni interattive. Naturalmente, si può aggiungere ChucK a Pure Data e Max/MSP, o usarlo con FAUST. Strumenti come ChucK sono definibili “interattori”, ovvero in grado di interagire in tempo reale con il musicista.

Una lista aggiornata, completa e curata delle numerose IA per la creazione musicale è disponibile su There’s an AI for That.

Artisti contemporanei e l’uso dell’IA

Non sorprenderà che artisti del calibro di Brian Eno abbiano a lungo sperimentato con la musica generativa (Eno ne ha effettivamente coniato il termine), come anche l’artista multimediale Alva Noto, o la famosissima artista virtuale giapponese Hatsune Miku, o il progetto digitale Miquela.

Degno di nota è “Emily Howell”, modello creato da David Cope ha creato nel 2009 l’album “From Darkness, Light” con un processo iterativo di feedback dagli ascoltatori, che giudicavano la qualità delle varie composizioni proposte dall’AI.

I primi esperimenti seriamente commerciali con l’AI non sono andati benissimo: il “rapper robot” FN Meka, partito in pompa magna, è stato abbandonato dalla Capitol Records perché usava pesanti stereotipi razziali nei propri brani.

Tra i primi esempi con maggiore rilevanza mediatica c’è la musicista e youtuber Taryn Southern, che ha utilizzato l’IA per comporre l’intero album “I AM AI”, utilizzando una combinazione di strumenti inclusi Watson Beat, Amper, AIVA e Google Magenta. In tutti i casi, il software ha composto la notazione e, quando è stato utilizzato Amper (che già non esiste più), l’IA ha anche prodotto la parte strumentale.

Sony ha addirittura tentato di riportare in vita i Beatles con il brano IA “Daddy’s Car” nel 2016. Francois Pachet ha pubblicato l’album pop generato da IA “Hello World” nel 2018, mentre il gruppo Dadabots ha lanciato una live di Youtube con del death metal generato dall’AI; questa performance è in onda 24/7 e va avanti tutt’ora senza sosta – ho ricontrollato mentre scrivo – dal 2019.

C’è poi chi ha deciso di usare la IA come membro della band. Uno splendido caso di collaborazione tra artista e IA è quello tra Holly Herndon, ricercatrice di Stanford, e la sua creazione Holly+, un’IA che canta e interagisce con la stessa voce dell’artista.

Nobody and The Computer unisce le capacità di un artista umano, Nobody, con quelle di un’IA, The Computer, per creare musica in bilico tra organico e artificiale. Il suo processo creativo è sempre ben documentato attraverso i notebook di Colab, è utile se si vuole imparare come approcciare alla composizione con l’AI.

L’artista Grimes, nota per le sue sperimentazioni sonore e visive, e ha utilizzato l’IA in vari aspetti della sua produzione musicale e artistica. CreateSafe, azienda co-fondata con Daouda Leonard, manager di Grimes, sviluppa strumenti e protocolli per gli artisti per automatizzare la creazione, distribuzione e marketing della proprietà intellettuale musicale.

La società londinese Bronze ha creato un’IA che permette agli artisti di reinterpretare i propri brani, è stata già utilizzata tra gli altri da Disclosure, Jay Paul e Arca. Inoltre, con la “rivoluzione NFT”, alcuni artisti hanno generato con lA migliaia di varianti uniche dei loro brani da vendere sul giovanissimo e discusso mercato NFT.

Diritto d’autore: preoccupazioni e prospettive

“Le regole aiutano l’accesso alla libertà e non viceversa. Viaggiamo sicuri in auto perché abbiamo creato il codice della strada.” afferma Jean Michel Jarre in una dichiarazione sul tema delle AI.

Il problema del diritto d’autore non è nuovo. In epoca recente ci sono stati dibattiti ad esempio nel RAP, dove è pratica comune declamare rime a tempo sopra basi di altri artisti, o spezzoni delle stesse messi in loop, oppure nei remix, che, come dice la parola stessa sono dei “mix rifatti”. La stessa Organizzazione Mondiale della Proprietà Intellettuale ne parla in un famoso articolo del 2015, nell’ epoca della cosiddetta “remix society”, come un caso controverso con soluzioni tutt’ altro che banali.

L’associazione Creative Commons aveva ben chiaro il problema e creò, nel 2001, diversi tipi di licenze note come licenze CC: un modo semplice e standardizzato per comunicare quali diritti sono riservati e a quali altri si rinuncia, a beneficio degli utilizzatori.

Facciamo qualche esempio delle recenti controversie: il brano di Alltta, Savage, che fa uso della voce del rapper Jay-Z emulata da una IA ha aperto nuovi dubbi su cosa sia il copyright musicale. Le canzoni saranno pure protette da copyright, ma il timbro della voce lo è?

All’inizio del 2023, un brano con Drake e The Weeknd è diventata virale su TikTok e poi su YouTube. Ma le versioni AI di entrambi gli artisti erano state usate senza il loro permesso.

La Recording Industry Association of America (RIAA) ha invitato il governo degli Stati Uniti a marchiare i siti web di clonazione vocale come pirateria online. “Il nostro settore abbraccia da tempo la tecnologia e l’innovazione, compresa l’intelligenza artificiale, ma molti dei recenti modelli di intelligenza artificiale generativa violano i diritti – effettuando un vero e proprio furto di identità invece che un aiuto alla creatività umana”, ha affermato la RIAA in una dichiarazione inviata ai giornalisti.

Nell’ordinamento italiano, il Garante della Privacy ha chiaro quale sia l’ambito dei dati personali, stabilendo che gli stessi comprendono “le informazioni che identificano o rendono identificabile, direttamente o indirettamente, una persona fisica […]”. Tra questi ci sono i cosiddetti “dati biometrici”, che includono – secondo il Garante – “quelli relativi a caratteristiche fisiche, fisiologiche o comportamentali di un individuo. Dato biometrico è, ad esempio, l’impronta digitale usata per sbloccare gli smartphone di ultima generazione, ma anche la conformazione fisica della mano, del volto, dell’iride o della retina, il timbro e la tonalità della voce”.

Alcuni ritengono che la musica IA sia meno creativa e genuina di quella umana, e la regolamentazione giuridica dell’intelligenza artificiale nel campo artistico dovrà probabilmente evolversi per affrontare queste sfide, bilanciando la protezione dei diritti di proprietà intellettuale con la promozione dell’innovazione e della creatività. La collaborazione tra giuristi, tecnologi, artisti e politici sarà cruciale per navigare in queste acque complesse e garantire che l’arte generata dall’IA arricchisca la cultura umana piuttosto che minacciarla. secondo Nilay Patel, direttore del sito The Verge, «questi casi sono come il lancio di una monetina. (…) Se il sistema legale di per sé non è prevedibile, il diritto d’autore è intrinsecamente imprevedibile».

Oltre al deep-fake, anche le accuse di plagio sono controverse e spesso le AI sono addestrate proprio per eludere la legge. Le preoccupazioni sull’impatto dell’AI contro la proprietà intellettuale, ha messo in guardia tutti: ad aprile 2024 la Artist Rights Alliance ha pubblicato una lettera aperta dove vengono espresse perplessità sull’uso di intelligenza artificiale e dataset con materiale sotto copyright, firmata da artisti come Pearl Jam, Nicki Minaj, Billie Eilish, Stevie Wonder, o Elvis Costello.

Le piattaforme sembra si stiano attrezzando. Quando abbiamo fatto qualche esperimento con Udio, usando prompt dove vengono citati degli artisti e delle canzoni, il software subito dichiara che sostituirà l’Artista. La voce, in effetti, viene modificata, ma il “feel” generale timbrico e compositivo è precisamente quello richiesto.

Serve un impegno per l’uso “responsabile” dell’intelligenza artificiale in collaborazione con gli enti legislatori per regolamentare i cosidetti “dataset”, che identifichino il materiale protetto da copyright. Google ha creato uno strumento di watermarking che contrassegna in maniera permanente il file chiamato SynthID, in grado di filigranare e rilevare contenuti generati sinteticamente, ad esempio.

La major Universal Music Group e il famoso produttore di strumenti musicali Roland si sono alleati per realizzare i “Principi per la creazione musicale con l’IA”, che stabiliscono una linea guida per l’uso responsabile dell’intelligenza artificiale nella musica. Dal sito: “Adottando questi principi, aziende e organizzazioni si impegnano a proteggere i contributi vitali della creatività umana e allo sviluppo e applicazione responsabili dell’intelligenza artificiale per la creazione musicale.”

A marzo 2024 lo stato del Tennessee ha emanato la prima legge negli Stati Uniti d’America che protegge i musicisti dall’uso non autorizzato della loro voce attraverso tecnologie di intelligenza artificiale, dai deepfake audio e dalla clonazione vocale, chiamato ELVIS Act.

L’Unione Europea ha già fatto un gran bel lavoro di regolamentazione con l’AI Act. Come il precedente Digital Services Act dell’UE, questo corpus di leggi diventerà probabilmente lo standard globale, o quantomeno un benchmark su cui altri legislatori faranno affidamento. L’UE conta 450 milioni di individui che vivono in democrazia e la garanzia alla libertà e alla privacy presente in EU è difficile da ignorare. Tra le altre cose, l’AI Act permetterà ai cittadini di conoscere quali dataset sono stati utilizzati per addestrare ogni intelligenza artificiale e quali limiti e vincoli sono imposti dalle aziende nelle proprie AI.

L’attuabilità sarà chiaramente complessa ma, come succede anche per il Digital Services Act, si presuppone che l’applicazione delle norme avverrà attraverso l’azione dei cittadini dal basso e la denuncia delle pratiche scorrette. Come anche per il GDPR, queste leggi permettono ad ogni cittadino di presentare reclami e richiedere azioni correttive. In Italia la lentezza della burocrazia non ha ancora permesso di individuare quale sarà l’Autorità che dovrà vigilare e ricevere le notifiche di controllo dell’AI Act. Vi terremo aggiornati.

Artisti e Promptisti

Nel mondo dell’arte digitale, emerge oggi una distinzione intrigante tra due figure: gli artisti e i promptisti. Gli artisti, tradizionalmente, sono coloro che creano opere d’arte utilizzando vari mezzi fisici o digitali, basandosi su tecniche apprese, talento personale e una profonda comprensione del linguaggio artistico, che sia visivo, musicale o testuale.

Dall’altra parte, abbiamo i promptisti, un ruolo nato dall’espansione dell’intelligenza artificiale e delle tecnologie generative nell’arte. I promptisti sono bravi nel comunicare con le IA generative, come DALL-E, per creare opere d’arte. La loro abilità non risiede tanto nella tradizionale esecuzione artistica, che sia manuale o puramente compositiva, ma nella capacità di formulare richieste (prompt) che guidano l’IA a produrre materiale che si avvicina alla visione creativa del promptista. Questo richiede una comprensione non solo dell’estetica, ma anche delle peculiarità e limiti delle piattaforme IA.

Mentre gli artisti mantengono un controllo diretto sul processo creativo, dall’inizio alla fine, i promptisti agiscono più come produttori, registi o curatori, guidando la tecnologia ad esprimere una visione creativa.

Rivoluzione o meno, impariamo a conviverci

L’intelligenza artificiale sta riconfigurando la produzione musicale, tanto quanto l’industria, il cinema, la scrittura e tanti altri ambiti offrendo nuovi strumenti e modi di comporre e produrre. Sebbene ancora agli albori, ha già prodotto risultati notevoli ed è destinata a un impatto sempre maggiore.

Come per il mondo Blockchain, quando l’hype scema ogni industria trova una sua stabilità e restano pochi unicorni e tante meteore/zombie. Poche aziende crescono esponenzialmente e moltissime altre sono destinate a sparire in breve tempo. Lo abbiamo visto anche nella musica e nelle arti.

Sebbene gli strumenti disponibili siano tanti e per tutti i gusti, le domande da porsi sono chiare: la musica è un mestiere oppure è un’arte? Nasce dallo studio o dal cuore? Malgrado non esista una risposta chiara, la chiave per la convivenza sarà trovare il giusto equilibrio tra innovazione tecnologica e creatività umana, abbracciando le opportunità dell’IA senza perdere l’essenza dell’espressione artistica.

Ecco con quattro brevi regole, non facili da applicare, per convivere con i nostri copiloti artistici:

With a little help from my friend – I modelli IA generativi sono degli stagisti, con tanta conoscenza ma nessuna esperienza del mondo reale. È importante fare le richieste corrette, controllare bene l’output e quando sbagliano la responsabilità è tua.

Everybody wants to rule the world – Sono sistemi mimetici, nel senso che riescono a far apparire un testo, una immagine, o una composizione musicale come una buona media degli altri lavori sullo stesso tema/stile. Se hai un tuo stile, fai in modo che segua te, non che ti imponga uno stile uguale a tanti altri.

Big Yellow Taxi – Cerca di comprendere eventuali Bias della IA in oggetto e analizza sempre l’output, che sia testuale, grafico, sonoro o altro. Non farti illudere.

Comfortably Numb: A volte le IA hanno delle allucinazioni, e questo nell’arte può anche essere positivo. Riconoscile, e se riesci usale a tuo vantaggio, diversamente dalle sostanze stupefacenti, queste non hanno nessuna controindicazione. E buone allucinazioni a tutti.

Sono davvero musicalmente intelligenti, queste IA?

Centocinquanta anni dopo la famosa lettera di Ada Lovelace che abbiamo citato in apertura, in una lettera al Computer Music Journal è stato chiesto se fosse sensato creare un “Test di Turing” per valutare l’intelligenza musicale delle macchine. In particolare, si voleva valutare la millantata intelligenza dei software M e Jam Factory. La proposta di Emile Tobenfeld, noto sviluppatore dell’epoca coinvolto anche in software generativi, consisteva nel fare una semplice domanda alla macchina: “Suonami un Blues in Mi bemolle, e uno, due, tre, quattro…”, a voce e magari prendendo il tempo dal gesto del polso. Per superare il test di Touring, un osservatore esterno – o meglio un ascoltatore – non dovrebbe notare alcuna differenza percepibile tra l’output di una IA e quello di musicista umano. Secondo Christopher Ariza, per valutare le intelligenza artificiale musicali sono perseguibili due test: un test musicale dove l’IA interagisce con un umano, e un test di output musicale dove non esiste interazione. In pratica, per valutare una intelligenza musicale deve essere valutato il processo di creazione musicale, che deve sembrare umano.

Un modo umano per “bypassare” le IA è stato quello di documentare la creazione artistica, come fanno ad esempio molti youtuber che mostrano in immagini il proprio processo creativo (che sia arte visiva o musica). Uno dei pionieri di questa modalità, (era il 2008) è stato il noto Jack Conte, attuale CEO di Patreon, con il progetto Pomplamoose. Oggi questa pratica viene chiamata techne, e per descriverla in termini informatici, è una specie di CAPTCHA per dimostrare che chi ha suonato e composto lo ha fatto veramente e non è un robot.

In conclusione, anche io mi sono fatto una mia idea sullo stato delle cose. Tutti gli strumenti musicali che ho in studio sono dannatamente stupidi e imprecisi, per non parlare del fatto che io li suono malissimo. In compenso mi danno grandi soddisfazioni e mi divertono parecchio, mentre l’intelligentissimo servizio Udio.com genera curiosi grattacapi, per non parlare della strana sensazione di artificiale. Il termine esatto potrebbe essere “Musica Surrogata”, i risultati sono stereotipi, cliché: il minimo comune denominatore. Tendo a pensare che l’uso più adeguato delle intelligenza artificiale per un vero creativo sia, appunto, usare queste macchine con oculata creatività.

Le intelligenze artificiali, per imitare un cervello un umano, utilizzano una certa approssimazione e un certo rumore di fondo per essere creative, ne abbiamo parlato all’inizio descrivendo il parametro della temperatura. Nel jazz, ad esempio, gli errori non sono solo accettati, ma incoraggiati come opportunità per l’esplorazione creativa. In altre parole, non esistono errori veri e propri, solo nuovi sentieri da esplorare. Per essere intelligenti, dobbiamo imparare a sbagliare.

Eccellente articolo?