È da un anno e mezzo che il mondo intero parla di AI generativa non stop.

Abbiamo cominciato la scorsa estate con Copilot, poi sono arrivati DALL·E 2 e Stable Diffusion, poi a novembre ChatGPT. E nel mezzo dozzine di altri modelli e sistemi di intelligenza artificiale che dozzine di altre aziende hanno sviluppato per competere con OpenAI, GitHub, Microsoft e così via: da Google a Meta ad Anthropic a Cohere e molti altri.

Ma qual è il ritorno sull’investimento di queste tecnologie?

Se non avete mai visto uno sviluppatore, anche un esperto, sorridere da solo di fronte al monitor quando Copilot gli risparmia due ore di lavoro, vi suggerisco di farlo prima possibile. Una cosa che non ho mai visto in ventitré anni di carriera nell’IT. Se invece avete assistito a questo piccolo miracolo, forse avrete intuito che l’AI generativa ha un impatto positivo sulla produttività aziendale. Ma nessuno ha ancora chiarito quanto è grande questo impatto. Vediamo se riusciamo a trovare dei dati per aiutarci.

il primo dato ce lo dà GitHub, la subsidiary di Microsoft che offre Copilot, un’estensione di Visual Studio Code che usa un modello di AI chiamato Codex, che è stato sviluppato da OpenAI ed è stato istruito su tutto il codice che gli esseri umani hanno pubblicato su GitHub negli ultimi quasi quindici anni a metà di febbraio.

GitHub ha rivelato che in media quasi metà del codice scritto da un programmatore, il 46%, è stato generato da Copilot.

Questa performance è costante, indipendentemente dal linguaggio usato dal programmatore. Se il programmatore però scrive codice in Java, Copilot suggerisce addirittura il 61% del codice.

Ora qui ci sono due problemi. Il primo problema è che questo dato viene da GitHub e quindi probabilmente è di parte. Il secondo problema è che questo dato non ci dice se la produttività dello sviluppatore è aumentata o no. È possibilissimo che Copilot abbia generato metà del codice, ma poi lo sviluppatore abbia perso il doppio del tempo che normalmente avrebbe dedicato al debugging per capire dove sono gli errori del codice suggerito da Copilot.

Ci viene in aiuto una ricerca accademica scritta dai ricercatori di Microsoft, pubblicata anche questa il mese scorso, The Impact of AI on Developer Productivity: Evidence from GitHub Copilot.

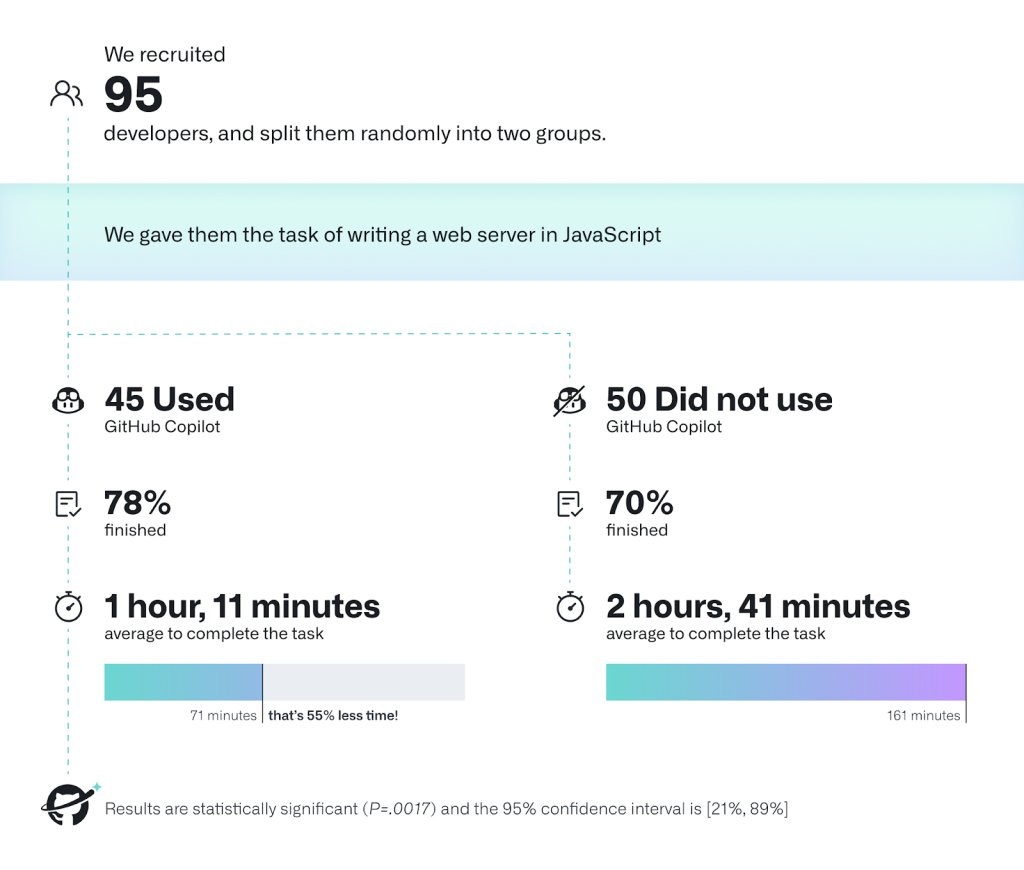

Questi i ricercatori hanno reclutato 95 programmatori su una piattaforma online per i liberi professionisti.

La maggior parte di questi programmatori ha una laurea quadriennale, una media di sei anni di esperienza come sviluppatore, e ha dichiarato di spendere nove ore al giorno scrivendo codice; quindi un gruppo di programmatori che non è esattamente alle prime armi.

I ricercatori hanno chiesto a questi programmatori di programmare un server web utilizzando il linguaggio JavaScript il più velocemente possibile, che è un compito molto comune che i programmatori di tutto il mondo eseguono regolarmente.

A questo punto i ricercatori di Microsoft hanno diviso i programmatori in due gruppi: un gruppo ha ricevuto accesso a Copilot e l’altro no.

Il gruppo che non ha ricevuto accesso a Copilot, però, è stato libero di navigare su internet e usare qualunque strumento online, incluso Google e vari forum online come Stack Overflow.

Il gruppo che ha ricevuto accesso a Copilot ha completato il lavoro molto più velocemente: il 55,8 % più velocemente, per essere precisi. Quindi abbiamo un secondo dato. Anche questo va considerato di parte che viene dai ricercatori di Microsoft e Microsoft ha investito cifre colossali in GitHub e OpenAI.

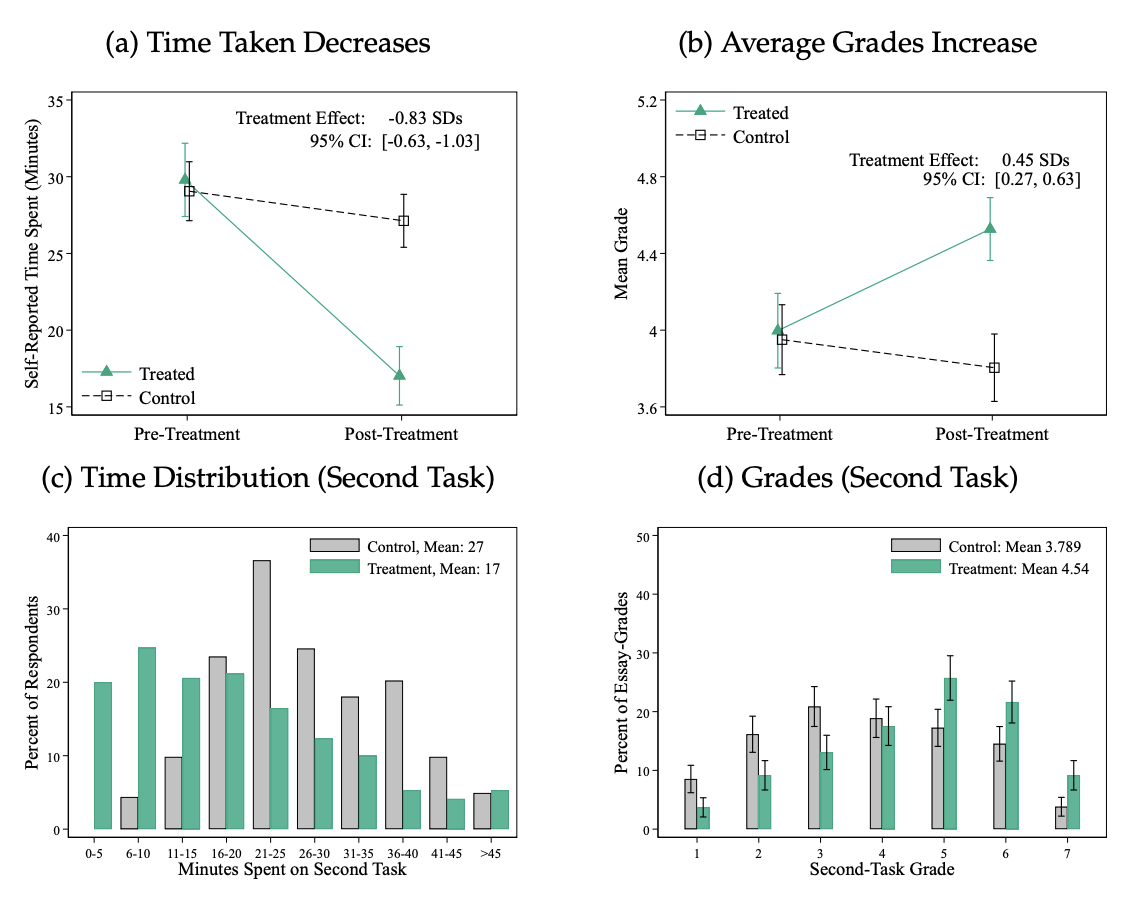

Però abbiamo un terzo dato interessante. Questo invece viene da ricercatori del Mit e non riguarda Copilot ma ChatGPT.

La loro ricerca – Experimental Evidence on the Productivity Effects of Generative Artificial Intelligence è stata pubblicata all’inizio di marzo, è ancora provvisoria, ma vale la pena dare un’occhiata. L’approccio della ricerca è lo stesso usato dai ricercatori Microsoft.

Sono stati selezionati 444 professionisti con un’educazione universitaria, sono stati divisi in due gruppi e uno di questi gruppi ha avuto accesso a ChatGPT. Questo gruppo di professionisti includeva professionisti nel settore del marketing, delle risorse umane, della gestione dei dati, della consulenza e manager aziendali.

A questo gruppo è stato chiesto di eseguire una serie di compiti da venti-trenta minuti ciascuno: scrivere un annuncio stampa, fare un rapporto, scrivere un’analisi, mandare una serie di e-mail.

La qualità di questi documenti e delle mail che sono state scritte è stata poi valutata da un altro gruppo di professionisti che fa lo stesso lavoro di quelli selezionati per l’esperimento.

Il gruppo che ha usato ChatGPT ha impiegato di media dieci minuti in meno per completare le richieste, il 37% del tempo.

Lo stesso gruppo ha anche ottenuto una valutazione superiore per la qualità del lavoro svolto a confronto con il gruppo che non ha usato ChatGPT.

La cosa più interessante, però, è che il gruppo che ha avuto accesso a ChatGPT ha riportato un aumento significativo della soddisfazione nell’eseguire il lavoro.

Tutto bellissimo e molto promettente, ma ricordatevi che ChatGPT e altri Large Language Model al momento ancora generano dati completamente inventati e li presentano all’utente con la più assoluta confidenza.

Se il professionista aziendale ci mette dieci minuti in meno per eseguire ogni compito della sua giornata, ma poi deve spendere un’ora in più per verificare la veridicità dei documenti generati, ecco che l’aumento di produttività viene immediatamente annullato.

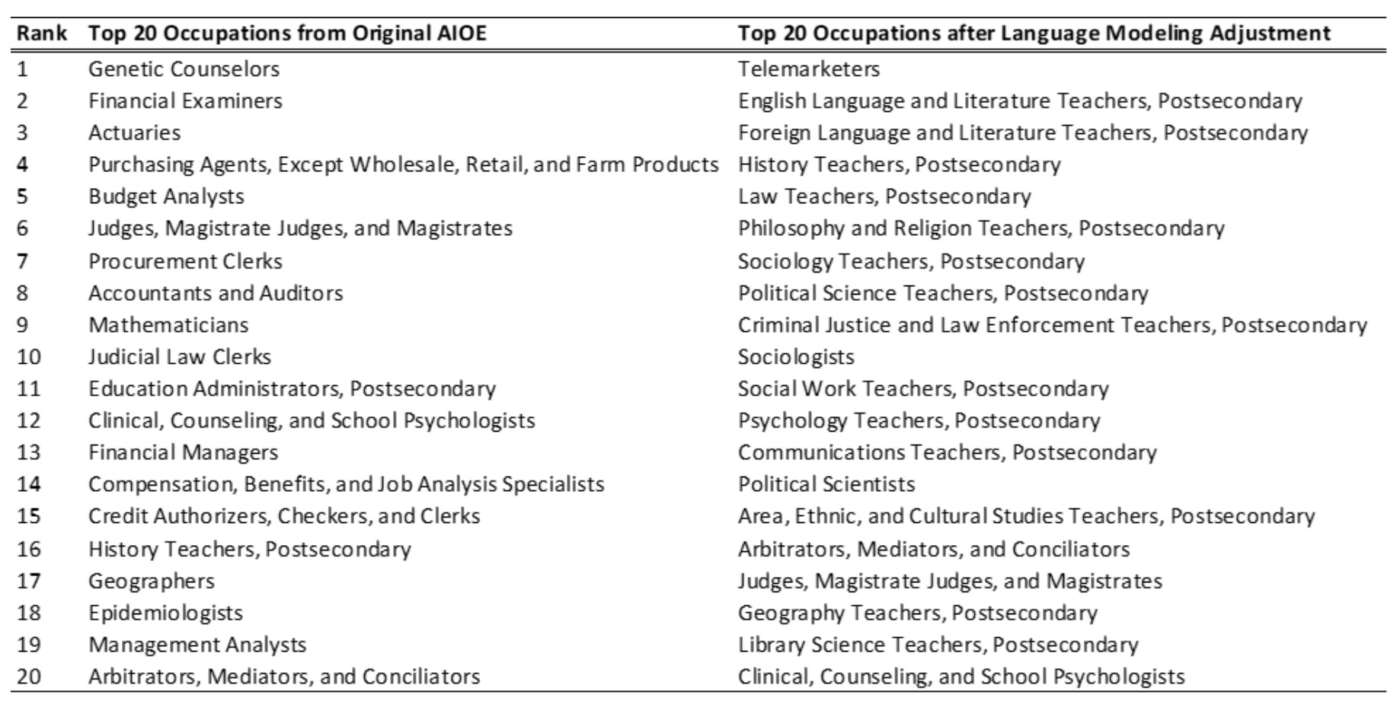

Finiamo con un’ultima ricerca pubblicata questa settimana dai ricercatori delle università di Princeton, Pennsylvania e New York, How will Language Modelers like ChatGPT Affect Occupations and Industries?

Questa ricerca non misura l’impatto sulla produttività aziendale, ma ci dice quali sono i lavori che più di tutti possono essere influenzati in termini di produttività dall’intelligenza artificiale.

Per spiegarvi questa ricerca, devo partire da un altro lavoro accademico pubblicato nel 2021: Occupational, industry, and geographic exposure to artificial intelligence: A novel dataset and its potential uses.

In quel lavoro, un gruppo completamente diverso di ricercatori ha sviluppato un metodo per misurare l’impatto delle AI su un dato tipo di lavoro, analizzando quali compiti quel lavoro implica e quali sono i progressi che l’AI ha fatto nell’eseguire questi compiti. Questa unità di misura si chiama AI Occupational Exposure.

Facciamo un esempio: ipotizziamo che il lavoro della segretaria d’ufficio sia inviare e-mail, fare il riassunto delle mail ricevute, fare una trascrizione di un testo dettato dal datore di lavoro, coordinare gli appuntamenti in agenda e così via.

Se negli anni l’AI diventa più capace in uno o più di questi compiti, l’AI aumenta l’impatto sul lavoro della segretaria del 30%, sto inventando, questo impatto non è necessariamente negativo. Può essere un aumento di produttività. Questa unità di misura, l’AI Occupational Exposure, è stato sviluppato prima dell’avvento dell’AI generativa che abbiamo menzionato oggi e quindi è tempo di ricalcolarlo. La ricerca che è stata pubblicata questa settimana fa proprio questo: ha ricalcolato questa misura tenendo in considerazione i progressi ottenuti con le AI generative.

Qual è il risultato? Il risultato è che al confronto con il 2021, la primissima occupazione che viene influenzata dall’AI generativa è il lavoro del telemarketer.

Seguono una dozzina di lavori come insegnanti specializzati in varie discipline, i sociologi, gli assistenti sociali, i mediatori e i giudici e infine gli psicologi. Ovviamente questo risultato potrebbe cambiare radicalmente a seconda di quali capacità introdurranno i modelli di AI generativa che stanno per arrivare.

Ok, ci fermiamo qui per questa settimana. Come al solito scrivetemi le vostre domande, le richieste e i suggerimenti per i prossimi episodi.

Guarda gli episodi precedenti

Alla prossima!