Ciao a tutti! Siamo arrivati all’episodio 26 di Le Voci dell’AI. Oggi ci sporchiamo le mani e andiamo a vedere cosa succede quando usiamo l’intelligenza artificiale come ingranaggio nel motore che chiamiamo automazione.

Ma non preoccupatevi, questo non è un episodio tecnico o per soli tecnici! Al contrario, spero che questo episodio apra gli occhi ai leader di industria che ci seguono per capire realmente le potenzialità dell’AI generativa e il suo impatto sul modo in cui lavoreremo. Non si può semplicemente scambiare quattro chiacchiere con ChatGPT o generare un’immagine con MidJourney. Bisogna guardare più in basso, giù, nelle parti più tecniche, dietro le interfacce utente. Lì in fondo è possibile manipolare questi modelli di AI generativa per generare testo, immagini audio e video su scala industriale con la pressione di un bottone. Ripeto, su scala industriale. Faccio vedere due esempi.

Il primo è come ho usato GTP 4 e un motore di automazione per pubblicare in maniera completamente automatica decine di news flash per la mia newsletter chiamata Synthetic Work.

Il secondo è come ho usato Stable Diffusion e un motore di automazione completamente diverso per generare e alterare in maniera completamente automatica migliaia di immagini che uso per vari scopi inclusi per le cover della newsletter.

Perché ci interessa? Perché se capiamo cosa si può fare con queste nuove tecnologie possiamo cominciare a immaginare nuove applicazioni industriali e a capire quali sono i limiti di queste applicazioni.

Prima di cominciare, devo ricordarvi che AI e automazione non sono la stessa cosa. La stampa di tutto il mondo insiste nel fondere insieme questi termini, ma c’è una differenza sostanziale e questa differenza è critica per capire perché l’automazione che avete oggi non è in grado di fare quello che state per vedere grazie all’aggiunta dell’AI.

Un motore di automazione semplicemente esegue una serie di step che sono stati predefiniti da qualcuno, esattamente come facciamo noi esseri umani quando seguiamo una ricetta di cucina alla lettera: per fare questa torta fa’ il passo A, poi B poi C e così via. Anche se non sappiamo assolutamente nulla di torte o siamo mediocri in cucina, seguendo la ricetta possiamo preparare la torta. I modelli di AI generativa invece, interpretano più o meno liberamente una richiesta che arriva dall’utente, come farebbe uno chef di fama internazionale che ha visto e assaggiato quasi tutte le torte nel mondo e a cui viene detto: “fai una torta”. Lo chef ha un’idea chiara di quali sono gli step per fare una torta, ma non ne segue nessuno alla lettera. Forte della sua conoscenza pluriennale, si ispira alle torte che ha visto e assaggiato in passato e fa come gli pare.

Questa è la differenza. In maniera incredibilmente imprecisa potremmo dire che l’AI prende delle decisioni basate sull’esperienza che viene dalla fase di training del modello, mentre l’automazione esegue un processo prestabilito senza decidere niente e senza il bisogno di alcuna esperienza.

In un’altra analogia, anche questa terribilmente imprecisa, potremmo dire che l’AI è il cervello di un sistema che decide un’operazione mentre l’automazione è il braccio che esegue l’operazione. In realtà l’AI generativa che abbiamo oggi non è in grado di ragionare. E quindi non prendete queste analogie alla lettera.

Okay, torniamo ai miei due esempi. Cominciamo con la pubblicazione automatica delle flash news. Alcuni di voi che hanno seguito questo appuntamento dall’inizio sanno che ogni settimana scrivo una newsletter in lingua inglese dedicata a come l’AI sta cambiando il mondo del lavoro e il modo in cui lavoriamo. Si chiama Synthetic Work.

In una delle due e-mail che mando ogni settimana, condivido con i miei lettori la ricerca e la sperimentazione che faccio con le nuove tecnologie e cosa stanno facendo le aziende di tutto il mondo con queste tecnologie. Ogni singola parte di Synthetic Work è scritta da un essere umano, però per dimostrare cosa si può fare con l’AI generativa quando è usata in combinazione con l’automazione, ho creato una sezione dedicata alle flash news, che è scritta interamente da GPT 4. Quando c’è una news che voglio pubblicare per i miei lettori, mando una bozza a un motore di automazione che si chiama Uncanny Automator, che è un plugin per WordPress.

Questo motore di automazione manda la mia bozza a GPT 4 con un prompt scritto da me, chiedendo di fare un sommario di quello che ho scritto, succinto e fedele all’originale abbastanza da entrare in un singolo paragrafo e di produrre un titolo sobrio e non acchiappa-link. Quando GPT 4 risponde con il sommario della mia bozza, il motore di automazione manda un’altra richiesta di nuovo a GPT 4, questa volta chiedendo all’AI di identificare il concetto più importante nella bozza e descriverlo in maniera dettagliata, come lo descriverebbe una persona a un pittore che deve dipingere quel concetto su una tela. Quando GPT 4 risponde con la descrizione del concetto, il motore di automazione la invia a DALL·E 2, il modello di OpenAI che genera immagini con un altro prompt scritto da me, questa volta chiedendo di generare un’immagine basata su quella descrizione. Infine, il motore di automazione mette tutto insieme: il titolo sobrio, il sommario della mia bozza e l’immagine del concetto più importante e pubblica la flash news che intendevo pubblicare.

Non c’è assolutamente niente che devo fare, eccetto fornire la bozza all’inizio del processo.

Questo processo, realizzato con strumenti estremamente economici e facili da utilizzare per qualunque azienda permette la pubblicazione su scala industriale di materiale di qualunque tipo e può essere personalizzato per rispondere alle esigenze più disparate. Basta cambiare il prompt per GPT 4. Per esempio, il mio processo usa il motore di automazione per mandare una quarta richiesta a GPT 4.0 di cui non vi ho ancora parlato. Attraverso un altro prompt chiedo a GPT 4 di mettersi nei panni di un lettore che non ha alcuna esperienza con i termini citati nella mia bozza originale e quindi di spiegare quelli più complicati con un elenco puntato che accompagna ogni flash news. Questo approccio ha infinite applicazioni e un impatto non trascurabile sul mondo del lavoro, per esempio in termini di occupazione.

Pensate a cosa si può fare con questo processo per i team di marketing per il mondo, dell’editoria, per casi d’uso particolari, come emergenze sanitarie, ambientali e così via.

Vediamo il secondo esempio: la generazione e alterazione di immagini su scala industriale.

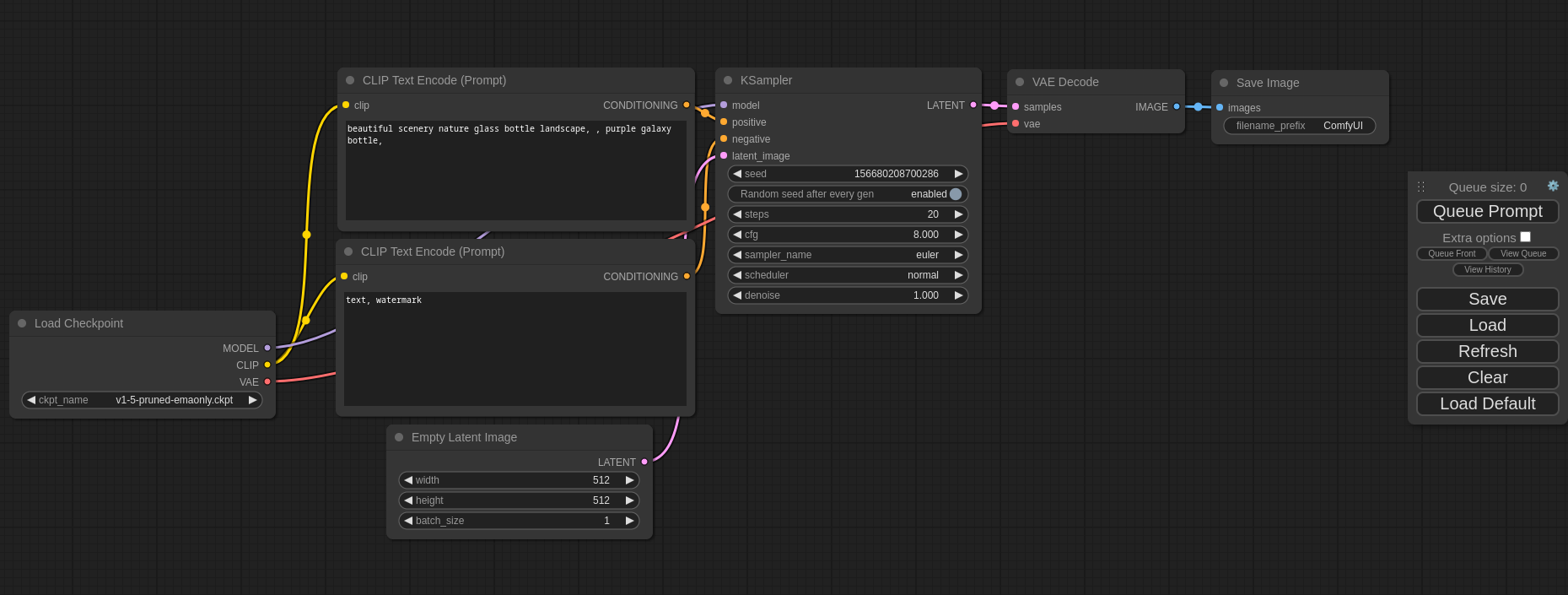

In questo caso il motore di automazione che uso si chiama ComfyUI, un sistema di nodi estremamente complicato da usare e manutenere, ma simile nell’approccio a sistemi di nodi che si trovano in software di animazione, computer grafica, manipolazione 3D, musica procedurale e così via.

Qui ho creato un processo di animazione relativamente semplice che, come primo passo, genera immagini con il modello di AI generativa chiamato Stable Diffusion XL. Una volta che un’immagine è stata generata, viene automaticamente passata in un’altra sezione del workflow dove un modello di AI diverso identifica tutti i visi umani nell’immagine appena generata. Per ognuna delle facce più piccole nell’immagine che di solito sono povere di dettagli e mal formate, il processo automaticamente allarga la faccia. crea una versione in alta risoluzione, mantenendo la direzione della faccia, il colore della pelle e così via.

Una volta che tutte le facce sono state rigenerate in alta risoluzione, il processo le incolla sopra le facce originali nella foto originale, fondendo insieme le immagini in maniera non percettibile. Infine, il processo prende l’immagine così modificata e genera una versione ad altissima risoluzione pronta per la stampa su carta. Ora, questo processo che ho creato può essere modificato per riconoscere e rimpiazzare qualunque oggetto nell’immagine, non solo facce umane. Per esempio, potrei usare questo processo per riconoscere la t-shirt di una fotomodella e rimpiazzarla con una t-shirt di un colore diverso o con un bikini o con un cappotto. Il processo usa una serie di modelli che rigenerano la porzione dell’immagine da modificare tenendo conto delle dimensioni, posizione nello spazio e postura della fotomodella, di fatto disegnando il bikini o il cappotto sul corpo di quella fotomodella. Pensate alle applicazioni per l’e-commerce nell’industria della moda, della cosmetica o dell’arredamento o al mondo dell’architettura. Anche qui ci sono infinite possibilità; visto che ci siete però pensate anche all’impatto sull’occupazione delle fotomodelle dei fotografi, dei creativi e di tutte le altre categorie professionali che ogni giorno lavorano per realizzare manualmente quello che ci prepariamo ad automatizzare su scala industriale con le tecnologie che abbiamo menzionato oggi.

Quello che conta non sono gli strumenti o come funzionano nello specifico. Quello che conta è che questi strumenti sono qui oggi e possono essere usati per ottenere immagini, testo e presto anche musica e video di qualità altissima e questo cambierà un sacco di cose per moltissime persone. Ci fermiamo qui per questa settimana. Come sempre, scrivetemi all’indirizzo di posta elettronica che trovate qui sotto con i vostri commenti, le domande e i suggerimenti per gli argomenti da trattare nei prossimi episodi.

Ciao!