Il cloud ospita oggi migliaia di servizi dai quali spesso dipendiamo per le nostre attività giornaliere e dietro questi servizi c’è una complessa infrastruttura informatica che sfrutta la capacità di calcolo di migliaia di server ospitati all’interno di data center.

Per quanto composti di componenti specializzati e ad alte prestazioni, ognuno dei server in un data center non è molto diverso dai nostri PC: all’interno del suo case, un server ospita CPU, memoria e periferiche.

Come diretta conseguenza di questa organizzazione fisica, il server rappresenta l’unità monolitica di allocazione delle risorse: benché più processi possano condividere le risorse di un server, un singolo processo non può mai utilizzare risorse provenienti da più di un server.

Questo causa un importante sottoutilizzo delle risorse quando le applicazioni non sono in grado di usarle in modo efficiente perché, ad esempio, le consumano in maniera asimmetrica, tenendo occupate tutte le CPU di un server, ma lasciando inutilizzata gran parte della sua memoria.

Nei Laboratori di IBM Research – Ireland, stiamo lavorando ad un prototipo che implementa un nuovo paradigma architetturale per i data center del futuro.

Alle fondamenta di questa architettura c’è l’idea di rompere le barriere fisiche del server, disaggregagando i suoi componenti costitutivi con l’obiettivo di aumentare drasticamente l’utilizzazione delle risorse e di conseguenza l’efficienza energetica complessiva dei data center.

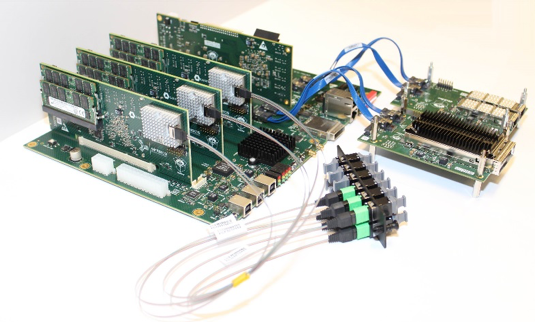

Il nostro approccio rivoluziona il modo in cui i server sono costruiti, disaggregando CPU e memoria in unità fisiche separate che possono essere combinate all’occorrenza.

All’arrivo di una nuova applicazione, un software di controllo specializzato connette CPU e memoria tramite una rete ottica a bassa latenza, creando “al volo” una piattaforma che soddisfi esattamente le sue richieste di risorse.

I vantaggi di questa tecnologia sono molteplici. A parità di carico applicativo, qualsiasi risorsa inutilizzata può essere spenta, con evidenti risparmi energetici; le applicazioni “memory-centric”, ossia applicazioni che richiedono grandi quantità di memoria, non sono più limitate dalla quantità di memoria disponibile su di un singolo server; i gestori dei data center possono gestire indipendentemente i cicli di aggiornamento di CPU e memoria, ottenendo maggiore flessibilità e costi ridotti.

Abbiamo costruito un primo prototipo del sistema ed i primi risultati sperimentali sono estremamente incoraggianti. Stimiamo, infatti, che le architetture disaggregate contribuiranno a ridurre di circa quattro volte l’energia che oggi è spesa per alimentare componenti inutilizzati.

Stiamo continuando a migliorare la nostra tecnologia con l’ambizione di aprire la strada all’adozione effettiva del data center disaggregato che permetta di raggiungere nuovi livelli di efficienza, con la promessa di ridurre drasticamente l’impatto energetico.

Questo lavoro è parte di un progetto finanziato dalla UE, dReDBox. Il progetto è coordinato da IBM Research – Ireland e comprende altri 10 partner accademici ed industriali.