Mistral AI ha rilasciato il suo nuovo assistente conversazionale, le Chat, e Mistral Large, il suo modello linguistico più recente e avanzato.

Per quanto riguarda le Chat, l’azienda lo descrive come una prima dimostrazione di ciò che si può costruire con i modelli Mistral e di ciò che si può implementare nel proprio ambiente aziendale.

Mistral Large è invece il modello flagship dell’azienda, con capacità di ragionamento di alto livello. È disponibile attraverso la piattaforma dell’azienda e anche su Azure.

Un assistente conversazionale multilingue

Le Chat – spiega il team – è un punto di ingresso conversazionale per interagire con i vari modelli di Mistral AI, che offre un modo pedagogico e divertente per esplorare la tecnologia dell’azienda.

Le Chat può utilizzare Mistral Large o Mistral Small, oppure un modello prototipo chiamato Mistral Next, progettato per essere breve e conciso. Il team sta lavorando per rendere i modelli il più possibile utili e poco opinionated, anche se molto resta da migliorare. Grazie a un meccanismo di moderazione regolabile a livello di sistema, le Chat avverte l’utente in modo non invasivo quando sta spingendo la conversazione in direzioni in cui l’assistente potrebbe produrre contenuti sensibili o controversi (è possibile consultare i Termini di servizio per saperne di più sull’approccio alla moderazione della società sviluppatrice).

Le Chat può utilizzare Mistral Large o Mistral Small, oppure un modello prototipo chiamato Mistral Next, progettato per essere breve e conciso. Il team sta lavorando per rendere i modelli il più possibile utili e poco opinionated, anche se molto resta da migliorare. Grazie a un meccanismo di moderazione regolabile a livello di sistema, le Chat avverte l’utente in modo non invasivo quando sta spingendo la conversazione in direzioni in cui l’assistente potrebbe produrre contenuti sensibili o controversi (è possibile consultare i Termini di servizio per saperne di più sull’approccio alla moderazione della società sviluppatrice).

Per le aziende, Mistral AI sta lanciando le Chat Enterprise, progettato per potenziare la produttività del proprio team con capacità di self-deployment e meccanismi di moderazione a grana fine.

L’assistente Le Chat è ora in fase di beta access, e l’azienda invita gli utenti che vogliono diventare early adopter a inviare il proprio feedback. È possibile registrarsi per accedere a le Chat come utente beta e informare l’azienda su eventuali comportamenti strani o su come l’assistente potrebbe essere migliorato. Al momento le Chat non può accedere a Internet per partecipare alle discussioni, quindi potrebbe essere impreciso o rispondere con informazioni non aggiornate.

Mistral Large, il nuovo modello AI di punta

Per quel che riguarda Mistral Large, è il nuovo modello di generazione di testi all’avanguardia dell’azienda. Secondo il team, raggiunge capacità di ragionamento di alto livello e può essere utilizzato per complesse attività di ragionamento multilingue, tra cui la comprensione e la trasformazione del testo e la generazione di codice.

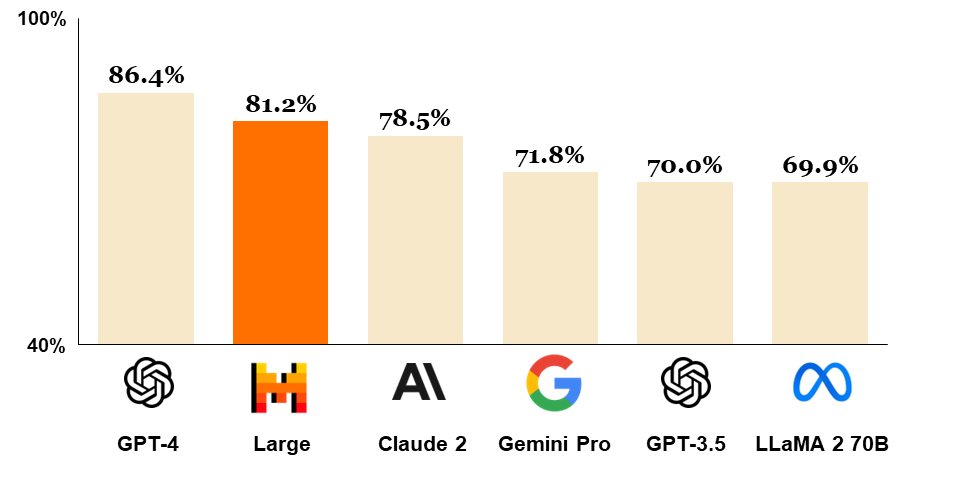

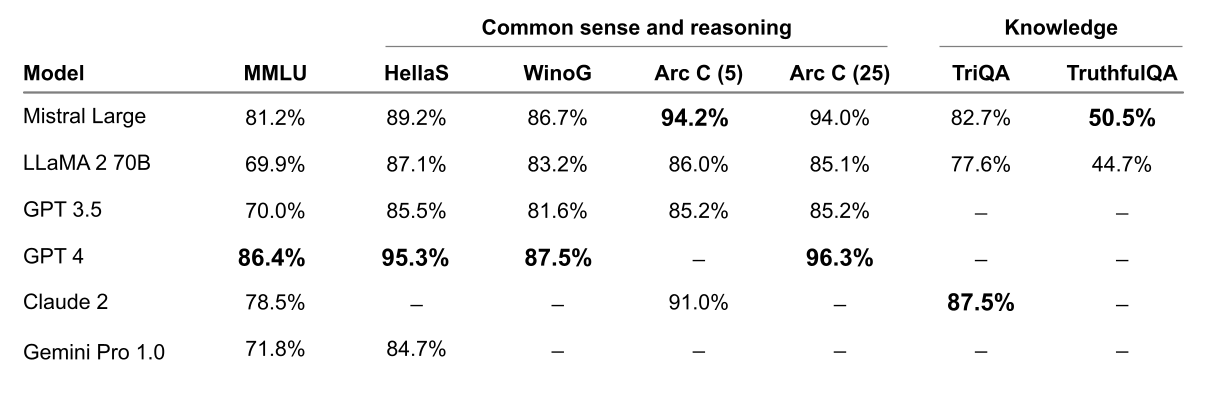

Mistral Large – afferma l’azienda – ottiene ottimi risultati nei benchmark più diffusi, risultando il secondo modello al mondo generalmente disponibile tramite API (dopo GPT-4).

Mistral Large – afferma l’azienda – ottiene ottimi risultati nei benchmark più diffusi, risultando il secondo modello al mondo generalmente disponibile tramite API (dopo GPT-4).

Mistral Large è dotato di nuove funzionalità e punti di forza:

- Parla nativamente inglese, francese, spagnolo, tedesco e italiano, con una comprensione approfondita della grammatica e del contesto culturale.

- La sua finestra contestuale da 32K token consente di richiamare con precisione le informazioni da documenti di grandi dimensioni.

- La sua precisione nel seguire le istruzioni permette agli sviluppatori di progettare le loro policy di moderazione: il team della società sviluppatrice lo ha usato per impostare la moderazione a livello di sistema di le Chat.

- È in grado di richiamare funzioni in modo nativo. Questo, insieme alla modalità di output vincolata, implementata su la Plateforme, consente lo sviluppo di applicazioni e la modernizzazione dello stack tecnologico su scala.

La missione di Mistral è rendere l’AI di frontiera onnipresente, ed è per questo che l’azienda ha annunciato che sta portando i suoi modelli aperti e commerciali su Azure.

La missione di Mistral è rendere l’AI di frontiera onnipresente, ed è per questo che l’azienda ha annunciato che sta portando i suoi modelli aperti e commerciali su Azure.

I modelli di Mistral AI sono ora disponibili attraverso:

- La Plateforme: hosted in modo sicuro sull’infrastruttura di Mistral in Europa, questo punto di accesso consente agli sviluppatori di creare applicazioni e servizi attraverso la gamma completa di modelli dell’azienda.

- Azure: Mistral Large è disponibile attraverso Azure AI Studio e Azure Machine Learning, con un’esperienza d’uso fluida come le API dell’azienda. I clienti beta lo hanno utilizzato con notevole successo, sottolinea la società sviluppatrice.

- Self-deployment: i modelli possono essere distribuiti sul proprio ambiente per i casi d’uso più sensibili con accesso ai pesi dei modelli; è possibile leggere le storie di successo su questo tipo di distribuzione e contattare il team dell’azienda per ulteriori dettagli.

Oltre a Mistral Large, l’azienda sta rilasciando anche un nuovo modello ottimizzato, Mistral Small, ottimizzato per latenza e costi. Mistral Small supera Mixtral 8x7B e ha una latenza inferiore, il che lo rende una raffinata soluzione intermedia tra l’offerta open-weight e il modello di punta.

Mistral Small beneficia della stessa innovazione di Mistral Large per quanto riguarda l’abilitazione RAG e la chiamata di funzione.

Mistral AI sta inoltre semplificando la sua offerta di endpoint per offrire quanto segue:

- Endpoint Open-weight a prezzi competitivi. Si tratta di open-mistral-7B e open-mixtral-8x7b.

- Nuovi endpoint di modello ottimizzato, mistral-small-2402 e mistral-large-2402. Viwene mantenuto mistral-medium, che non è stato aggiornato.

I benchmark forniscono una visione completa dei compromessi tra prestazioni e costi.

Oltre alla nuova offerta in fatto di modelli, l’azienda sta permettendo all’organizzazione di gestire i prezzi in più valute e ha aggiornato i livelli di servizio su la Plateforme. Ha anche fatto molti progressi nella riduzione della latenza di tutti gli endpoint.