In un inizio d’anno d’intensa attività, a breve distanza da Stable Code 3B, Stability AI ha presentato il suo secondo modello del 2024, e primo modello linguistico dell’azienda della nuova serie Stable LM 2.

Stable LM 2 1.6B, spiega Stability AI, è un modello le cui dimensioni compatte e la cui velocità possono ridurre le barriere hardware, consentendo a un maggior numero di sviluppatori di partecipare all’ecosistema dell’AI generativa.

L’azienda ha presentato sia il base model da 1,6 miliardi di parametri sia una versione instruction-tuned. Il modello di base è stato addestrato su circa 2.000 miliardi di token per due epoch, incorporando dati multilingue in inglese, spagnolo, tedesco, italiano, francese, portoghese e olandese.

Il team ha sfruttato i recenti progressi algoritmici nella modellazione linguistica per raggiungere un equilibrio favorevole tra velocità e prestazioni, consentendo una rapida sperimentazione e iterazione con risorse moderate.

Con questa release – sottolinea Stability AI – saranno disponibili anche i dati, in modo che la community open possa riprodurre modelli dalle prestazioni simili. Inoltre, per la prima volta, l’azienda rilascerà il pre-training checkpoint finale prima del cooldown, compresi gli stati dell’ottimizzatore, per aiutare gli sviluppatori a continuare senza problemi il pre-training e il fine-tuning con i loro dati, dato che su alcuni modelli pre-addestrati di recente potrebbe essere più difficile fare il fine-tuning a causa di ottimizzazioni in fase avanzata.

Stability AI ha anche annunciato che nei prossimi giorni condividerà una relazione tecnica completa che esplora e descrive il mix di dati e la procedura di addestramento che il team ha seguito.

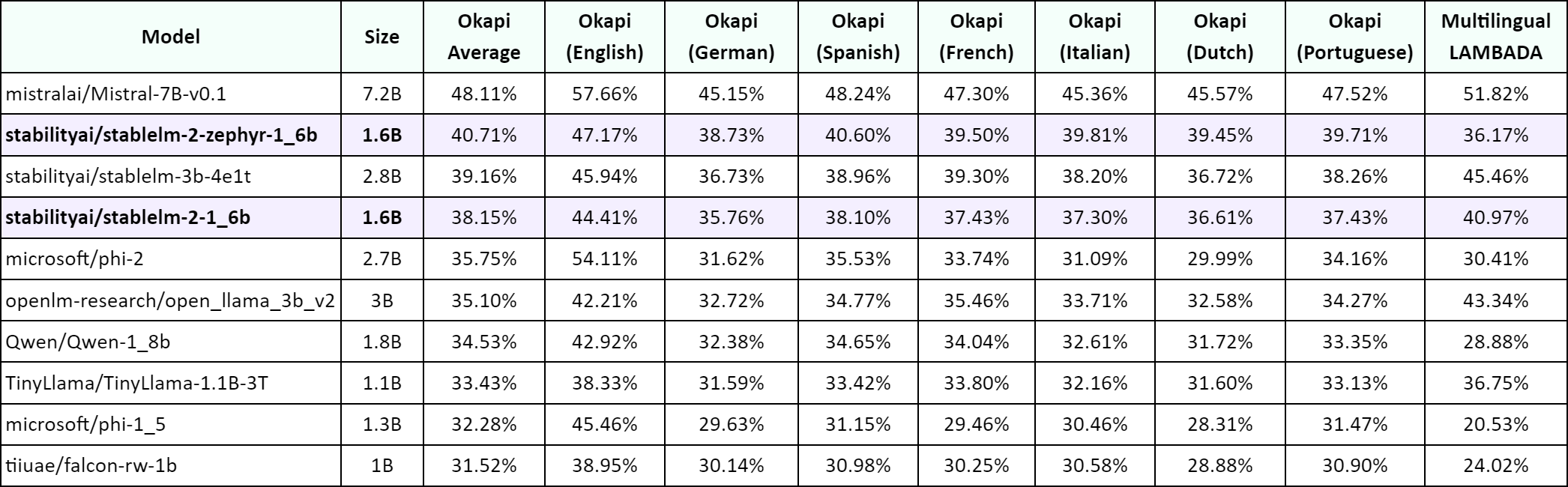

Per quanto riguarda la performance del modello, il team ha confrontato Stable LM 2 1.6B con altri popolari modelli linguistici di piccole dimensioni come Phi-1.5 (1.3B) e Phi-2 (2.7B) di Microsoft, TinyLlama 1.1B o Falcon 1B. Il modello di Stability AI, secondo il team, supera i modelli inferiori a 2B nella maggior parte dei task, e anche alcuni più grandi, in alcune circostanze. L’azienda ha pubblicato i risultati dei benchmark sul proprio blog.

Per quanto riguarda la performance del modello, il team ha confrontato Stable LM 2 1.6B con altri popolari modelli linguistici di piccole dimensioni come Phi-1.5 (1.3B) e Phi-2 (2.7B) di Microsoft, TinyLlama 1.1B o Falcon 1B. Il modello di Stability AI, secondo il team, supera i modelli inferiori a 2B nella maggior parte dei task, e anche alcuni più grandi, in alcune circostanze. L’azienda ha pubblicato i risultati dei benchmark sul proprio blog.

Nel rilasciare quello che il team descrive come uno dei più potenti modelli linguistici di piccole dimensioni, e fornendo una completa trasparenza sui suoi dettagli di addestramento, Stability AI intende mettere gli sviluppatori e i creatori di modelli in condizione di sperimentare e iterare rapidamente.

L’azienda sottolinea altresì che, a causa della natura dei modelli linguistici piccoli e a bassa capacità, Stable LM 2 1.6B può presentare problemi comuni come un alto tasso di allucinazione o un potenziale linguaggio tossico. Per questo Stability AI chiede alla community di tenerlo presente quando sviluppa le proprie applicazioni, e di adottare misure appropriate per garantire uno sviluppo responsabile.

Stable LM 2 1.6B, il primo di una serie di modelli Stable LM, è un modello per uso commerciale e non commerciale, e fa parte della Stability AI Membership, che prevede tre livelli distinti, per garantire che chiunque, dai privati alle aziende, possa beneficiare di questa tecnologia.