Stability AI – lo specialista dell’AI generativa a cui si deve, tra le altre cose, la famiglia di modelli Stable Diffusion – ha annunciato la sua prima release di Large Language Model del 2024: Stable Code 3B.

Questo nuovo LLM, spiega il team, è un follow-up di Stable Code Alpha 3B, rilasciato in precedenza, e la prima major release di Stable Code, che offre un nuovo modello all’avanguardia progettato per il completamento del codice con molteplici funzionalità aggiuntive.

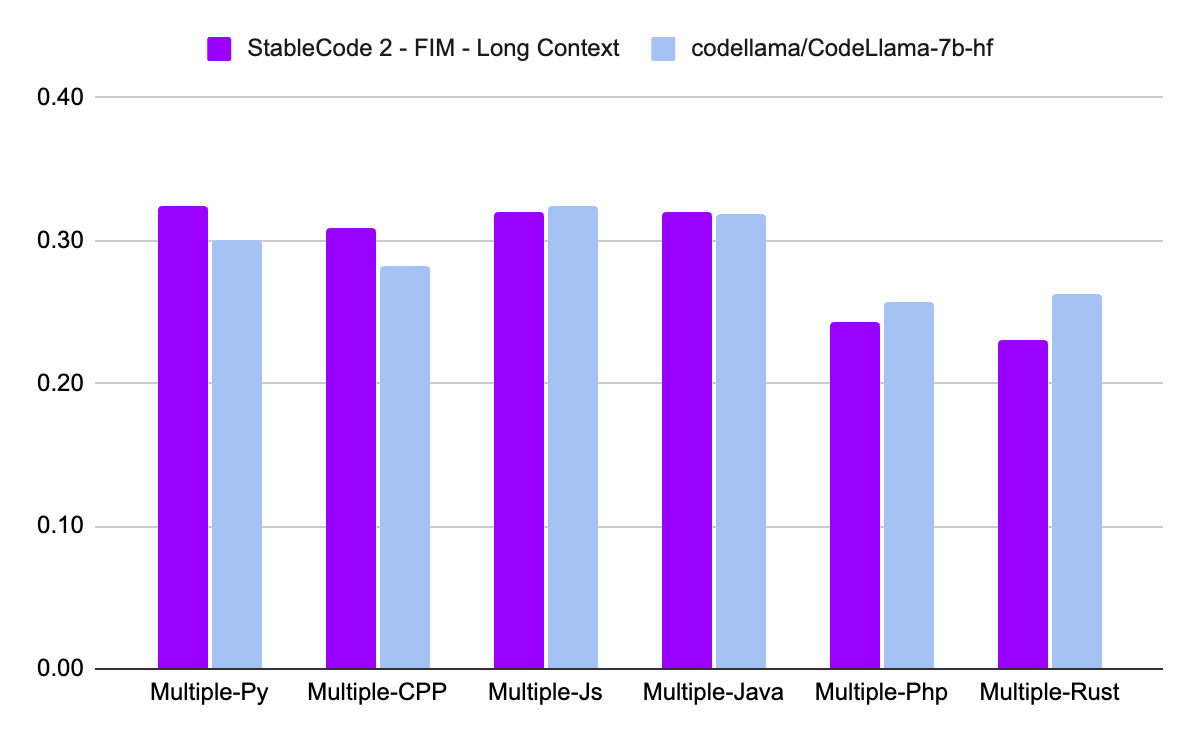

Rispetto a CodeLLaMA 7b, afferma Stability AI, Stable Code 3B è più piccolo del 60% e offre prestazioni di alto livello simili in tutti i linguaggi di programmazione. Basato sul modello foundational preesistente Stable LM 3B di Stability AI, addestrato su 4 trilioni di token di dati di linguaggio naturale, Stable Code è stato ulteriormente addestrato su dati specifici dell’ingegneria del software, compreso il codice.

Le dimensioni compatte del modello consentono di eseguirlo in modo privato all’edge in tempo reale sui laptop moderni, anche quelli che non dispongono di una GPU dedicata, sottolinea il team.

Stable Code 3B offre un maggior numero di funzionalità e prestazioni significativamente migliori in più linguaggi, con vantaggi aggiuntivi quali il supporto delle funzionalità Fill in the Middle (FIM) e l’ampliamento delle dimensioni del contesto. Stable Code di base è addestrato su sequenze fino a 16.384 token, ma segue un approccio simile a quello di CodeLlama con l’implementazione dei Rotary Embeddings, consentendo opzionalmente di modificare la base fino a 1.000.000, espandendo ulteriormente la lunghezza del contesto del modello fino a 100k token.

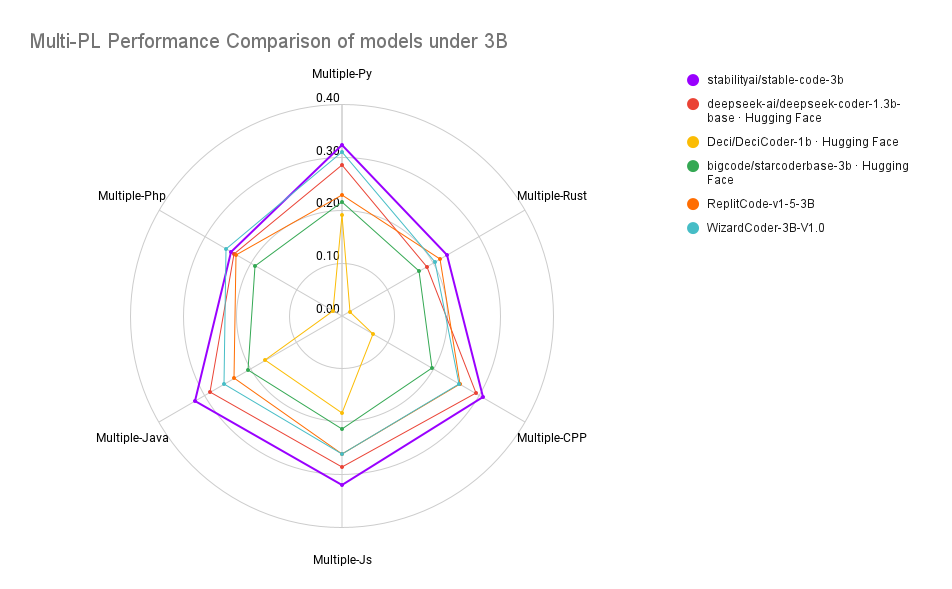

Stable Code è stato addestrato su 18 linguaggi di programmazione (selezionati in base al sondaggio per gli sviluppatori di StackOverflow del 2023) e secondo il team ha dimostrato prestazioni all’avanguardia (rispetto a modelli di dimensioni simili) sulle metriche MultiPL-E in tutti i linguaggi di programmazione testati.

La pipeline di training di Stability AI, spiega l’azienda, consiste in un processo a più fasi simile a quello di Codellama. Inizia con un LM pre-addestrato su dati in linguaggio naturale, in questo caso StableLM-3B-4e1t, seguito da un fine-tuning non supervisionato su diversi dataset di codice e correlati ad esso, tra cui CommitPack, GitHub Issues, StarCoder e altri dataset matematici. Nella seconda fase, viene ulteriormente perfezionato il modello con sequenze più lunghe di 16.384 token con la modifica di base suggerita in CodeLLama. Il nuovo modello stable-code supporta anche Flash Attention 2 ed è disponibile per l’uso.

Dal punto di vista dell’offerta commerciale, questo modello è incluso nella nuova Stability AI Membership, che include una suite di Core Model dell’azienda, tra cui SDXL Turbo e Stable Video Diffusion.