L’intelligenza artificiale generativa e i LLM sono di gran lunga le novità più popolari nel settore IT. Intel è da sempre fra le più importanti realtà al mondo nello sviluppo di CPU: quali sono le prospettive tecnologiche? Lo abbiamo chiesto a Stephan Gillich, EMEA Director of Artificial Intelligence and Technical Computing, Intel

Molte aziende stanno avvertendo l’impulso dell’intelligenza artificiale, forse più precisamente l’impulso dell’AI generativa (GenAI), quindi si stanno affannando per definire un loro approccio strategico all’intelligenza artificiale e a come saranno in grado di proteggere le risorse hardware per implementare i loro piani. Una delle (errate) percezioni del settore riguardo alla GenAI è che sia necessaria una GPU per eseguire l’intelligenza artificiale quindi, nelle attuali condizioni di mercato, gli utenti potrebbero attendere anche mesi per ottenere GPU che potrebbero sottoutilizzare o addirittura non utilizzare per nulla.

L’obiettivo di Intel è portare l’intelligenza artificiale ovunque offrendo un’ampia possibilità di scelta: adottiamo un approccio end-to-end per l’intelligenza artificiale, consentendo ai nostri clienti di scegliere lo strumento, il software e l’hardware giusti per il lavoro di ognuno in ogni punto lungo la pipeline dell’intelligenza artificiale. Siamo convinti che abbia sempre più senso partire dalle CPU già presenti in azienda per vedere se soddisfano le esigenze di gestione dei carichi AI. Nei data center, i processori scalabili Intel Xeon, in particolare quelli dell’attuale quarta generazione, sono ottimizzati per l’intero flusso di lavoro dell’AI, dall’acquisizione dei dati alla distribuzione, in modo da poter intraprendere un percorso diretto utilizzando l’intelligenza artificiale.

Quando si tratta di carichi di lavoro AI intensivi, in particolare training e inferenza di grandi modelli di GenAI, grazie alle sue elevate prestazioni e al favorevole rapporto prezzo/prestazioni, Intel Gaudi2 è una valida alternativa alle GPU più comuni. Quando l’attività richiede di accelerare carichi di lavoro altamente paralleli tra HPC, ad esempio la simulazione numerica, e attività AI/DL impegnative, la GPU Intel Datacenter Max è la più adatta ad accelerare i carichi di lavoro HPC nonché AI/DL più impegnativi. Questo è particolarmente rilevante in quanto molti sviluppatori stanno introducendo la simulazione aumentata/accelerata con intelligenza artificiale.

Con Gaudi2 AI accelerator, Intel sfida Nvidia e le sue GPU H100. La strada verso la realizzazione di unità di calcolo fortemente orientate all’intelligenza artificiale si farà sempre più affollata?

Se si esaminano gli ultimi risultati del benchmark MLPerf Training 3.1 di novembre, Intel Gaudi2 è la più valida alternativa a H100 per la formazione di LLM, una di sole tre soluzioni basate su semiconduttori utilizzate per il training GPT-3 sul benchmark MLPerf. Offre un vantaggio in termini di rapporto prezzo-prestazioni rispetto ai sistemi basati su H100 per LLM ecc. grazie a un costo del server significativamente inferiore. Inoltre, se l’hardware è importante, è necessario considerare anche lo stack SW: Intel fornisce un portafoglio di software end-to-end per offrire prestazioni e produttività senza pari nei flussi di lavoro AI.

Consumi energetici e dissipazione del calore sono due fra i principali ostacoli che le organizzazioni devono affrontare quando si parla di supercalcolo. Questo può essere un freno alla diffusione su larga scala di tecnologie come l’AI generativa?

Se con supercalcolo intendiamo l’HPC, Intel ha una lunga storia nella fornitura di soluzioni HW e SW. L’efficienza energetica è sempre stata uno dei nostri obiettivi chiave in questo ambitoa maggior ragione vediamo questo problema nell’intelligenza artificiale oggi, poiché con GenAI, l’utilizzo dell’intelligenza artificiale diventa mainstream con crescite in tipologia volume molto più rapide rispetto alle tradizionali aree di supercalcolo. Quindi sì, il consumo energetico e la sostenibilità sono considerazioni molto importanti al crescere della pervasività delle tecnologie AI.

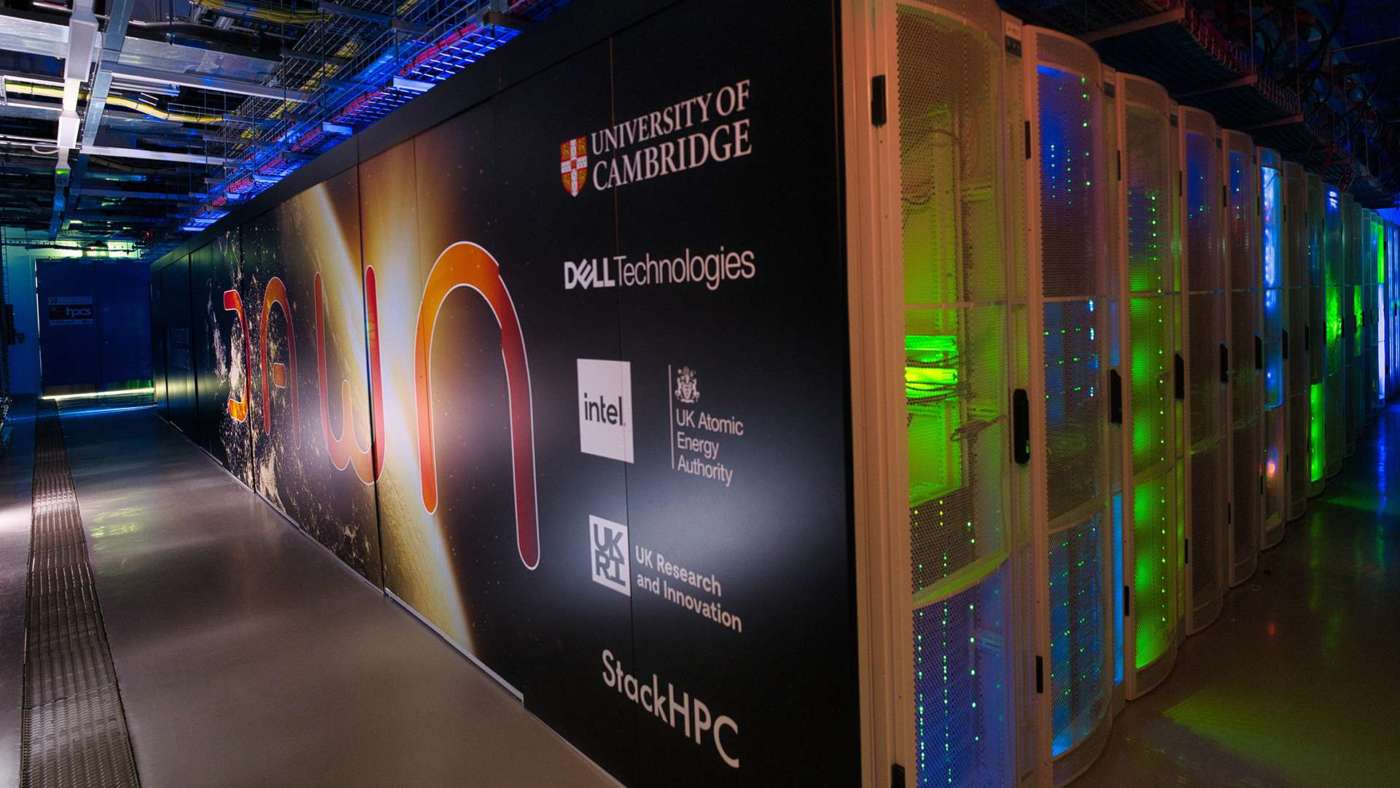

Quando si tratta di consumi energetici, utilizzare la soluzione giusta per il lavoro da svolgere è fondamentale per massimizzare le prestazioni per Watt. Si parte con l’utilizzo di modelli specializzati dedicati che possono essere ottimizzati e inferiti sulle CPU per offrire le giuste prestazioni per Watt con soluzioni AI/DL dedicate basate sulla build di acceleratori per AI/DL come Intel Gaudi2. Intel supporta i propri partner nello sviluppo e nell’implementazione di soluzioni di raffreddamento a liquido diretto per migliorare l’efficienza e ridurre il TCO rispetto ai tradizionali sistemi raffreddati ad aria. Un esempio: Dawn Phase 1, il supercomputer AI più veloce del Regno Unito oggi, che utilizza processori Intel Xeon Scalable di quarta generazione e le GPU Intel Max series, è basato su server Dell PowerEdge XE9640 con raffreddamento a liquido diretto e porterà progressi significativi nello sviluppo dell’energia di fusione verde e modellistica climatica.

Intel si aspetta un mercato crescente per le proprie CPU dedicate all’AI anche al di fuori del mercato data center tradizionali, o questi ultimi sono destinati a rimanere gli ambienti più rilevanti?

Di nuovo, la possibilità scelta è fondamentale per il nostro obiettivo di portare l’intelligenza artificiale ovunque. È possibile utilizzare Xeon per ottimizzare e dedurre modelli specializzati con la flessibilità di Xeon e le prestazioni DL integrate di una tecnologia di accelerazione AI come AMX (in Intel Xeon di quarta generazione). Se si esaminano gli ultimi risultati dei benchmark MLPerf Training 3.1 di novembre, Intel rimane l’unico fornitore di CPU a inviare risultati MLPerf per diversi benchmark AI come BERT, DLRM e ResNet50 in esecuzione su Xeon di quarta generazione.

Vediamo molta intelligenza artificiale nel cloud: fornisce un’enorme capacità di elaborazione scalabile e la capacità di creare rapidamente nuove esperienze. Tuttavia, esistono alcune limitazioni con il modello cloud, quindi prevediamo che alcuni di questi carichi di lavoro vengano spostati sul client. Ci sono ragioni di privacy e altre come la latenza, la personalizzazione o la capacità di sfruttare l’intelligenza artificiale generativa offline.

Trasformare l’esperienza d’uso del PC, passando dall’utilizzo dell’AI solo in applicazioni quali la collaborazione video o gli effetti audio, arriveremo a un punto in cui l’intelligenza artificiale diventerà più contestuale e capirà cosa sta facendo l’utente. La GenAI è la tendenza in voga e tutti abbiamo sentito parlare di applicazioni come ChatGPT e di funzionalità come la stable diffusion; in prospettiva ci aspettiamo di vedere assistenti creativi, produttivi, contenutistici e altro ancora.

In Intel avevamo previsto questa crescita nell’utilizzo dell’intelligenza artificiale sui PC e abbiamo sviluppato la nostra strategia cliente per guidare questa trasformazione dell’intelligenza artificiale e fornire esperienze di intelligenza artificiale su larga scala. In una delle nostre future architetture CPU client, Intel Core Ultra – nome in codice precedente “Meteor Lake”, offriamo nuove e migliorate esperienze basate sull’intelligenza artificiale con la potenza combinata di CPU, GPU e soprattutto della nuova NPU (Neural Processing Unit), integrata come motore AI dedicato a basso consumo, per AI e AI offload prolungati. Questo si aggiunge al fatto che la CPU è ideale per attività di intelligenza artificiale a bassa latenza e inferenza leggera e la GPU integrata è un’ottima scelta per l’intelligenza artificiale infusa nella pipeline multimediale/3D/rendering.

L’immagine qui sotto può essere utile per illustrare le opzioni HW: